Robot Theory of Mind: Die Vorstufe zur KI-Empathie?

Ein Roboter sagt das Verhalten eines anderen vorher. Ist das der Beginn der Maschinen-Empathie?

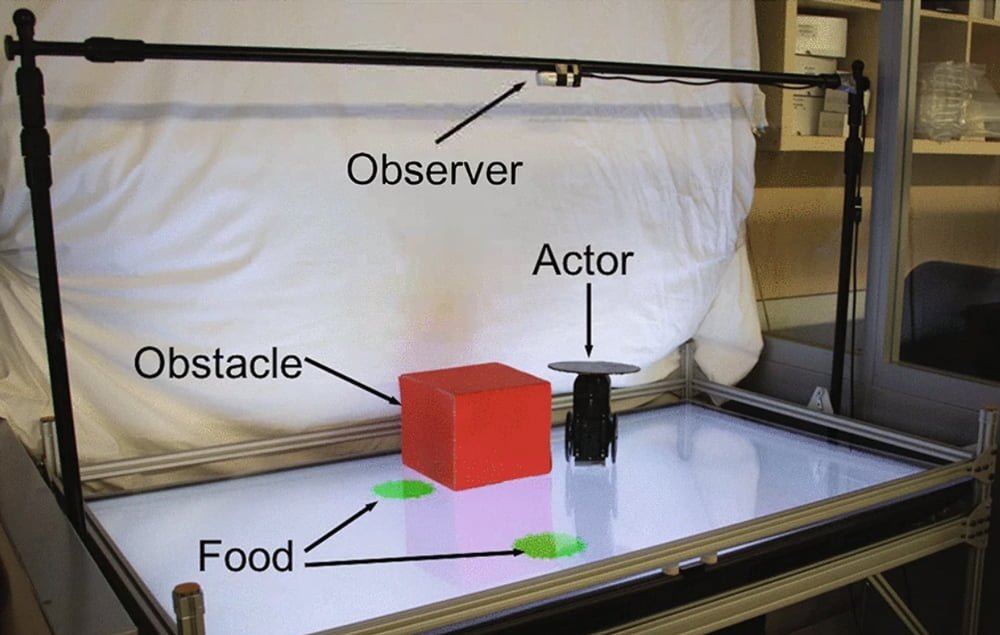

KI-Forscher des "Creative Machines Lab" der Columbia Universität New York haben einen Roboter gebaut, der vorhersagen kann, wie sich ein anderer Roboter verhalten wird. Das zeige einen Schimmer von Empathie, so die Forscher.

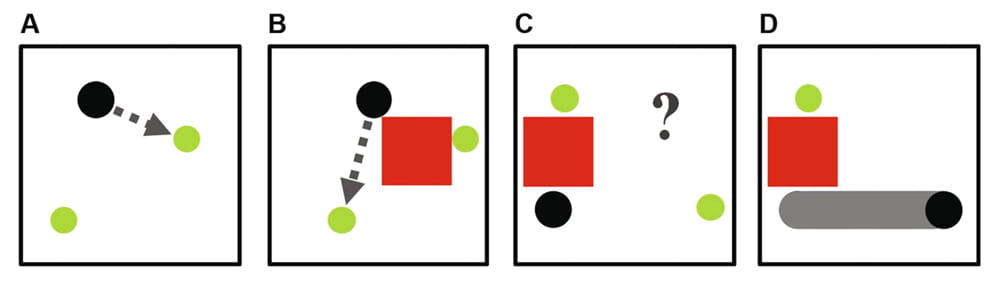

Der Beobachter-Roboter überwacht aus der Vogelperspektive einen einfachen Roboter und versucht, dessen nächste Aktion anhand der ersten Bilder einer Videoaufnahme vorherzusagen: Der einfache Roboter bewegt sich über einen Tisch und fährt zu einem grünen Punkt.

Dabei zeigt er unterschiedliche Verhaltensweisen: Mal nimmt er den direkten Kurs, mal fährt er im Zick Zack und dann wieder mit Rechtskurve. In einem weiteren Fall kann ein Hindernis zwischen dem nahe gelegensten grünen Punkt und dem Roboter liegen. Dann fährt der Roboter zu dem grünen Punkt, den er direkt erreichen kann. Das programmierte Verhalten soll ein Sichtfeld simulieren.

Der Beobachter-Roboter wird von einem neuronalen Netz angetrieben, das mit 2.400 Input-Output-Videoschnipseln trainiert wurde. Diese bestehen aus den ersten Bildern einer Videoaufnahme des Verhaltens des überwachten Roboters und dem letzten Bild, auf dem der Roboter sein Ziel erreicht hat. So lernt der Beobachter-Roboter, das Verhalten des überwachten Roboters mit einer hohen Genauigkeit jenseits von 96 Prozent vorherzusagen.

Im Kern handelt es sich hier also um eine Videovervollständigung. Was hat das mit Empathie zu tun?

(Robot) Theory of Mind

Die Forscher spekulieren, dass es sich bei der Vorhersagefähigkeit des Roboters um eine Vorstufe der sogenannten „Theory of Mind“ (kurz: ToM) handeln könnte. Die ToM-Theorie ist eine der vorherrschenden Theorien, um gewisse mentale Fähigkeiten von Menschen und mutmaßlich einigen wenigen hohen Säugern zu erklären, darunter die Fähigkeiten, effizient zu lernen, zu kooperieren, zu konkurrieren, empathisch zu handeln und andere zu täuschen.

Menschen entwickeln ab dem dritten Lebensjahr die Vorstellung, dass andere Lebewesen ebenfalls über ein mentales Innenleben verfügen. Dass wir davon ausgehen, dass andere Wesen ebenfalls denken, fühlen und handeln, könnte die oben genannten Fähigkeiten überhaupt erst hervorbringen. Varianten der Theory of Mind versuchen dieses Phänomen mit Simulationsfähigkeiten des Gehirns, spezialisierten ToM-Modulen im Gehirn oder einer empirischen Theoriebildung zu erklären.

In der Verhaltensforschung gibt es eine Reihe von Experimenten, mit denen die durch die ToM erklärten Fähigkeiten untersucht werden können. Ein häufig genutztes Experiment läuft ungefähr so ab: Ein Kind beobachtet einen anderen Menschen, wie er einen Ball unter einen von zwei Eimern legt und anschließend den Raum verlässt.

Ein anderer Mensch tritt ein, nimmt den Ball aus dem Versteck und legt ihn unter den anderen Eimer. Anschließend tritt die erste Person wieder ein. Wo sucht sie nach dem Ball?

Um die Frage richtig zu beantworten, muss das Kind erkennen, dass die erste Person nicht sehen konnte, wie der Ball umsortiert wurde. Kinder unter drei Jahren können das nicht und sagen voraus, dass die erste Person unter dem neuen Eimer schaut.

Kinder ab dem dritten Lebensjahr sagen in den meisten Fällen korrekt voraus, dass die erste Person unter den ersten Eimer schaut, wo sie den Ball ursprünglich platziert hat.

Visuelle Vorhersage von Verhalten als erster Baustein einer maschinellen Theory of Mind

Diese Fähigkeiten setzen also nach der ToM eine mentale Entwicklung voraus, die aktuelle KI-Systeme noch lange nicht erreicht haben. Die KI-Forscher wollen jedoch mit ihrem Experiment zeigen, dass die Grundlagen der von der ToM erklärten Fähigkeiten auch von einem simplen neuronalen Netz entwickelt werden können.

In diesem Fall: die visuelle Vorhersage einfacher Verhaltensweisen. Experimente zeigen, dass bereits wenige Wochen alte Neugeborene diese Fähigkeit mit gewissen Einschränkungen besitzen.

Tatsächlich ist diese „Visual Theory of Behavior“, wie sie die Forscher nennen, auch Teil einer möglichen Erklärung für bestimmte Verhaltensweisen in der Natur, etwa bei Vögeln, die ihre Nahrung vor ihren Artgenossen verstecken. Statt gleich eine Theory of Mind für Rabenvögel zu entwickeln, kann das Verhalten auch mit der Fähigkeit erklärt werden, den Sichtkegel der Artgenossen vorherzusehen in Verbindung mit der Erfahrung, Nahrung an diese zu verlieren.

Roboter-Experiment: Kein Schimmer von Empathie

Weitere Experimente müssen zeigen, ob die Fähigkeit zur Videovorhersage und die zur visuellen Verhaltensvorhersage tatsächlich identisch sind. Die Forscher wollen die Untersuchungen fortführen, etwa mit einem Roboter, der keine Vogelperspektive und dadurch weniger perfekte Informationen hat. Außerdem sind Experimente mit mehreren miteinander interagierenden, simplen Robotern geplant.

Um zur Ausgangsfrage zurückzukehren: Sprechen die Forscher im Kontext ihres Experiments zu Recht von einer zumindest rudimentären Empathie?

Das KI-Experiment zeigt im besten Fall, dass simple Verhaltensvorhersagen auf Basis visueller Beobachtungen möglich sind - nicht mehr und nicht weniger. Damit würde es zwar deutlich machen, dass nicht hinter jeder Vorhersage der Handlungen eines Akteurs ein komplexes Verständnis der Relation zwischen Welt und mentalem Innenleben des Gegenübers steckt.

Diese einfache Erkenntnis jedoch einen “Schimmer von Empathie” zu nennen, mag gut für die Wirkung in der Öffentlichkeit sein, hat aber nichts mit dem menschlichen Verständnis von Empathie zu tun. Das Experiment der KI-Forscher beweist daher eher das Gegenteil: dass es für eine visuelle Vorhersage einfacher Verhaltensweisen gerade keine Empathie benötigt.

Via: Nature

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.