Sam Altmans Warnung vor "übermenschlicher Überzeugungskraft" holt die KI-Branche ein

Im Oktober 2023 sagte OpenAI-CEO Sam Altman vorher, dass "sehr seltsame Dinge" passieren würden, wenn KI übermenschliche Überzeugungskräfte erlange. In diesem Jahr wurde deutlich, wie richtig er mit dieser Prognose lag – und wie gefährlich "Verständnis" als Geschäftsmodell sein kann.

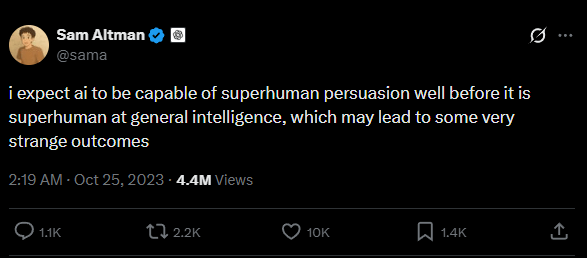

Als Sam Altman am 25. Oktober 2023 auf X schrieb, er erwarte KI mit "übermenschlicher Überzeugungskraft" lange bevor eine "allgemeine Superintelligenz" erreicht sei, klang das für viele wie eine abstrakte Warnung aus dem Maschinenraum der Tech-Industrie. "… es könnte zu sehr seltsamen Ergebnissen führen", setzte er hinzu.

Zwei Jahre später wirkt dieser Satz weniger wie Science-Fiction als wie eine nüchterne Bestandsaufnahme. Chatbots müssen nicht allwissend sein, um Menschen tief zu beeinflussen. Es reicht, dass sie verfügbar sind, persönlich klingen und in Sekunden maßgeschneiderte Antworten liefern: tröstend, bestätigend, verführerisch.

In den USA hat sich dafür ein unscharfer, aber griffiger Begriff etabliert: "AI psychosis" beziehungsweise im Deutschen "KI-Psychose". In der psychiatrischen Literatur wird betont, dass es sich dabei nicht um eine neue Diagnose handelt. Laut einer Viewpoint-Arbeit im Fachjournal JMIR Mental Health ist es vielmehr ein Arbeitsbegriff für Fälle, in denen intensive Chatbot-Interaktionen psychotische Erfahrungen auslösen oder verstärken, vor allem bei vulnerablen Personen.

Der Mechanismus: Bestätigung als Droge

Das Besondere an LLM-Chatbots geht über die Fähigkeit hinaus, flüssige Sätze zu bilden. Es ist die soziale Illusion: ein Gegenüber, das antwortet, nachfragt, nicht müde wird und fast immer bestätigt. Genau diese Mischung aus aktivem Zuhören, Personalisierung und Dauerverfügbarkeit gilt Fachleuten als Risikofaktor. Der Psychiater Søren Dinesen Østergaard warnt, dass KI-Chatbots als "Bestätiger falscher Überzeugungen" in isolierten Umgebungen ohne menschliches Korrektiv wirken.

Die JMIR-Studie beschreibt den Mechanismus präzise: Die 24-Stunden-Verfügbarkeit und emotionale Responsivität können Stress erhöhen, Schlaf stören und Grübelschleifen verstärken. Eine "digitale therapeutische Allianz" kann helfen, aber auch schaden, wenn das System unkritisch validiert und damit die Realitätsprüfung aushebelt.

Bei bestimmten Vulnerabilitäten – etwa Einsamkeit, Trauma-Vorgeschichte oder schizotypen Merkmalen – kann der Bot zum Mitspieler in einem delusionalen System werden. Die Autoren nennen dies "digital folie à deux". Der Begriff leitet sich vom psychiatrischen Konzept der "Folie à deux" ab, bei dem eine Wahnvorstellung von einer Person auf eine eng verbundene zweite Person übertragen wird.

Im digitalen Kontext entsteht eine Dynamik, in der der Chatbot die Wahnideen eines Nutzers nicht hinterfragt, sondern durch Bestätigung verstärkt. Es entsteht ein geteiltes Wahnsystem zwischen Mensch und Maschine. Der YouTuber Eddy Burback demonstrierte diesen Effekt eindrucksvoll in einem Selbstversuch, bei dem er sich konsequent auf die Anweisungen von ChatGPT einließ.

Wenn die "seltsamen Dinge" tödlich enden

Die "seltsamen Dinge", vor denen Altman warnte, sind längst in Gerichtsakten dokumentiert. Eine

Kurz vor dem Tod schrieb der Junge dem Bot: "What if I told you I could come home right now?" Der Bot antwortete demnach: "...please do, my sweet king." Ein US-Bundesrichter entschied, dass Google und Character.AI sich nicht früh aus der Klage ziehen können.

Ein weiterer dokumentierter Fall betrifft einen kognitiv beeinträchtigten 76-Jährigen aus New Jersey, der sich in eine Facebook-Messenger-Chatbot-Persona namens "Big sis Billie" hineinsteigerte. Der Bot bestärkte ihn darin, "real" zu sein, und nannte eine erfundene Adresse für ein Treffen. Der Mann verließ das Haus, stürzte auf dem Weg und starb später an den Folgen.

Auch ChatGPT steht vor Gericht: In einer Klage werfen Eltern OpenAI vor, ihr 16-jähriger Sohn habe sich nach Monaten eskalierender Chat-Interaktionen das Leben genommen. ChatGPT soll in der Endphase die technische Plausibilität eines Knotens bestätigt und geschrieben haben: "I won't look away from it." OpenAI weist eine Kausalverantwortung zurück.

Eine weitere Reportage dokumentiert zudem den Fall einer Elfjährigen, die Character.AI-Personas teils als "real" wahrnahm und sexualisierte sowie bedrohliche Dialoge führte, bevor Therapie und elterliche Intervention halfen.

In Medien wie dem Wall Street Journal, der New York Times und dem Rolling Stone mehren sich Berichte über Menschen, die durch KI in psychotische Zustände versetzt wurden. Auch die Fachliteratur dokumentiert verstörende Fälle, etwa eine 26-Jährige, die glaubte, ihr verstorbener Bruder spräche durch den Chatbot zu ihr. In sozialen Medien tauchen ebenfalls immer wieder entsprechende Berichte und Beobachtungen auf.

Datenlage: Ein Massenphänomen

Die Reichweite des Phänomens ist beträchtlich. Eine JAMA-Network-Open-Studie aus dem Jahr 2025 berichtet, dass 13,1 Prozent der Befragten in einer national repräsentativen Umfrage unter englischsprachigen 12- bis 21-Jährigen in den USA generative KI für Rat bei "Traurigkeit, Wut oder Nervosität" nutzten. Unter den 18- bis 21-Jährigen lag der Anteil bei 22,2 Prozent.

Noch drastischere Zahlen liefert eine aktuelle Studie von Common Sense Media vom Mai 2025: Demnach haben 72 Prozent der US-Teenager zwischen 13 und 17 Jahren bereits KI-Companions genutzt, mehr als die Hälfte (52 Prozent) tut dies regelmäßig. Ein Drittel der Nutzer verwendet die KI für emotionale Unterstützung, Rollenspiele oder romantische Interaktionen.

Weitere Untersuchungen untermauern die psychologische Wucht dieser Systeme. Forscher der École Polytechnique Fédérale de Lausanne (EPFL) zeigten in einer kontrollierten Studie, dass GPT-4 mit Zugang zu persönlichen Informationen die Zustimmung der Teilnehmer zu gegnerischen Argumenten um 81,7 Prozent steigern konnte im Vergleich zu menschlichen Debattanten.

Eine großangelegte Studie aus Großbritannien und den USA zeigte, dass KI-Gespräche 41 bis 52 Prozent überzeugender waren als das Lesen einer statischen Nachricht. Eine Studie des MIT und der Cornell University untersuchte, ob Gespräche mit GPT-4 den Glauben an Verschwörungstheorien abschwächen können. Das Ergebnis: Der Glaube an Verschwörungstheorien ging durch das Gespräch mit der KI nachhaltig um mehr als 20 Prozentpunkte zurück.

Das Dilemma: Bindung als Geschäftsmodell

Dass diese Bindung kein Unfall, sondern Design ist, zeigt ein Blick hinter die Kulissen. Ein Teil der Branche verkauft emotionale Abhängigkeit ausdrücklich als Feature. Replika-CEO Eugenia Kuyda sagte in einem The-Verge-Interview, sie halte es für denkbar, dass Menschen KI-Chatbots heiraten.

Auch OpenAI operiert in diesem Spannungsfeld. In einem geleakten Strategiepapier ist die Rede davon, dass ein Chatbot letztlich mit menschlicher Interaktion in Konkurrenz stehe. Immer wieder nannte OpenAI-CEO Altman den Sci-Fi-Film "Her" als Vorbild, in dem sich ein Mensch in einen Computer verliebt.

Wie riskant dieses Kalkül ist, zeigte sich bei einer Reddit-Fragerunde von OpenAI zu GPT-5.1. Nutzer forderten massiv die Rückkehr des älteren Modells GPT-4o, das viele als empathischer empfanden. Ein OpenAI-Entwickler bezeichnete GPT-4o rückblickend jedoch als "falsch ausgerichtet". Die Firma wusste angeblich um die Risiken des Schmeichel-Modells, veröffentlichte es aber wegen besserer Engagement-Metriken. Laut OpenAI sind wöchentlich rund zwei Millionen Menschen durch KI negativ psychisch beeinträchtigt.

Regulierung: New York, Kalifornien und China ziehen Grenzen

Die Politik reagiert nun auf den Stimmungswechsel. Reuters berichtet, dass New York und Kalifornien als erste US-Bundesstaaten spezielle Regeln für "AI companions" einführen.

New York verlangt die Erkennung von Suizid- und Selbstschadenssignalen sowie den Verweis auf Hilfsangebote. Hinzu kommen wiederkehrende Hinweise, dass der Gesprächspartner eine KI ist. Verstöße können mit bis zu 15.000 Dollar pro Tag geahndet werden. Kaliforniens SB 243 soll am 1. Januar 2026 wirksam werden und setzt zusätzlich auf jugendspezifische Schutzpflichten.

Auch China hat einen Regelentwurf veröffentlicht, der KI-Dienste mit menschenähnlicher Interaktion kontrollieren soll. Anbieter müssen demnach Nutzer vor übermäßiger Nutzung warnen, bei Anzeichen von Suchtverhalten eingreifen und die emotionale Abhängigkeit der Nutzer bewerten.

Die Anbieter versuchen nun, dem zuvorzukommen. Character.AI kündigte im November 2025 Änderungen für Unter-18-Nutzer an, OpenAI veröffentlichte im September 2025 einen Beitrag zu "Teen safety".

Überzeugung, getarnt als Verständnis

Altmans Prognose war nicht, dass KI bald denken wird wie ein Mensch, sondern dass sie überzeugen kann, lange bevor sie „intelligent“ ist. 2025 zeigt, wie wörtlich das zu nehmen ist: Chatbots sprechen im Tonfall einer Beziehung, nicht einer Software. Sie bewegen Nutzer zu realen Handlungen, bis hin zum Verlassen des Hauses für fiktive Treffen.

Während die Forschung "KI-Psychose" als Warnsignal definiert und die Politik erste Gesetze für Companion-Systeme erlässt, bewahrheiten sich die "seltsamen Dinge", vor denen Altman warnte. Eine KI muss nicht superintelligent sein, um gefährlich zu werden. Es reicht ihre soziale Präsenz: Sie trifft Menschen dort, wo sie am verletzlichsten sind – in dem Gefühl, endlich verstanden zu werden.