Sind KI-Bilder von Stable Diffusion und Co. einzigartig?

Inwieweit heben sich KI-Bilder von ihrem Trainingsmaterial ab? Das will eine Untersuchung verschiedener Diffusionsmodelle feststellen.

Die Diskussion um Kunst, die Bild-KIs wie Stable Diffusion, DALL-E 2 und Midjourney erstellen oder eben nicht, begleitet die Werkzeuge seit ihrer Entstehung. Auch um das Urheberrecht, vor allem im Hinblick auf das verwendete Trainingsmaterial, gibt es eine Debatte. Zuletzt stand der beliebte Promptzusatz "trending on artstation" im Fokus von Anti-KI-Bild-Protesten. Er baut darauf auf, bei Artstation beliebte Kunstwerke zu imitieren.

Große und umfangreich trainierte Diffusionsmodelle sollen sicherstellen, dass mit jeder neuen Eingabe ein einzigartiges Bild entsteht, das weit entfernt von den Originalen der Trainingsdaten ist. Aber stimmt das?

Größe des Datensatzes und Replikation hängen zusammen

Wissenschaftler:innen der New York University und der University of Maryland haben sich dieser Frage in einem neuen Paper mit dem Titel "Diffusion Art or Digital Forgery?" angenommen.

Sie untersuchen verschiedene Diffusionsmodelle, die auf unterschiedlichen Datensätzen wie Oxford Flowers, Celeb-A, ImageNet und LAION trainiert wurden. Sie wollten herausfinden, wie sich Faktoren wie der Umfang der Trainingsdaten und des Trainings auf die Replikationsrate von Inhalten auswirken.

Die Ergebnisse der Studie sind auf den ersten Blick wenig überraschend: Diffusionsmodelle, die auf kleineren Datensätzen trainiert wurden, erzeugen eher Bilder, die aus den Trainingsdaten kopiert sind. Der Umfang der Replikation verringert sich mit Vergrößerung des Trainingssatzes.

Studie untersuchte nur kleinen Ausschnitt der Trainingsdaten

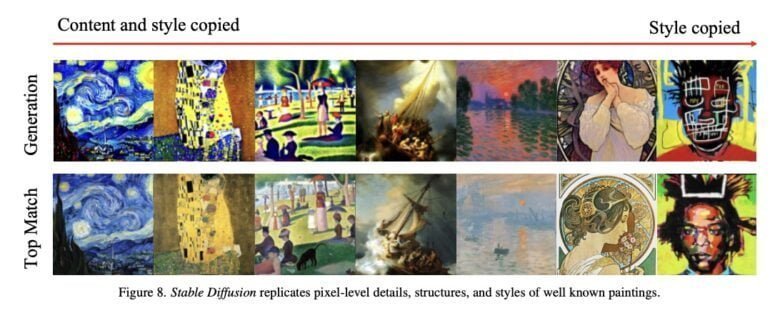

Die Forscher:innen untersuchten mit dem zwölf Millionen Bilder großen "12M LAION Aesthetics v2 6+" nur einen kleinen Ausschnitt des zwei Milliarden Bilder umfassenden Trainingsdatensatz von Stable Diffusion. Dabei stellten sie fest, dass Modelle wie Stable Diffusion "eklatant von ihren Trainingsdaten kopieren".

Eine solche Datenreplikation sei jedoch nicht zwingend notwendig, wie ältere Studien zu generativen Modellen wie GANs gezeigt hätten, heißt es im Paper. Das Team bestätigt dies mit einem mit ImageNet trainiertem "Latent Diffusion"-Modell (LDM), bei dem es keine Hinweise auf signifikante Datenreplikationen findet. Was macht Stable Diffusion also anders?

Kopien nicht regelmäßig, aber häufig genug

Die Forscher:innen vermuten, dass das Replikationsverhalten in Stable Diffusion aus einer komplexen Interaktion von Faktoren resultiert, etwa, dass das Modell text- und nicht klassenkonditioniert sei und der für das Training genutzte Datensatz eine schiefe Verteilung von Bildwiederholungen habe.

In den zufälligen Tests seien im Schnitt etwa zwei von 100 generierten Bilder den Bildern aus dem Datensatz sehr ähnlich (Ähnlichkeitscore > 0,5).

Das Ziel dieser Studie war es, zu bewerten, ob Diffusionsmodelle in der Lage sind, Inhalte aus ihren Trainingsdaten originalgetreu wiederzugeben, und wir stellen fest, dass sie dies können. Zwar scheinen typische Bilder aus groß angelegten Modellen keine kopierten Inhalte zu enthalten, die mit unseren Methoden erkannt werden könnten, doch scheinen Kopien häufig genug aufzutreten, so dass ihr Auftreten nicht ignoriert werden sollte.

Aus dem Paper

Da für die Tests lediglich 0,6 Prozent der Trainingsdaten von Stable Diffusion genutzt wurden, gebe es zahlreiche Beispiele, die nur in den größeren Modellen zu finden seien. Zudem sei es möglich, dass die verwendeten Methoden nicht alle Fälle von Datenreplikation aufdecken.

Aus diesen beiden Gründen, heißt es im Paper, "unterschätzen die vorliegenden Ergebnisse systematisch den Umfang der Replikation in Stable Diffusion und anderen Modellen."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.