Snaps SnapGen++ generiert hochauflösende KI-Bilder in unter zwei Sekunden direkt auf dem iPhone

Kurz & Knapp

- Snap Inc. hat mit SnapGen++ einen kompakten Diffusion Transformer entwickelt, der hochauflösende Bilder in unter zwei Sekunden direkt auf Smartphones generiert.

- Das Modell verwendet erstmals eine Architektur, die bislang großen Server-Modellen vorbehalten war.

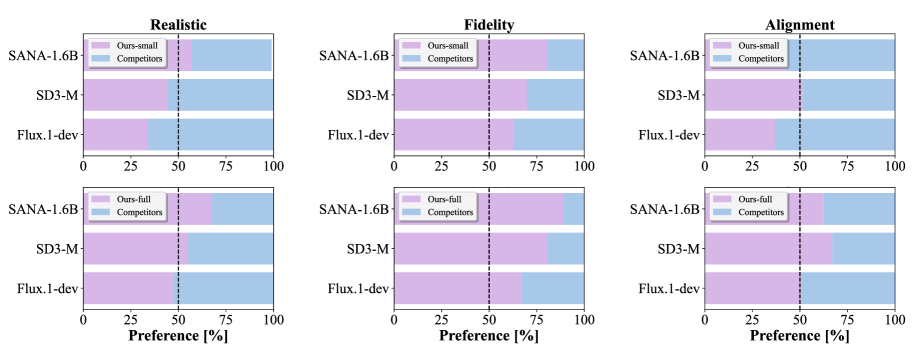

- Das kleine Modell übertrifft in Tests zur Bildqualität deutlich größere Konkurrenten wie Flux.1-dev und Stable Diffusion 3.5, obwohl diese bis zu 30-mal mehr Parameter haben.

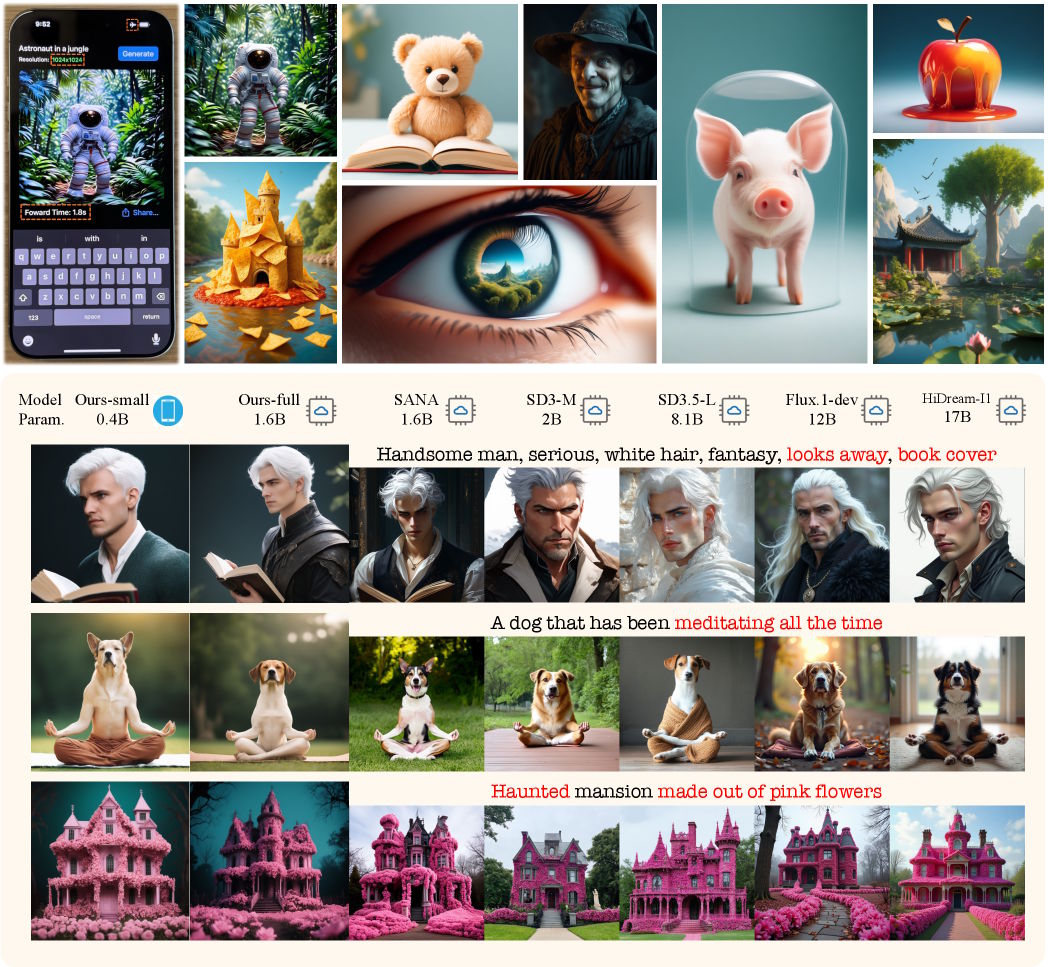

Mit SnapGen++ stellt der Snapchat-Konzern einen kompakten Diffusion Transformer vor, der Text-zu-Bild-Generierung in Serverqualität auf mobilen Endgeräten ermöglicht. Das 0,4-Milliarden-Parameter-Modell übertrifft dabei deutlich größere Konkurrenten.

Der Snapchat-Mutterkonzern Snap Inc. hat einen effizienten Diffusion Transformer entwickelt, der hochauflösende Bilder direkt auf Smartphones generieren kann. Laut dem Forschungspapier erzeugt das Modell namens SnapGen++ Bilder mit 1024 × 1024 Pixeln in nur 1,8 Sekunden auf einem iPhone 16 Pro Max.

Während bisherige On-Device-Modelle wie SnapGen auf U-Net-Architekturen setzten, nutzt SnapGen++ erstmals die leistungsfähigere Diffusion Transformer-Architektur für Smartphones. Diese Architektur liegt auch großen Servermodellen wie Flux und Stable Diffusion 3 zugrunde, war bisher aber aufgrund ihres enormen Rechenbedarfs nicht für mobile Geräte geeignet.

Diffusion Transformer gelten als Meilenstein in der Bildgenerierung, weil sie die Stärken der Transformer-Architektur – insbesondere das präzise Verständnis komplexer Textprompts und die bessere Skalierbarkeit – mit dem bewährten Diffusionsprinzip verbinden und so deutlich kohärentere und detailreichere Bilder erzeugen als ihre U-Net-basierten Vorgänger.

Sparsame Architektur ermöglicht mobile Nutzung

Das zentrale Problem bei Diffusion Transformern ist jedoch ihr enormer Rechenbedarf, der mit steigender Bildauflösung quadratisch wächst. Das Team löst dieses Problem durch eine neuartige Attention-Methode, die den Rechenaufwand drastisch reduziert.

Statt alle Bildregionen gleichzeitig zu verarbeiten, kombiniert das Modell eine grobe Gesamtübersicht mit feinen lokalen Details. Durch diese Architektur sinkt die Latenz pro Inferenzschritt von 2000 Millisekunden auf unter 300 Millisekunden, ohne dass die Generierungsqualität leidet.

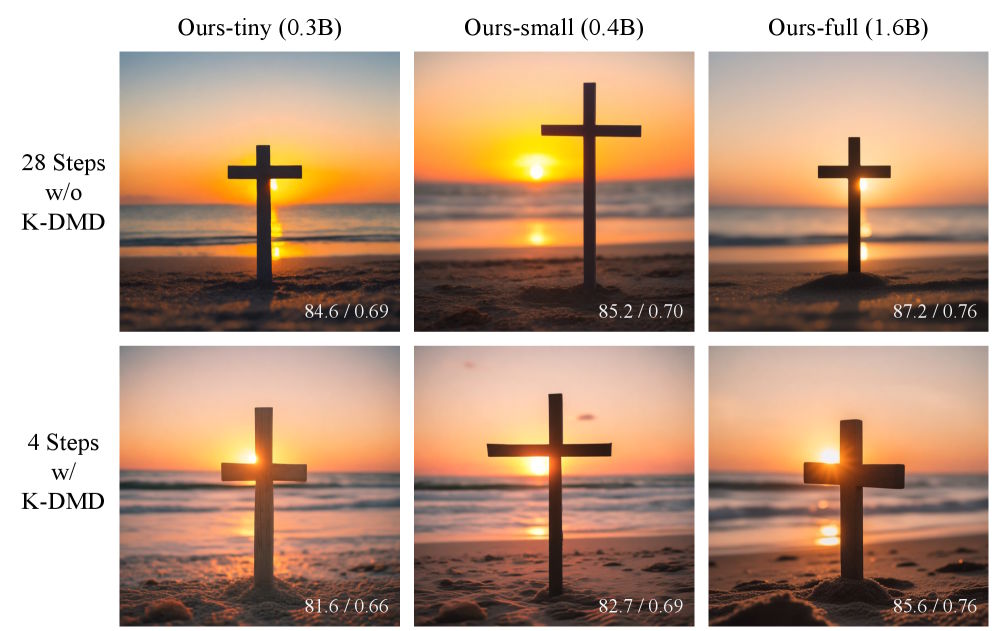

Eine weitere Innovation ist das sogenannte Elastic Training. Aus einem einzigen Trainingslauf entstehen drei Modellvarianten: ein Tiny-Modell mit 0,3 Milliarden Parametern für günstige Android-Geräte, ein Small-Modell mit 0,4 Milliarden für High-End-Smartphones und ein Full-Modell mit 1,6 Milliarden Parametern für Server oder quantisierte On-Device-Nutzung.

Die Varianten teilen sich Parameter und werden gemeinsam optimiert. Dieser Ansatz ermöglicht laut den Autoren eine nahtlose Anpassung an unterschiedliche Hardware, ohne separate Modelle trainieren zu müssen.

Kompaktes Modell übertrifft große Konkurrenz

In mehreren Benchmarks zeigt SnapGen++ gute Ergebnisse. Die Small-Variante mit 0,4 Milliarden Parametern übertrifft in den Tests zur Bildqualität und Text-Bild-Übereinstimmung durchweg das 30-mal größere Flux.1-dev mit 12 Milliarden Parametern. Auch SD3.5-Large mit 8,1 Milliarden Parametern schneidet schlechter ab als das größte Snap-Modell.

Für die effiziente On-Device-Generierung entwickelte das Team eine spezielle Destillationsmethode. Sie ermöglicht eine Reduktion von 28 auf nur vier Inferenzschritte bei nahezu gleichbleibender Qualität. Die Gesamtlatenz auf dem iPhone 16 Pro Max beträgt für die Small-Variante etwa 1,8 Sekunden bei vier Inferenzschritten.

On-Device-KI als wachsendes Forschungsfeld

Snap hatte zuvor bereits mit SnapGen einen U-Net-basierten Ansatz für On-Device-Bildgenerierung vorgestellt, der 1024-Pixel-Bilder auf Smartphones ermöglichte, jedoch qualitative Einschränkungen gegenüber großen Servermodellen aufwies.

Auch andere Unternehmen wie Google arbeiten an effizienten Diffusionsmodellen für mobile Geräte. SnapGen++ ist jedoch laut dem Forschungspapier das erste Projekt, das einen effizienten Diffusion Transformer für hochauflösende On-Device-Generierung demonstriert.

Der Snapchat-Konzern investiert seit Längerem in KI-Funktionen für seine Messaging-App. Neben dem hauseigenen Chatbot "My AI" kündigte Snap im November 2024 eine Partnerschaft mit Perplexity AI über 400 Millionen US-Dollar an. Die KI-Suchmaschine soll dieses Jahr standardmäßig in Snapchat integriert werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren