So klingt es, wenn eine KI Hirnsignale in Sprache umwandelt

Künstliche Intelligenz soll in von Gehirn-Elektroden gesammelten Daten Sprachmuster identifizieren und erklingen lassen.

Eine besondere Herausforderung bei diesem Unterfangen ist die limitierte Datenmenge: Gehirnaktivitäten müssen parallel zur Sprachverarbeitung gemessen werden.

Das klappt nur bei Menschen, die kurzfristig Elektroden implantiert bekommen - beispielsweise während einer Tumoroperation oder bei Untersuchungen wegen Epilepsie.

Auf Sprachmustersuche in Hirnsignalen

Die Computerwissenschaftlerin Nima Mesgarani von der Columbia Universität und ihr Team sammelten Hirnsignale von fünf an Epilepsie erkrankten Menschen.

Gemessen wurden Aktivitäten des auditiven Kortex, der beim Sprechen und Zuhören aktiv ist, während sich die Probanden Geschichten anhörten und eine Aufzählung der Ziffern Null bis Neun.

Mit diesen Daten trainierten die Forscher ein neuronales Netz. Das Netz analysierte die Muster, in denen sich einzelne Neuronen im Kontext einer Ziffer ein- und ausschalteten.

Nach dem Training war es in der Lage, die Ziffernmuster in den Hirnsignalen wiederzuerkennen und diese in Ton umzuwandeln. Das klingt dann so:

Audio: H. AKBARI ET AL., DOI.ORG/10.1101/350124

Eine Testgruppe konnte die Zahlen mit einer Zuverlässigkeit von circa 75 Prozent verstehen.

Allerdings ist die Mustererkennung laut Mesgarani nicht von einer auf die andere Person übertragbar. Neuronale Netze müssten also für jede einzelne Person neu trainiert werden passend zur individuellen Hirnaktivität.

Außerdem funktioniert das Verfahren derzeit nur mit gesprochenen und nicht mit vorgestellten Worten. Eine Stimmprothese ist so beispielsweise nicht umsetzbar.

Daten sammeln während der Hirn-OP

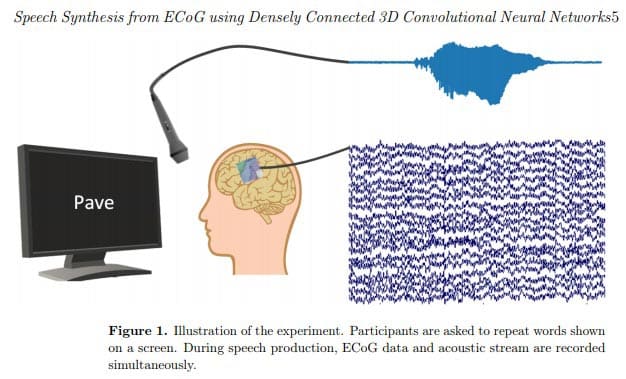

Ein zweites Forscherteam unter der Leitung des Neurowissenschaftlers Miguel Angrick von der Universität Bremen und Christian Herff von der Universität Maastricht trainierte ein neuronales Netz mit Daten von sechs Tumorpatienten, die während einer Hirnoperation gemessen wurden.

Die Patienten mussten einsilbige Worte laut vorlesen. Dabei zeichneten die Elektroden Hirnaktivität im Sprachzentrum und im motorischen Kortex auf, deren Signale direkt an den Sprachtrakt gehen.

Durch die Kombination der Elektrodenwerte mit den Audioaufzeichnungen konnte ein neuronales Netz in bislang unbekannten Hirndaten Wörter erkennen, rekonstruieren und vorlesen. Nach einer maschinellen Analyse sollen 40 Prozent der Wörter verstehbar sein.

Audio: Ein von einer Probandin gesprochenes Wort wird von einem neuronalen Netz wiederholt. M. ANGRICK ET AL., DOI.ORG/10.1101/478644

Quelle: Sciencemag.org

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.