Stable Cascade: Stable-Diffusion-Firma veröffentlicht neues Bildmodell

Stable Cascade ist ein neues Text-zu-Bild-Modell von Stability AI, das jetzt als Research Preview verfügbar ist.

Mit Stable Diffusion ist Stability AI und seinen Partnern ein großer Wurf gelungen: Das Open-Source-Modell hat sich millionenfach verbreitet und bildet die Grundlage für zahlreiche Bildgeneratoren.

Mit Stable Cascade veröffentlicht Stability AI nun eine Forschungsvorschau auf einen möglichen Nachfolger, der mehr Qualität, Flexibilität, Effizienz und eine einfachere Feinabstimmung auf spezifische Stile bieten soll.

Stable Cascade unterstützt Bildvariationen, Bild-zu-Bild-Generierung, Inpainting/Outpainting, Canny Edge-Generierung und 2x Super Resolution.

Benutzer können damit Variationen eines bestimmten Bildes erzeugen, neue Bilder auf der Grundlage vorhandener Bilder erstellen, maskierte Teile eines Bildes füllen, Bilder erzeugen, die den Kanten eines Eingabebildes folgen, und Bilder auf höhere Auflösungen skalieren.

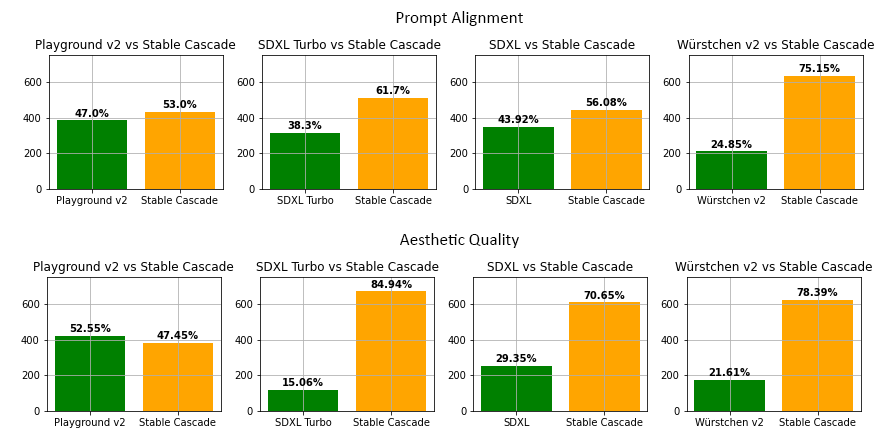

Laut Stability AI übertrifft Stable Cascade in den meisten Modellvergleichen andere Modelle in Bezug auf Prompt-Umsetzung und ästhetische Qualität.

Die Forschungsvorschau ist nur für den nicht-kommerziellen Gebrauch bestimmt. Ob und in welcher Form das endgültige Modell als Open Source verfügbar sein wird, geht aus der Ankündigung nicht hervor. Stability AI bietet eigene Modelle auch über API an.

Benutzer können mit Stable Cascade experimentieren, indem sie auf die Checkpoints, Inferenz-Skripte, Finetuning-Skripte, ControlNet- und LoRA-Trainingsskripte zugreifen, die auf der Stability-GitHub-Seite verfügbar sind. Auf diese Weise kann das Modell an die eigenen Bedürfnisse angepasst werden.

Würstchen für bessere und schnellere KI-Bilder

Stable Cascade basiert auf der im Januar 2024 vorgestellten Würstchen-Architektur. Würstchen ist eine dreistufige diffusionsbasierte Text-Bild-Synthese, die ein stark komprimiertes, aber detailliertes semantisches "Bildrezept" lernt (Stage C), das den Diffusionsprozess (Stage B) steuert.

Laut Stability AI bietet diese kompakte Repräsentation eine viel detailliertere Führung im Vergleich zu latenten Sprachrepräsentationen und reduziert so den Rechenaufwand bei gleichzeitiger Verbesserung der Bildqualität.

Würstchen benötigt so weniger Trainingsressourcen (24.602 A100-GPU-Stunden im Vergleich zu 200.000 GPU-Stunden für Stable Diffusion 2.1) und weniger Trainingsdaten.

Es soll auch deutlich schnellere Generierungszeiten bieten, obwohl es mehr Parameter als das bisherige Spitzenmodell Stable Diffusion XL hat. Stable Cascade benötigt etwa zehn Sekunden für 30 Schritte bis zum fertigen Bild, SDXL liegt bei 50 Schritten und 22 Sekunden. Noch schneller geht es mit SDXL Turbo, das nur einen Schritt und eine halbe Sekunde benötigt, allerdings auf Kosten der Bildqualität.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.