Tencents Bild-KI X-Omni vereint Open-Source-Komponenten zu einem GPT-4o-Konkurrenten

Das Tencent-Team hinter X-Omni zeigt, dass Reinforcement Learning die Schwachstellen von Hybrid-Systemen behebt. Das System rendert recht präzise lange Texte in Bildern und erreicht teilweise neue Bestleistungen.

Rein autoregressive KI-Modelle, die Bilder Token für Token generieren, haben eine fundamentale Schwäche: Kumulative Fehler führen zu niedriger Bildqualität. Deshalb nutzen aktuelle Systeme Hybrid-Ansätze - autoregressive Modelle für semantische Planung und Diffusionsmodelle für die finale Bildgenerierung.

Doch auch diese Hybrid-Systeme haben ein Problem: Die autoregressiv generierten Tokens passen oft nicht zu dem, was der Diffusions-Decoder erwartet. Ein Forschungsteam von Tencent zeigt nun mit X-Omni, wie Reinforcement Learning diese Verteilungslücke schließt.

Einheitliches Reinforcement Learning

X-Omni kombiniert ein autoregressives Modell für semantische Token-Generierung mit dem Diffusionsmodell FLUX.1-dev des deutschen Start-ups Black Forest Labs als Decoder. Der entscheidende Unterschied zu bisherigen Hybrid-Ansätzen liegt im Training: Statt beide Komponenten separat zu trainieren, nutzt X-Omni Reinforcement Learning, um sie aufeinander abzustimmen.

Laut dem Forschungspapier verbessert sich die Bildqualität während des Reinforcement-Learning-Prozesses kontinuierlich und übertrifft nach 200 Trainingsschritten selbst die besten Ergebnisse herkömmlicher Hybrid-Trainingsmethoden deutlich.

Das System generiert autogressiv semantische Tokens, der Diffusions-Decoder erstellt daraus Bilder, und ein Bewertungssystem gibt Feedback zur Qualität. Dadurch lernt das autoregressive Modell, Tokens zu produzieren, die der Decoder besser verarbeiten kann.

Zusätzlich setzt X-Omni auf semantische statt pixelbasierte Tokenisierung. Ein SigLIP-VQ Tokenizer wandelt Bilder in 16.384 verschiedene semantische Tokens um, die Konzepte statt Pixel-Details repräsentieren. Als Grundlage dient das Open-Source-Sprachmodell Qwen2.5-7B des chinesischen Konkurrenten Alibaba, erweitert um spezialisierte Bildverarbeitungsschichten.

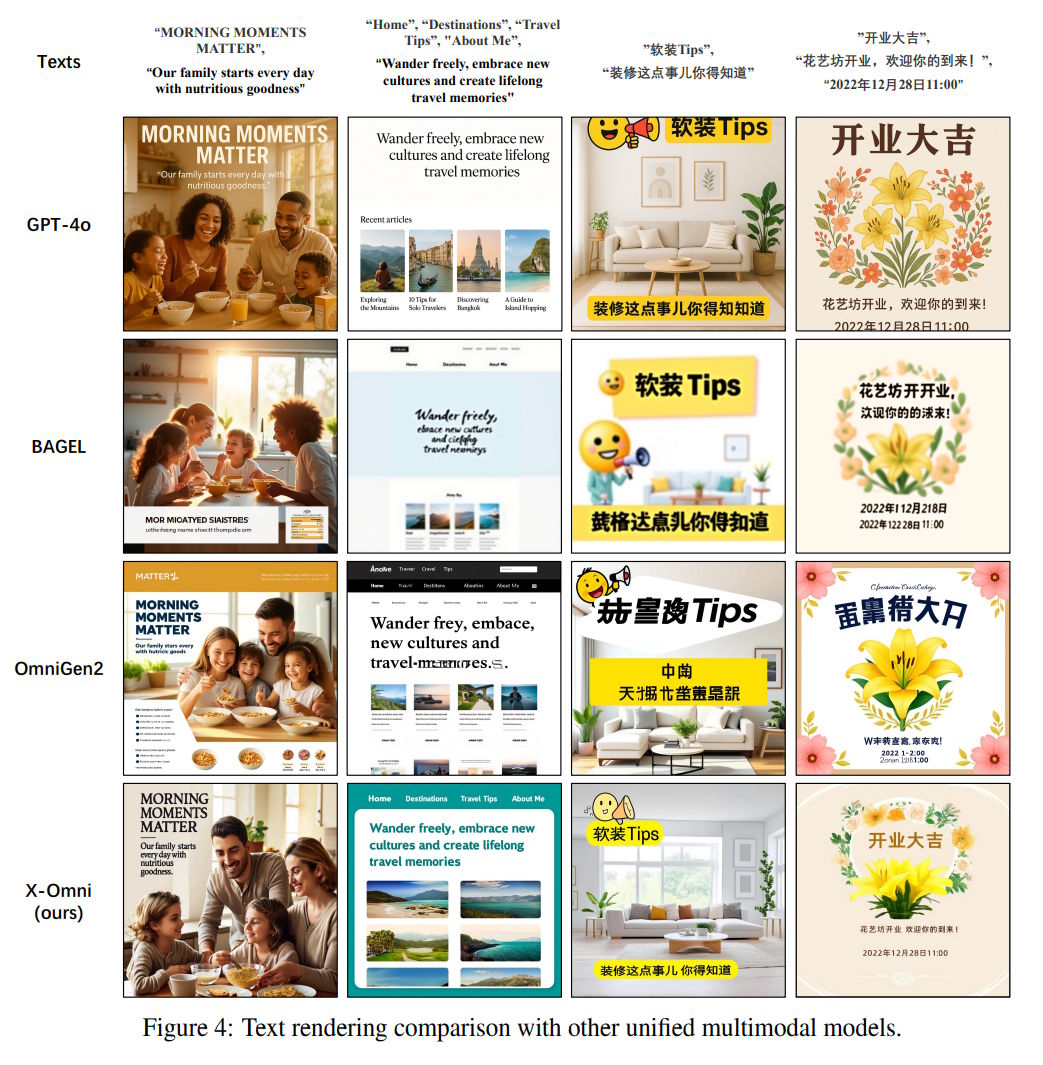

Besonders gute Textdarstellung, aber nicht perfekt

Für das Reinforcement Learning entwickelten die Forschenden ein umfassendes Bewertungssystem: Ein Human Preference Score bewertet die ästhetische Qualität, während ein weiteres Modell speziell hochauflösende Bilder evaluiert. Das Vision-Language-Model Qwen2.5-VL-32B überprüft, ob generierte Bilder den Text-Prompts entsprechen; für die Textgenauigkeit in Bildern kommen die OCR-Systeme GOT-OCR-2.0 und PaddleOCR zum Einsatz.

Besonders bei der Textdarstellung in Bildern zeigt X-Omni Leistungen am oberen Rand. Auf etablierten Benchmarks erreicht es bei englischem Text 0,901 Punkte und übertrifft damit alle vergleichbaren Systeme deutlich. Bei chinesischem Text erzielt es sogar bessere Werte als GPT-4o. Für längere Texte entwickelten die Forscher einen neuen LongText-Benchmark, wo X-Omni besonders bei chinesischen Texten viele Konkurrenten übertrifft.

Bei der allgemeinen Bildgenerierung erreicht X-Omni auf dem standardisierten DPG-Benchmark 87,65 Punkte - der beste Wert unter allen "Unified Models" und sogar leicht besser als GPT-4o. Das System zeigt auch solide Leistungen bei Bildverständnis-Aufgaben und übertrifft beim OCRBench teils spezialisierte Modelle.

Leistungsfähiges Open-Source-Paket

Tencent mag durch das Reinforcement Learning bei X-Omni einen spannenden Ansatz gefunden zu haben, ein wahnsinniger Leistungsdurchbruch lässt sich aus dem Paper jedoch nicht herauslesen. In den Benchmarks liegt das Modell, wenn überhaupt, nur wenige Prozentpunkte vor Alternativen. Neben GPT-4o schneidet außerdem Seedream 3.0 von Bytedance gut ab, das jedoch nur Bilder generieren kann.

Stattdessen ist das KI-System ein Paradebeispiel für die Open-Source-Ökonomie: X-Omni vereint klug mehrere Systeme verschiedener Forschungsteams, sogar solche von Konkurrenten, um ein Modell zusammenzuschnüren, das mit kommerziellen Anbietern wie OpenAI problemlos mithalten kann.

Hier hatte die vor wenigen Monaten eingeführte Bildgenerierung durch GPT-4o mit ihrem Promptverständnis und ihrer Textdarstellung neue Maßstäbe gesetzt. GPT-4o basiert aller Wahrscheinlichkeit ebenfalls auf einer Kombination aus autoregressiver und Diffusions-Architektur.

Tencent stellt X-Omni auf Hugging Face und Github quelloffen zur Verfügung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.