Tinker: Startup von OpenAI Ex-CTO launcht erstes Produkt

Das KI-Startup Thinking Machines, gegründet von Ex-OpenAI-CTO Mira Murati, hat mit Tinker eine neue Trainings-API für Sprachmodelle vorgestellt.

Thinking Machines will mit Tinker die Hürde senken, eigene Modelle auf Open-Source-Basis zu entwickeln, besonders für Teams ohne Zugang zu großen Rechenressourcen.

Die API richtet sich an Forschende und Entwickler, die eigene Modelle auf offenen Gewichten trainieren oder feinjustieren wollen – ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen.

Ziel sei es, "mehr Menschen Forschung mit den neuesten Sprachmodellen zu ermöglichen", heißt es in der Ankündigung des Unternehmens.

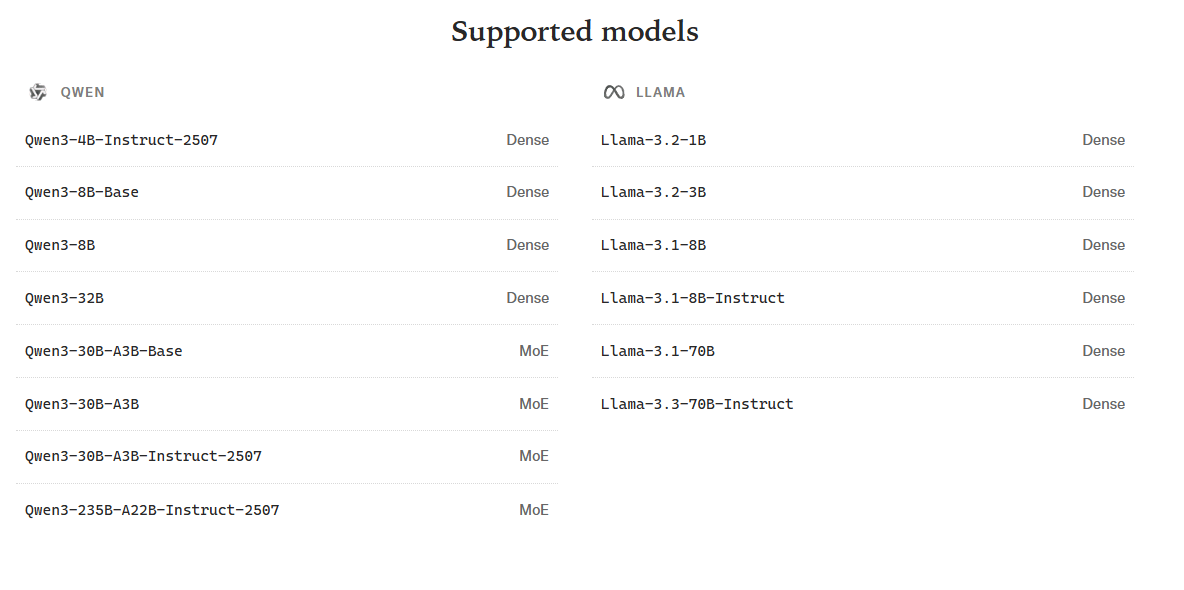

Tinker unterstützt zum Start eine Vielzahl an Open-Weight-Modellen von Meta (Llama) und Alibaba (Qwen), darunter auch größere Modelle wie Qwen-235B-A22B. Der Wechsel zwischen Modellen erfordert lediglich die Änderung eines Strings im Code.

Tinker ist ein verwalteter Dienst, der auf den internen Rechenclustern des Unternehmens läuft. Nutzer können Trainingsläufe sofort starten, während das System Aufgaben wie Ressourcenmanagement, Fehlertoleranz und Scheduling übernimmt.

Die zugrunde liegende Technik basiert auf LoRA (Low-Rank Adaptation), wodurch mehrere Fine-Tuning-Prozesse parallel auf derselben Hardware laufen können. Dadurch können mehrere Fine-Tuning-Läufe den gleichen Compute-Pool nutzen, was die Kosten senken soll.

Ergänzt wird die API durch das offene "Tinker Cookbook", eine Bibliothek mit Implementierungen typischer Post-Training-Methoden. Sie läuft direkt auf der Tinker-API und soll helfen, typische Fehler beim Fine-Tuning zu vermeiden.

Beta-Phase und künftiges Preismodell

Tinker befindet sich derzeit in einer geschlossenen Beta-Phase. Interessierte können sich über eine Warteliste anmelden. Die Nutzung ist zunächst kostenlos, ein nutzungsbasiertes Preismodell soll in den kommenden Wochen folgen.

Murati verließ OpenAI im Herbst 2024, nach Berichten über interne Spannungen. Dass sie nun eine Fine-Tuning-API lanciert, legt nahe, dass sie kurzfristig nicht an eine uneinholbare Dominanz von OpenAI-Modellen oder einen baldigen Durchbruch zur Super-KI glaubt.

Gemeinsam mit anderen ehemaligen OpenAI-Mitarbeitern wie Mitgründer John Schulman und den Forschern Barret Zoph und Luke Metz scheint Murati darauf zu setzen, dass feinabgestimmte Open-Weight-Modelle Unternehmen mittelfristig mehr Flexibilität und wirtschaftlichen Nutzen bieten als proprietäre Frontier-Modelle wie GPT-5. Andernfalls wäre die strategische Entscheidung für ein spezialisiertes Fine-Tuning-Produkt nur schwer nachvollziehbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.