Einige sehen im Prompt Engineering ein Berufsfeld der Zukunft, andere halten es für eine vorübergehende Erscheinung. Die KI-Forschung von Microsoft beschreibt ihren eigenen Ansatz.

In einem kürzlich veröffentlichten Artikel beschreiben Microsoft-Forscherinnen und -Forscher ihren Prompt-Engineering-Prozess für den Dynamics 365 Copilot und den Copilot in der Power-Plattform, zwei Implementierungen von OpenAI-Chat-Modellen.

Prompt-Engineering ist Versuch und Irrtum

Das Microsoft-Forschungsteam verwendet für seine Chatbots unter anderem allgemeine Systemanweisungen, also das, was wir meistens in ChatGPT und Co. eintippen, wenn wir dem Chatbot eine bestimmte Rolle, einen Wissensfundus und Verhaltensweisen vorgeben.

Der Prompt sei "der wichtigste Mechanismus" für die Interaktion mit einem Sprachmodell und ein "enorm effektives Werkzeug", schreibt das Forschungsteam. Er müsse "genau und präzise" sein, sonst bleibe das Modell im Ungewissen.

Microsoft empfiehlt, einige Grundregeln für die Generierung aufzustellen, die je nach Zweck des Chatbots konzipiert werden müssen.

Bei Microsoft gehören zu diesen Grundregeln unter anderem die Vermeidung von subjektiven Meinungen oder Wiederholungen, von Diskussionen oder übermäßigen Einblicken in die Vorgehensweise mit dem Benutzer und das Beenden eines Chat-Threads, der kontrovers wird. Allgemeine Regeln könnten auch verhindern, dass der Chatbot sich vage ausdrückt, vom Thema abschweift oder Bilder in die Antwort einfügt.

System message:

You are a customer service agent who helps users answer questions based on documents from## On Safety:

– e.g. be polite

– e.g. output in JSON format

– e.g. do not respond to if request contains harmful content…## Important

– e.g. do not greet the customer

–AI Assistant message:

## Conversation

User message:

AI Assistant message:

Microsoft Beispiel-Prompt

Das Forschungsteam räumt jedoch ein, dass die Konstruktion solcher Prompts eine gewisse "Kunstfertigkeit" erfordert, also in erster Linie ein kreativer Akt ist. Die erforderlichen Fähigkeiten seien nicht "übermäßig schwer zu erlernen".

Bei der Erstellung von Prompts sollte man sich einen Rahmen schaffen, in dem man mit Ideen experimentieren und diese dann verfeinern kann. "Die Erstellung von Prompts ist Learning by Doing", schreibt das Team.

Die Rolle von Prompts und Prompt-Engineering ist noch unklar, da die Ausgabe der Modelle stark vom Prompt abhängt. Die Zufälligkeit der Textgeneratoren erschwert es jedoch, die Wirksamkeit einzelner Promptmethoden oder gar einzelner Elemente in Prompts so zu untersuchen, dass diese Untersuchung wissenschaftlichen Ansprüchen genügt.

Ob etwa seitenlange "Mega-Prompts" tatsächlich bessere Ergebnisse erzielen als knappe Anweisungen in drei Sätzen, darf zumindest bezweifelt werden. Solche Behauptungen sind kaum evaluierbar, aber derzeit für so manches Geschäftsmodell lukrativ.

Perspektivisch sollte sich Prompt-Engineering weg von einer Art Pseudo-Programmiersprache hin zu einem kreativen Prozess im Workflow-Management entwickeln - welche Arbeitsweisen lassen sich wie zuverlässig über LLMs abbilden?

Das Sprachmodell könnte sich die genauen Prompts dann durch Rückfragen, Tests mit Feintuning und durch Beispiele selbst beschaffen. Der Mensch müsste primär die Möglichkeiten der Systeme kennen und neue Arbeitsweisen definieren und etablieren.

Mit Kontextdaten zu besseren KI-Antworten

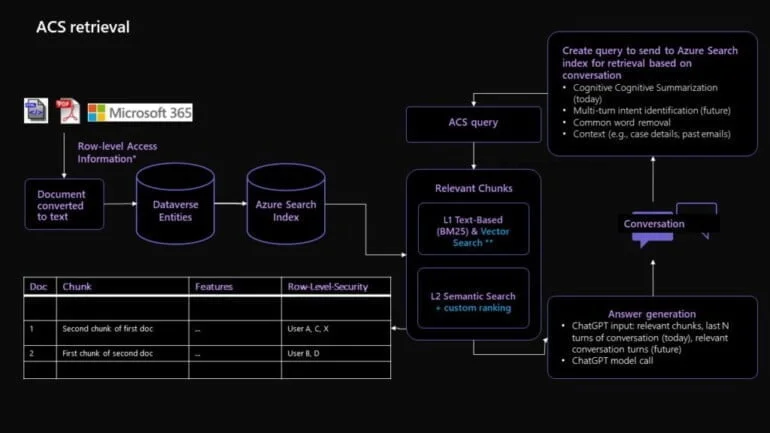

Microsofts Ansatz zum Prompt-Engineering geht über die traditionelle Verwendung von Standard-Prompts hinaus und macht Gebrauch von fortgeschrittenen Techniken wie "Retrieval Augmented Generation" (RAG) und "Knowledge Base Chunking".

RAG ist ein leistungsstarkes Werkzeug, mit dem Microsoft vielfältige und umfangreiche Daten verarbeitet, indem es kleinere, relevante Datenabschnitte oder "Chunks" für bestimmte Kundenprobleme zusammenstellt.

Diese Chunks werden dann mit historischen Daten und dem Feedback des Agenten verglichen, um die bestmögliche Antwort auf die Kundenanfrage zu generieren. Gleichzeitig ermöglicht "Knowledge Base Chunking" die Vereinfachung großer Datenblöcke, indem repräsentative Einbettungen von Dokumenten erstellt werden.

Diese Einbettungen werden dann mit den Benutzereingaben verglichen, um die am besten bewerteten in das GPT-Prompt-Template für die Antwortgenerierung zu integrieren. In Kombination tragen diese Techniken dazu bei, fundierte, relevante und personalisierte Antworten auf Kundenanfragen zu generieren.

Eine detaillierte technische Erklärung ist im Microsoft Research Blog verfügbar.