Bislang konnte KI nur schwierig Benutzeroberflächen von Smartphones bedienen. Google-Forschende scheinen jetzt einen Weg gefunden zu haben.

Forschende von Google Research haben die Verwendung großer Sprachmodelle (LLM) zur Verbesserung der sprachbasierten Interaktion mit mobilen Benutzeroberflächen untersucht. Gegenwärtige intelligente Assistenten auf mobilen Geräten stoßen bei gesprächsähnlichen Interaktionen an ihre Grenzen, da sie nicht in der Lage sind, Fragen zu spezifischen Informationen auf dem Bildschirm zu beantworten.

Die Forscher:innen haben eine Reihe von Techniken entwickelt, um LLMs auf mobilen User Interfaces einzusetzen, einschließlich eines Algorithmus, der die Bedienoberfläche in Text umwandelt. Diese Techniken ermöglichen es Entwickler:innen, neue sprachbasierte Interaktionen schnell in einen Prototyp zu gießen und zu testen. LLMs eignen sich für kontextuelles Prompt-Lernen, bei dem das Modell mit wenigen Beispielen aus der Zielaufgabe gefüttert wird.

Per Sprachmodell das Smartphone steuern

In umfangreichen Experimenten wurden vier Schlüsselaufgaben untersucht. Diese haben den Wissenschaftler:innen zufolge das Ergebnis, dass LLMs für die genannten Aufgaben eine konkurrenzfähige Leistung erbringen und nur zwei Beispiele pro Aufgabe benötigen würden.

1. Generierung von Fragen für den Bildschirm: Wenn etwa eine mobile Benutzerschnittstelle (UI) dargestellt wird, kann das Sprachmodell relevante Fragen zu den UI-Elementen generieren, die eine Benutzereingabe erfordern. Laut Studie konnten Sprachmodelle Fragen mit nahezu perfekter Grammatik (4.98/5) generieren, die mit 92,8 Prozent eine hohe Relevanz für die auf dem Bildschirm angezeigten Eingabefelder hatten.

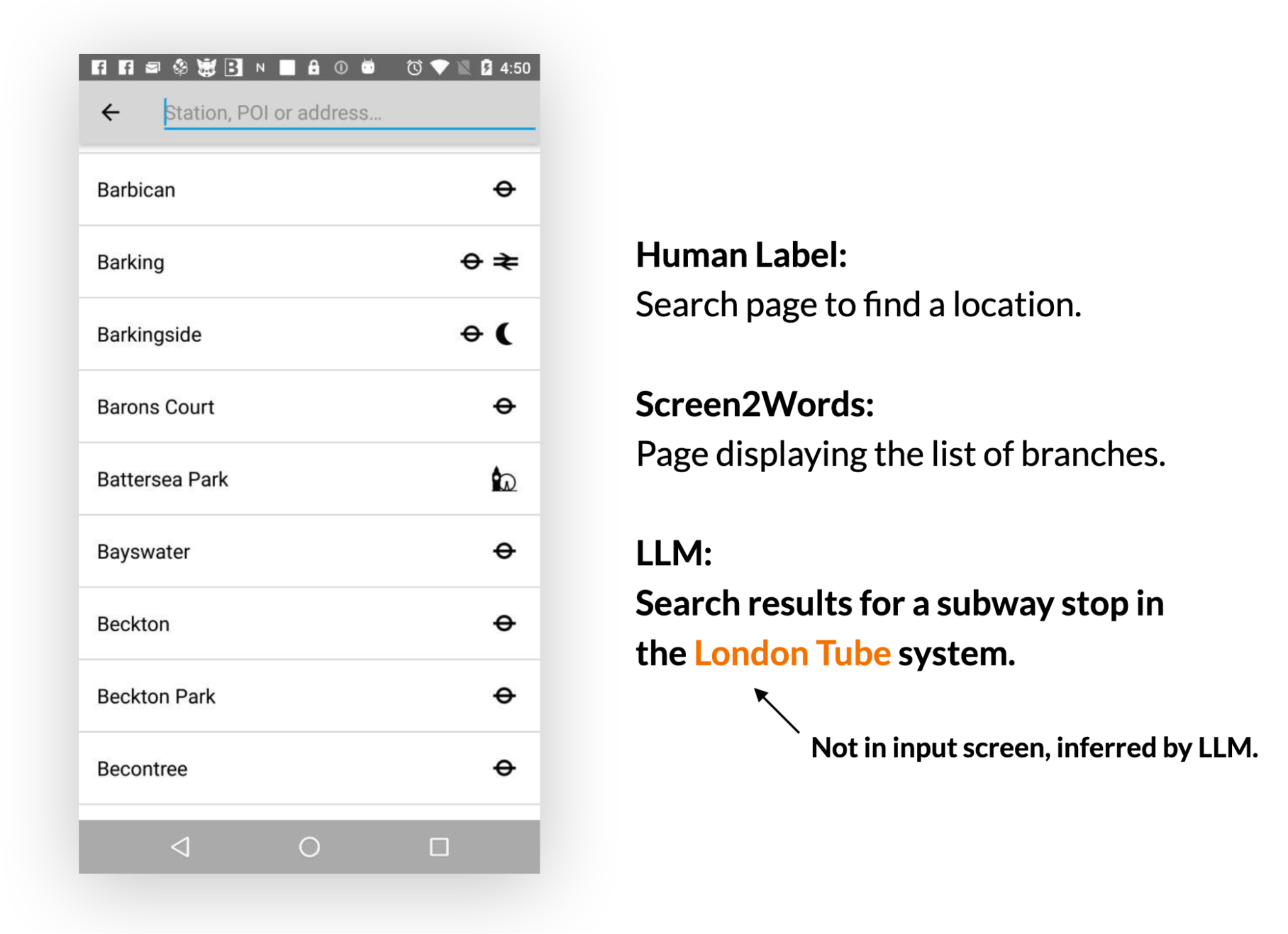

2. Bildschirmzusammenfassung: LLMs sind in der Lage, die Hauptfunktionen einer mobilen UI effektiv zusammenzufassen. Sie erzeugen genauere Zusammenfassungen als das zuvor eingeführte Screen2Words-Modell und können sogar Informationen ableiten, die nicht direkt in der UI präsentiert werden.

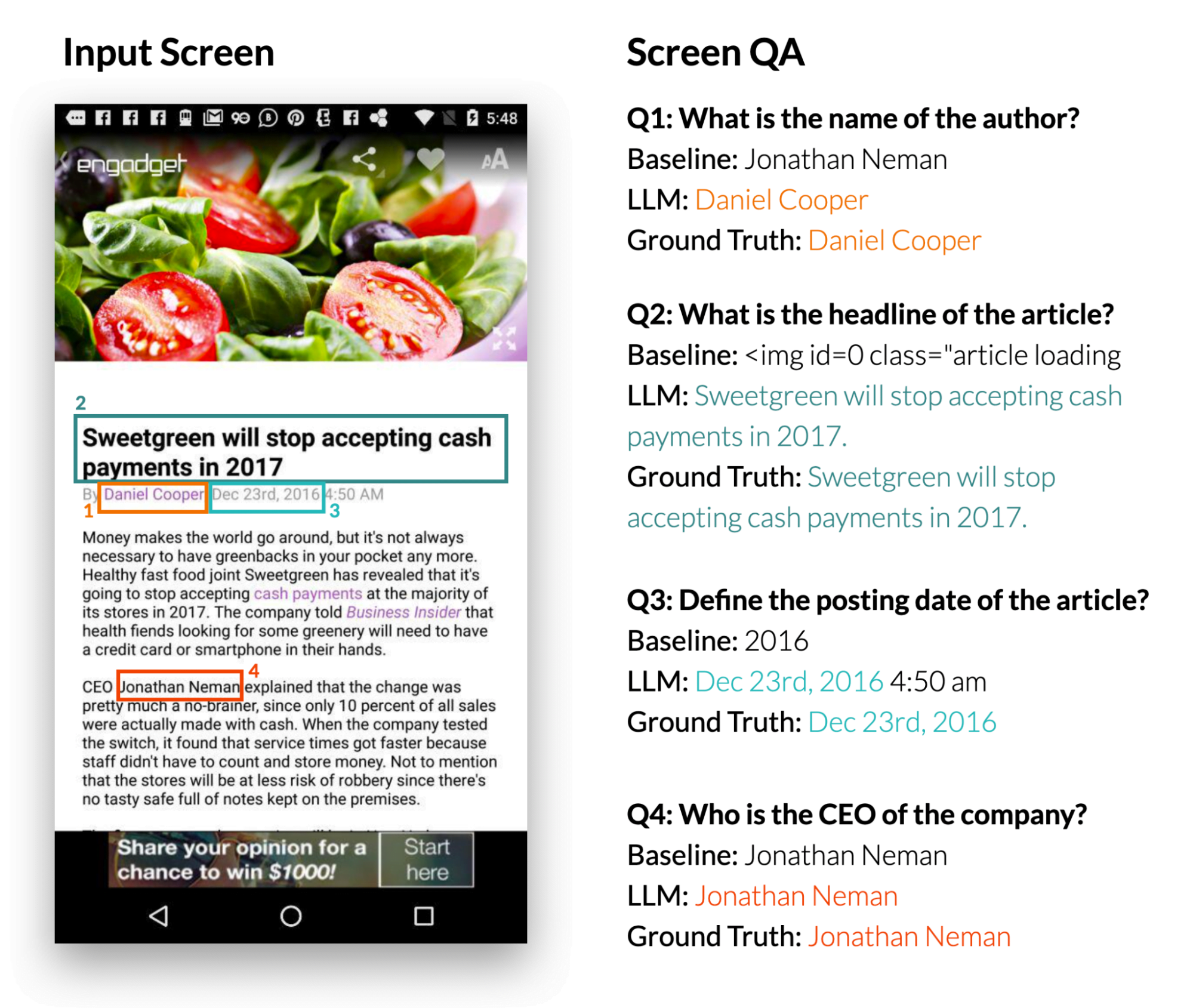

3. Beantwortung von Bildschirmfragen: Wenn ein mobiles UI und eine offene Frage präsentiert werden, die Informationen über die UI erfordert, kann das LLM die richtige Antwort liefern. Die Studie zeigt, dass LLMs Fragen wie "Was ist die Überschrift?" beantworten kann. Das LLM schnitt dabei deutlich besser ab als das Basis-QA-Modell DistilBERT.

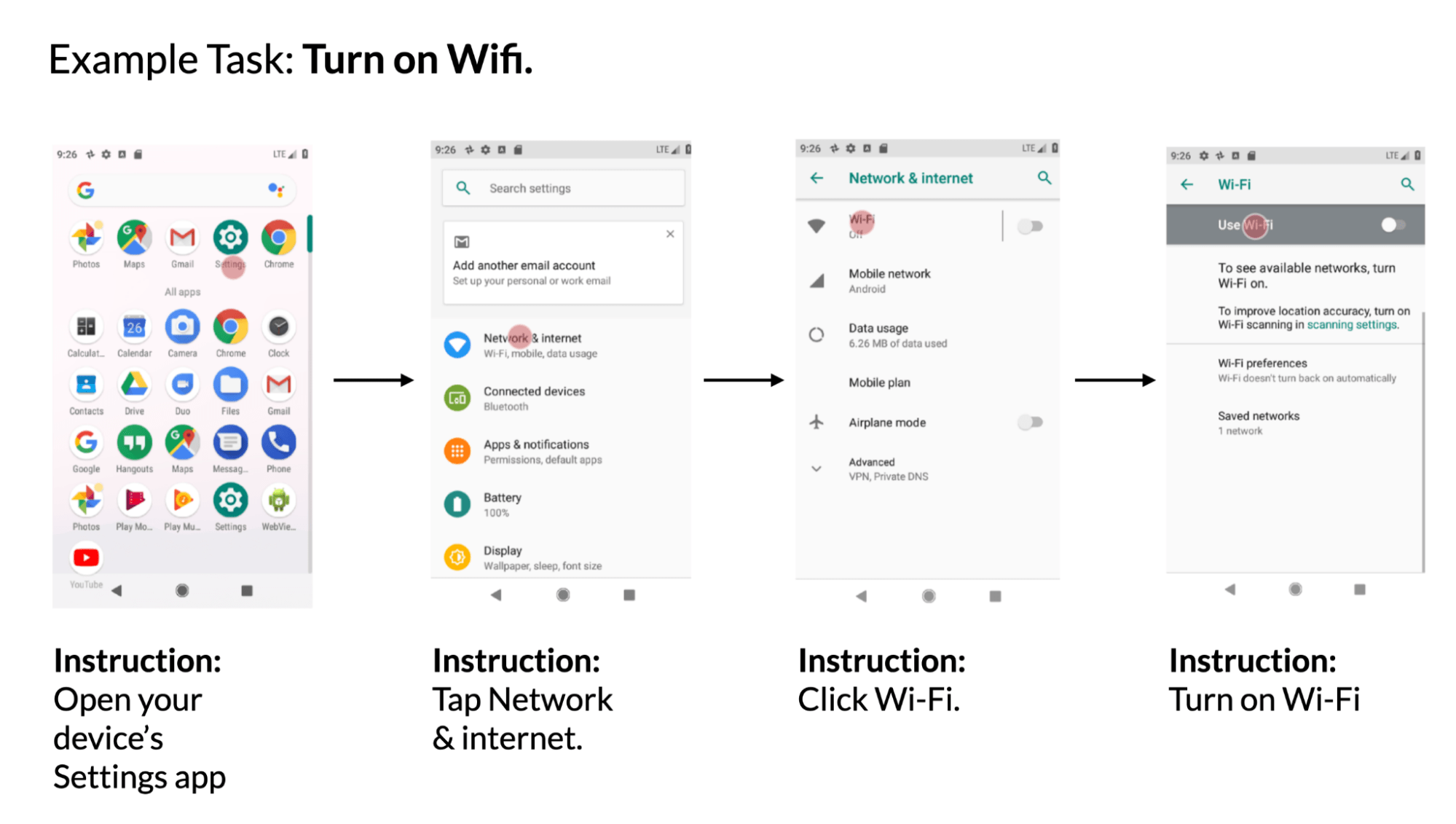

4. Zuordnung von Instruktionen zu UI-Aktionen: Wenn ein mobiles UI und eine Anweisung in natürlicher Sprache zur Steuerung gegeben werden, kann das Modell die ID des Objekts vorhersagen, für das die angegebene Aktion ausgeführt werden soll. Beispielsweise konnte das Modell bei der Anweisung "Öffne Gmail" das Gmail-Symbol auf dem Startbildschirm korrekt identifizieren.

Die Google-Wissenschaftler:innen schlussfolgern, dass das Prototyping von neuen sprachbasierten Interaktionen auf mobilen UIs durch den Einsatz von LLMs vereinfacht werden kann. Dies eröffne sowohl Designer:innen als auch Entwickler:innen und Forschenden neue Möglichkeiten, bevor sie in die Entwicklung neuer Datenbanken und Modelle investieren.