1,3 Billiarden Token im Monat: Googles Rekord-KI-Verbrauch ist viel Augenwischerei

Google gibt an, mit seinen KI-Modellen über 1,3 Billiarden Token pro Monat zu verarbeiten. Doch die Zahl misst vor allem Rechenaufwand – nicht Nutzung oder Nutzen. Und sie stellt den Tenor von Googles eigener Umweltstudie infrage.

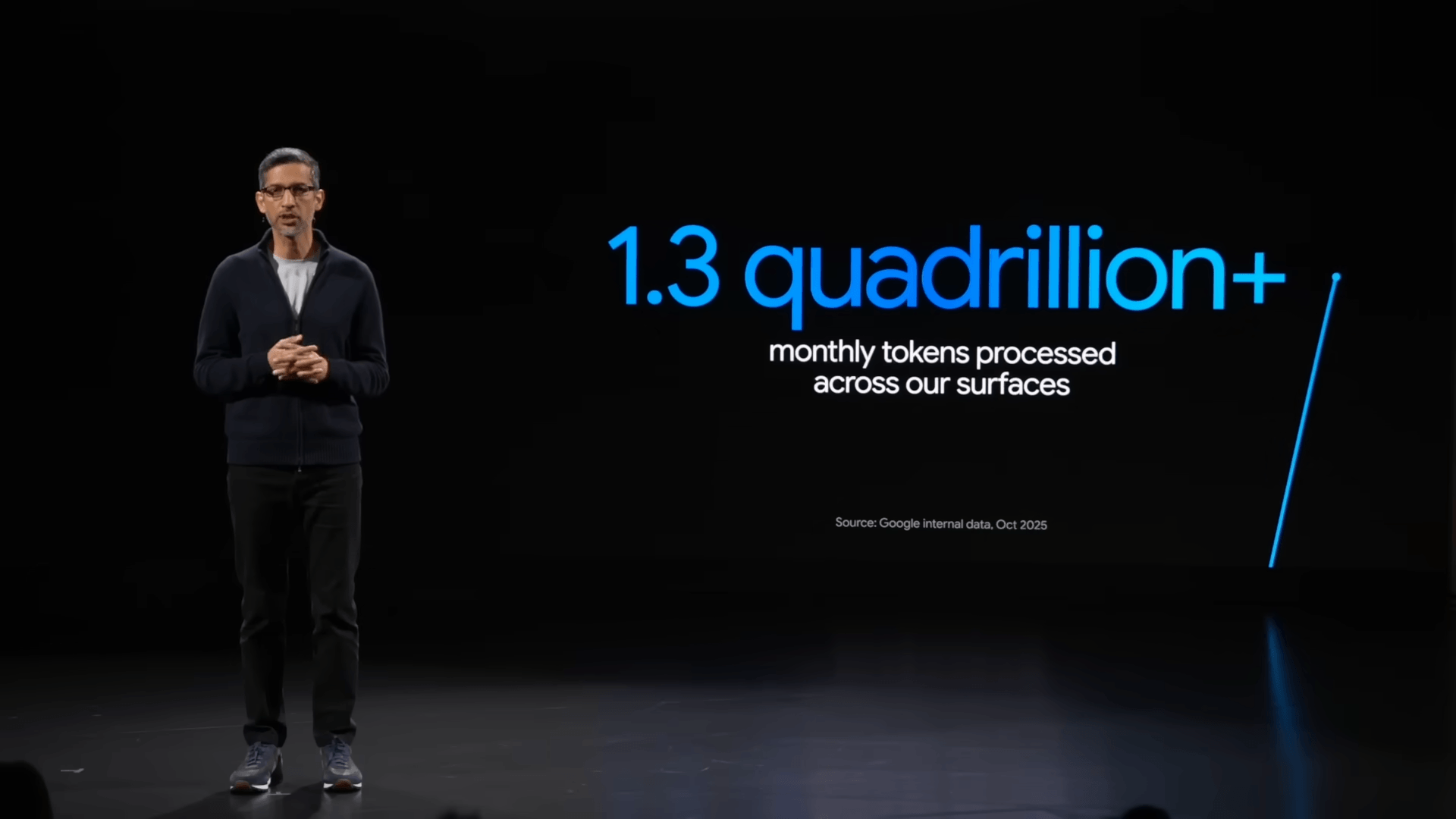

Google verarbeitet nach eigenen Angaben über 1,3 Billiarden Token pro Monat mit seinen KI-Produkten und Schnittstellen. Diese neue Marke wurde von Google-CEO Sundar Pichai auf einer Google-Cloud-Veranstaltung angekündigt.

Bereits im Juni hatte Google gemeldet, 980 Billionen Token verarbeitet zu haben, mehr als doppelt so viele wie im Mai. Der aktuelle Wert liegt rund 320 Billionen Token über dem Juni. Das bedeutet, dass sich der relative Anstieg in den letzten Monaten bereits deutlich verlangsamt hat – anders, als Pichai es in seiner Präsentationsgrafik darstellt.

Mehr Token bedeuten mehr Nutzung – aber nicht im gleichen Verhältnis

Token sind die kleinste Recheneinheit großer Sprachmodelle – vergleichbar mit Wortsilben. Ein hoher Token-Verbrauch klingt nach wachsender Nutzung, ist in diesem Fall aber vor allem Ausdruck steigender Rechenkomplexität.

Ein zentraler Grund dafür ist die breitere Einführung von Reasoning-Modellen wie Gemini 2.5 Flash, die vor der Ausgabe deutlich mehr interne Rechenschritte durchlaufen. Selbst einfache Anfragen wie "Hi" können dutzende Sätze interner Verarbeitung auslösen, bevor eine Antwort generiert wird.

Laut einer Analyse erzeugt Gemini Flash 2.5 rund 17-mal mehr Token pro Anfrage als sein Vorgänger – bei gleichem Input. Die Ausführung ist dabei bis zu 150-mal teurer. Hinzu kommen aufwendige Rechenprozesse bei Video-, Bild- und Audiofunktionen, die in der Metrik enthalten sein dürften, jedoch nicht näher aufgeschlüsselt werden.

Die Token-Metrik misst daher in erster Linie den Rechenaufwand und die Skalierbarkeit der Infrastruktur – nicht aber den tatsächlichen Nutzungsgrad oder den praktischen Nutzen der Systeme.

Google relativiert eigene Umweltstudie

Die neuen Token-Zahlen stellen zudem zentrale Aussagen von Googles kürzlich veröffentlichter Umweltstudie infrage, in der eine typische Textanfrage an Gemini mit nur 0,24 Wattstunden Strom, 0,03 Gramm CO₂ und 0,26 Millilitern Wasser beziffert wird – weniger als neun Sekunden Fernsehen.

Diese Werte beruhen auf einer „typischen“ Kurztextanfrage über die Gemini-App. Ob dabei ein tokenintensives Reasoning-Modell oder ein sparsames LLM verwendet wurde, bleibt offen. Komplexere Anwendungsfälle – etwa Dokumentenanalyse, Bild- oder Audiogenerierung, multimodale Eingaben oder agentische Websuche – werden durch die Methodik der Studie nicht erfasst.

Vor diesem Hintergrund zeigen die 1,3 Billiarden Token vor allem, wie stark die tatsächliche Rechenlast zunimmt. Und genau diese systemische Skalierung bleibt in Googles Umweltbilanz ausgeklammert. Vergleichbar ist das mit einem Autohersteller, der angibt, dass ein Fahrzeug im Leerlauf besonders wenig Kraftstoff verbraucht – und daraus eine „grüne“ Flotte ableitet, während reale Fahrbedingungen und Produktionskosten unberücksichtigt bleiben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.