2025 soll das Jahr der KI-Agenten werden, aber das ist relativ

Manche KI-Experten, auch selbst ernannte, überbieten sich derzeit mit Prognosen über KI-Agenten. Doch was ein Agent ist und wann er wirklich einsatzbereit ist, darüber gehen die Meinungen auseinander.

Logan Kilpatrick, Produktleiter bei Google AI Studio und verantwortlich für Googles Gemini-API, macht auf X eine Ansage zur Entwicklung von KI-Fähigkeiten: Die meisten Anwendungsfälle für KI-Sehen (Vision) funktionierten bereits heute und seien bereit für den breiten Einsatz. 2025 werde daher das Jahr, in dem diese Vision-Fähigkeiten Mainstream werden.

Bei KI-Agenten sieht es laut Kilpatrick anders aus: Sie benötigen "noch etwas mehr Arbeit" für den Einsatz im Milliarden-Nutzer-Maßstab. Zwischen der technischen Machbarkeit und dem breiten Einsatz von KI-Fähigkeiten liege generell eine Lücke von etwa zwölf Monaten - daher seine Prognose, dass Agenten erst 2026 durchstarten werden.

Microsoft "CEO of AI" sieht es ähnlich

Diese vergleichsweise vorsichtige Einschätzung zu Agenten wird von Microsofts "CEO of AI" Mustafa Suleyman bestätigt.

Im Juni 2024 erklärt er, warum der Weg zu verlässlichen KI-Agenten noch weit ist: Zwar könnten KI-Modelle in den nächsten zwei Jahren in eng umgrenzten Anwendungsfällen weitgehend autonom agieren. Bis sie aber konstant präzise arbeiten, brauche es seiner Meinung nach noch zwei Modellgenerationen. Die Modelle müssten für jede Anfrage einen exakt passenden Funktionsaufruf darstellen können.

Laut Suleyman reicht die derzeitige Genauigkeit von 80 Prozent für zuverlässige KI-Agenten nicht aus. Für das Vertrauen der Endnutzer sei eine Trefferquote von 99 Prozent erforderlich. Um diese zu erreichen, benötigten die Modelle etwa die hundertfache Rechenleistung - ein Niveau, das erst mit GPT-6 erreicht werden dürfte, schätzt Suleyman.

Dennoch bietet Google mit Gemini 2.0 bereits Ansätze und plant, diese weiter auszubauen. OpenAI soll im Januar mit dem "Operator" starten, einem KI-Agenten, der unter anderem Internet-Browser bedienen kann.

Was ist überhaupt ein KI-Agent?

Wer regelmäßig mit großen Sprachmodellen und komplexeren Prompts in konkreten Praxisprojekten arbeitet, versteht die Zurückhaltung von Kilpatrick und Suleyman. Die Zuverlässigkeit von LLMs ist verbesserungswürdig, insbesondere bei komplexen und detaillierten Anweisungen.

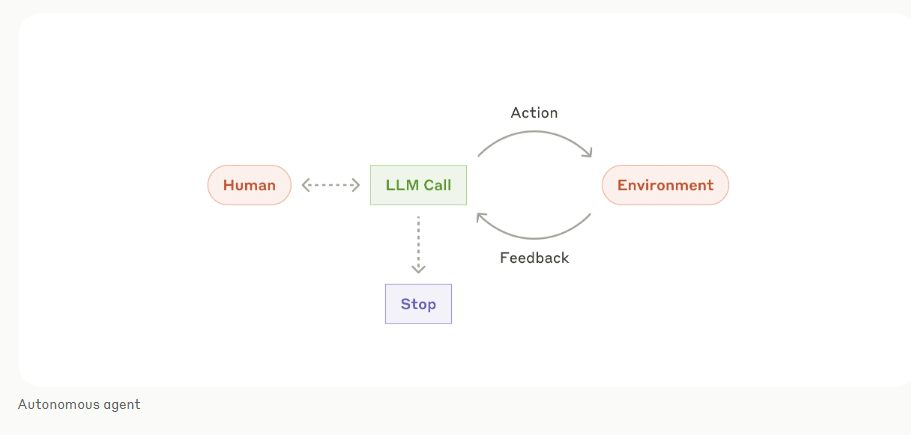

Letztlich sind aber alle pauschalen Prognosen zu Agenten relativ, da es auf die genaue Definition von Agenten ankommt. Eine hilfreiche Definition stammt von Anthropic: Das Unternehmen unterscheidet klar zwischen Workflows und Agenten.

Während Workflows vordefinierten Codepfaden folgen, bei denen Sprachmodelle und Tools nach festgelegten Mustern zusammenarbeiten, steuern echte Agenten ihre Prozesse und Werkzeuge dynamisch und eigenständig. Die Definition von OpenAI ist ähnlich, die KI-Firma beschreibt agentische Systeme als KI-Systeme, die komplexe Ziele mit begrenzter direkter Überwachung verfolgen können.

Viele Unternehmen, die jetzt schon behaupten, Agenten anzubieten, verknüpfen womöglich nur Prompts untereinander oder mit einem Werkzeug wie einer Datenbank- oder Websuche. Das macht die Anwendung nicht unnütz, aber es ist eben hauptsächlich Marketing. Korrekter wäre es, man würde eher von Prompt-Chaining (verknüpfte Prompts) oder Assistants (im Sinne von vor-geprompteten, mit Datenbank verknüpften Chatbots) sprechen.

Bezeichnend ist, dass ausgerechnet Anthropic, das mit Computer Use einen ersten "Next-Gen"-Agenten für Computeraktionen veröffentlicht hat, bei Agenten zur Zurückhaltung mahnt: Stattdessen sollten Unternehmen mit einfachen Prompts beginnen und diese optimieren.

Mehrstufige Agentensysteme seien erst dann sinnvoll, wenn einfachere Lösungen an ihre Grenzen stoßen. Viele Unternehmen scheitern noch daran, generative KI überhaupt sinnvoll in ihren Arbeitsalltag zu integrieren, weil die Arbeit mit den Systemen so neu und die Verlässlichkeit noch gering ist.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.