Googles "Robotics Transformer 1" soll die Ära großer Robotermodelle einläuten

Google zeigt ein neues KI-Modell mit einem riesigen Datensatz für die Echtzeit-Robotersteuerung.

Jüngste Erfolge in der Entwicklung von KI-Systemen, die Bilder oder natürlicher Sprache verarbeiten, bauen auf einem gemeinsamen Ansatz auf: große und diverse Datensätze, die von leistungsstarken und effizienten Modellen verarbeitet werden.

Generative KI-Modelle für Text oder Bild wie GPT-3 und DALL-E erhalten ihre Daten aus dem Internet und sind nur für das Nachtraining auf spezialisierte Datensätze angewiesen. OpenAI verwendet etwa Datensätze mit von Menschen gefeedbackten Inhalten, um ein großes KI-Modell besser auf menschliche Bedürfnisse abzustimmen.

In der Robotik fehlen jedoch gigantische Datensätze, wie es sie für Texte und Bilder gibt. Für sie müssten massenhaft Roboter-Daten aus dem autonomen Betrieb oder mit menschlicher Teleoperation gesammelt werden - das macht sie teuer und schwer zu erstellen. Dazu gibt es bisher kein KI-Modell, das von solchen Daten lernen und von ihnen in Echtzeit generalisieren könnte.

Einige Forschende setzen daher auf Roboter-KI-Training in der Simulation. Andere versuchen, KI von Internetvideos lernen zu lassen.

Googles Robotics Transformer 1 lernt multimodal

Google stellt nun den Robotics Transformer 1 (RT-1) vor, ein KI-Modell für die Robotersteuerung. Ergänzt wird das Modell durch einen großen Echtwelt-Datensatz fürs Robotertraining.

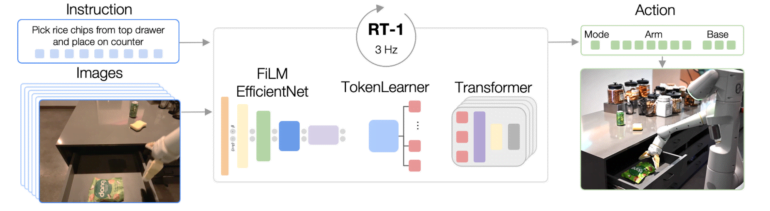

Das Modell nutzt Text-Befehl und Kamerabilder als Input, die von einem FiLM EfficientNet-Modell in Token verwandelt und mit einer zusätzlichen Methode (TokenLearner) komprimiert werden. Die Inputs werden dann an den Transformer weitergeleitet, der Motorenbefehle ausgibt. Laut Google ist das Modell so schnell genug, um Roboter in Echtzeit zu kontrollieren.

Googles RT-1 lernt mit mehr als 100.000 Beispielen

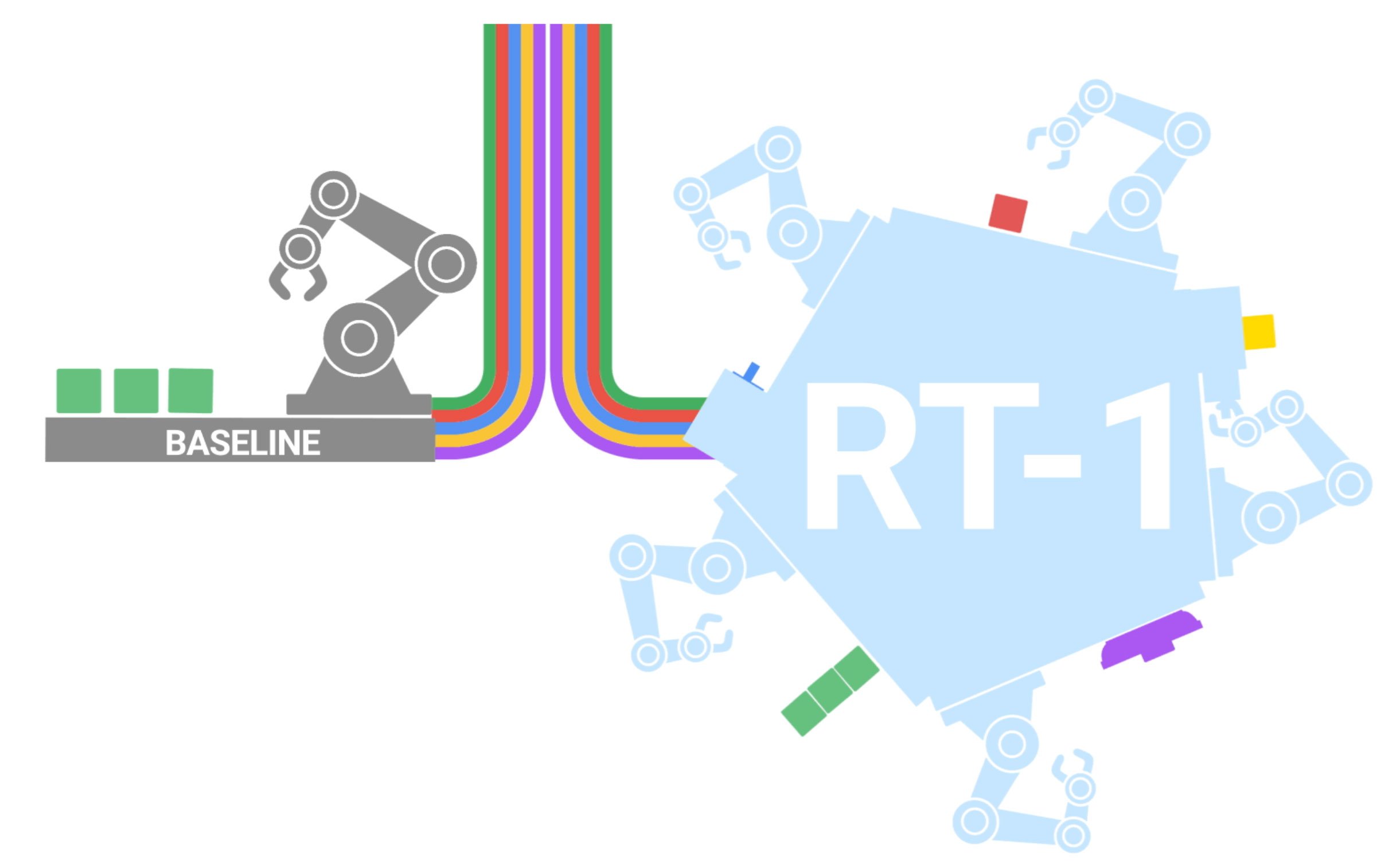

Für das Training von RT-1 verwendete Google einen großen Datensatz mit 130.000 Beispielen von mehr als 700 Roboteraufgaben wie Aufheben, Ablagen, Öffnen und anderen, die das Unternehmen über 17 Monate mit 13 Robotern gesammelt hat. In den Daten sind die Bewegungen der Robotergelenke, der Roboterbasen, Kameraaufnahmen und Textbeschreibungen der Aufgaben enthalten.

Nach dem Training verglich das Team von Google RT-1 mit anderen Methoden in verschiedenen gesehenen und ungesehenen Aufgaben, sowie wie robust die verglichenen Modelle mit unterschiedlichen Rahmenbedingungen klarkommen.

RT-1 setzte sich in allen Szenarien deutlich vor die anderen Methoden, darunter Deepminds Gato. Google experimentierte zudem mit weiteren Datenquellen. Die Ergebnisse aus diesen Experimenten würden nahelegen, dass RT-1 neue Fähigkeiten mit Trainingsdaten anderer Roboter lernen kann, schreibt Google.

Googles RT-1 plus SayCan zeigt Leistungssprung

Das Team überprüfte zudem, ob sich die Leistung von Googles SayCan mit RT-1 verbessern lässt. Tatsächlich schnitt das kombinierte System knapp 20 Prozent besser ab und konnte auch in einer komplizierteren Küchenumgebung diese Erfolgsrate halten.

Der RT-1 Robotics Transformer ist ein einfaches und skalierbares Modell zur Aktionsgenerierung für reale Robotikaufgaben. Er tokenisiert alle Eingaben und Ausgaben und verwendet ein vortrainiertes EfficientNet-Modell mit früher Sprachfusion sowie einen Token-Learner für die Kompression. RT-1 zeigt eine starke Leistung bei hunderten von Aufgaben sowie umfangreiche Generalisierungsfähigkeiten und Robustheit in realen Umgebungen.

Das Team hofft, die Anzahl gelernter Roboterfähigkeiten in Zukunft schneller zu erhöhen. Dafür sollen Menschen ohne Expertise bei der Teleoperation von Robotern eingespannt werden. Ferner sollen die Reaktionszeit und die Fähigkeit, Kontext über einen längeren Zeitraum zu behalten, weiter verbessert werden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.