Stochastic Parrot oder Weltmodell? Wie große Sprachmodelle lernen

Große Sprachmodelle zeigen beeindruckende Fähigkeiten. Sind sie nur oberflächliche Statistik - oder steckt mehr dahinter?

Spätestens GPT-3 von OpenAI hat gezeigt, dass große Sprachmodelle über Fähigkeiten verfügen, die sie zu einem nützlichen Werkzeug in verschiedenen Bereichen wie Textverarbeitung oder Programmierung machen können.

Mit ChatGPT erschien Ende 2022 ein KI-System, das diese Fähigkeiten in die Hände der breiten Öffentlichkeit legt und damit z.B. Bildungseinrichtungen vor ganz neue Herausforderungen stellt.

Werden Sprachmodelle unter- und überschätzt?

Die beeindruckenden Fähigkeiten führen schnell zu einer Überschätzung von KI-Systemen wie ChatGPT. Dennoch scheinen die 2019 geführten Debatten über GPT-3 auch heute noch ihre Wirkung zu entfalten: Nur selten wird ChatGPT in den Medien als direkter Vorläufer einer allgemeinen Künstlichen Intelligenz bezeichnet.

Das liegt auch daran, dass die Systeme immer wieder absurde Rechenfehler machen, Fakten halluzinieren oder falsche Schlüsse ziehen. Solche Beispiele zeigen, was den Modellen fehlt: logisches Denken und ein physikalisch fundiertes Weltmodell.

In der Forschung werden Sprachmodelle daher zum Gegenstand von Debatten über die Rolle von Syntax und Semantik, von nichtsprachlichem und sprachlichem Wissen und über die Unterschiede zwischen Denken und Sprechen.

Eine zentrale Debatte ist, ob Sprachmodelle nur oberflächliche Statistiken lernen - also "stochastic parrots" sind - oder ob sie interne Repräsentationen der Prozesse lernen, die die Sequenzen erzeugen, die sie verarbeiten. Mit anderen Worten: Plappert ein Sprachmodell nur das nach, was es auswendig gelernt hat, oder hat es Modelle von Sprache gelernt, repräsentiert es intern etwa Regeln der Grammatik oder der Syntax von Programmiersprachen?

Von Vögeln, die Othello spielen

Eine neue Arbeit von Forschenden der Harvard University, des Massachusetts Institute of Technology und der Northeastern University liefert nun Argumente für die zweite Position.

Das Team trainierte ein GPT-Modell (Othello-GPT) mit Othello-Spielzügen, um neue Spielzüge vorherzusagen. Nach dem Training mit Spielzügen lag die Fehlerquote bei der Vorhersage von legalen Spielzügen bei 0,01 Prozent. Eine untrainierte Othello-GPT hat eine Fehlerquote von 93,29 Prozent. Anschließend untersuchten die Forschenden, ob sich im künstlichen neuronalen Netz interne Repräsentationen des Spiels finden lassen.

Um zu verdeutlichen, nach welchen Kriterien einem System ein internes Modell und nicht nur eine oberflächliche Statistik zugeschrieben werden kann, liefern die Forschenden ein Gedankenexperiment:

Stellen Sie sich vor, Sie haben einen Freund, der gerne das Brettspiel Othello spielt und oft zu Ihnen nach Hause kommt, um zu spielen. Sie beide nehmen den Wettbewerb ernst und schweigen während des Spiels, bis auf einen Ausruf jedes Zuges, wenn Sie ihn machen, unter Verwendung der Standard-Othello-Notation. Stellen Sie sich nun vor, dass eine Krähe vor einem offenen Fenster hockt, außerhalb des Blickfelds des Othello-Bretts. Nach vielen Besuchen Ihres Freundes fängt die Krähe an, ihre eigenen Züge zu rufen - und zu Ihrer Überraschung sind diese Züge angesichts des aktuellen Bretts fast immer legal.

Das würde die Frage aufwerfen, wie die Krähe diese Fähigkeit realisiert. Das Team liefert zwei Möglichkeiten:

- Erzeugt es legale Züge durch "zufälliges Zusammenfügen" oberflächlicher Statistiken, z. B. welche Eröffnungen üblich sind oder die Tatsache, dass die Namen der Eckfelder später im Spiel aufgerufen werden?

- Oder verfolgt und nutzt es irgendwie den Stand des Spiels, obwohl es das Brett nie gesehen hat?

Nur das Verhalten der Krähe lässt keine Antwort zu. Doch eines Tages entdecken wir beim Fensterputzen eine gitterartige Anordnung von zwei Sorten Vogelfutter - und diese Anordnung ähnelt verblüffend der unseres letzten Othello-Spiels.

Beim nächsten Spiel beobachten wir die Krähe:

Natürlich zeigen die Samen Ihre aktuelle Position an, und die Krähe stupst mit ihrem Schnabel einen weiteren Samen an, um den Zug, den Sie gerade gemacht haben, anzuzeigen. Dann fängt sie an, die Samen zu überprüfen und achtet dabei besonders auf Teile des Gitters, die für die Rechtmäßigkeit des nächsten Zuges entscheidend sein könnten.

Wir beschließen, die Krähe auszutricksen, lenken die Krähe ab und ordnen einige Samen in einer neuen Position an.

Wenn die Krähe wieder auf das Spielbrett schaut, zuckt sie mit dem Kopf und kündigt einen Zug an, der nur in der neuen, umgestellten Position legal ist.

Spätestens hier müssen wir der Krähe zugestehen, dass ihre Fähigkeiten auf mehr beruhen als auf oberflächlicher Statistik. Sie hat ein Spielmodell gelernt, das wir verstehen und mit dem wir ihr Verhalten steuern können.

Selbstverständlich gibt es Dinge, die die Krähe nicht repräsentiert:

Was einen guten Zug ausmacht, was es bedeutet, ein Spiel zu spielen, dass Gewinnen glücklich macht, dass Sie einmal absichtlich schlechte Züge gemacht haben, um Ihren Freund aufzuheitern, und so weiter.

Hat die Krähe also Othello "verstanden", ist sie "intelligent"? Die Forschenden treten von der Beantwortung solcher Fragen vorerst zurück, doch "wir können sagen, dass sie eine interpretierbare und kontrollierbare (mit Absicht veränderbare) Darstellung des Spielzustands entwickelt hat."

Othello-GPT als synthetischer Test für große Sprachmodelle

In unserem Gedankenexperiment externalisiert die Krähe ihr Othello-Modell und macht es damit für uns interpretierbar. Nun tut uns die Natur selten den Gefallen, interne Repräsentationen auf diese Weise zu externalisieren - ein Kernproblem, das jahrzehntelang zu Debatten über kognitive Zustände bei Tieren geführt hat. Die Entdeckung von Orientierungszellen bei Ratten war daher eine nobelpreiswürdige Entdeckung: Sie bewies, dass an der Idee, dass biologische Gehirne Modelle ihrer Umwelt abbilden, etwas dran ist.

Interne Repräsentationen in neuronalen Netzwerken lassen sich dagegen viel einfacher untersuchen, und das Team nutzt sie, um ihre neuronale "Krähe" - Othello-GPT - zu testen. Die Forschenden trainieren 64 unabhängige, kleine neuronale Netze (MLP), deren Aufgabe es ist, jedes der 64 Felder des Othello-Spielbretts in drei Zustände zu klassifizieren: schwarz, leer und weiß. Als Eingabe dient jedoch nicht das Spielfeld, sondern die internen Repräsentationen des Othello-GPT. Wenn diese das Spielfeld repräsentieren, sollten die fertig trainierten MLPs ihre Aufgabe erfüllen können.

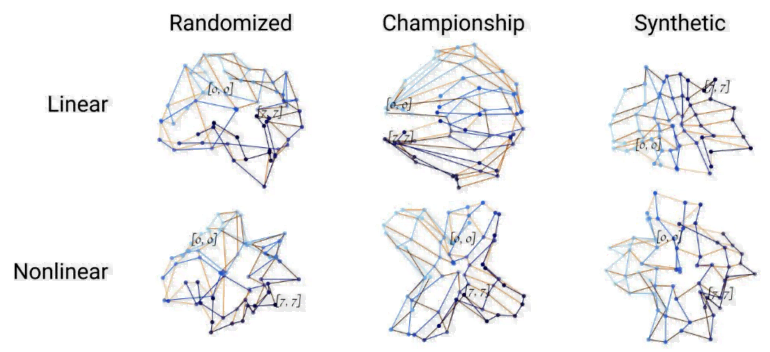

Tatsächlich kann das Team zeigen, dass die Fehlerrate der Klassifikatoren durch das Training auf 1,7 Prozent sinkt. Dies deute darauf hin, dass es ein "Weltmodell" des Spiels in der internen Repräsentation von Othello-GPT gibt. Eine Visualisierung der Vektoren der MLPs zeige zudem, dass durch das Training eine Geometrie entsteht, die das Spielbrett repräsentiert.

Aber nutzt das GPT-Modell diese interne Darstellung, um neue Spielzüge vorherzusagen? Um diese Frage zu beantworten, verändert das Team Zustände des internen Modells, ähnlich wie im Gedankenexperiment das Modell der Krähe verändert wurde. In ihrem Experiment bestätigen die Forschenden, dass eine gezielte Veränderung der Repräsentation des Zustandes eines für die Vorhersage des nächsten Zuges wichtigen Spielfeldes tatsächlich die Vorhersage verändert.

Das zeige, dass Othello-GPT nicht nur ein internes Modell des Spiels bildet, sondern es auch für die Vorhersage nutzt. Zudem lasse sich diese Erkenntnis nutzen, um zu zeigen, wie genau ein Netzwerk zu seinen Vorhersagen kommt. Dazu zeigen die Forschenden eine "local saliency map", die die für eine Entscheidung relevanten Spielfelder markiert und so Unterschiede zwischen den Darstellungen zweier Othello-GPT-Varianten aufdeckt.

Unterschätzte Papageien

Mit Othello-GPT zeigt das Team, dass GPT-Modelle in der Lage sind, Weltmodelle zu lernen und diese für Vorhersagen zu nutzen. Der Sprung vom Spielbrett zur natürlichen Sprache ist jedoch schwierig:

Bei realen Sprachmodellen kennen wir im besten Fall nur einen kleinen Teil des dahinter liegenden Weltmodells. Wie man LLMs auf eine minimal invasive (unter Beibehaltung anderer Weltrepräsentationen) und dennoch effektive Weise kontrollieren kann, bleibt eine wichtige Frage für zukünftige Forschung.

Das Team schlägt daher vor, sich der Erforschung großer Sprachmodelle langsam anzunähern, indem komplexere Spiele und Grammatikwerkzeuge mit synthetischen Daten verwendet werden.

Die Arbeit trägt jedoch bereits jetzt zu einem besseren Verständnis der Architektur von Transformern und Sprachmodellen bei und deckt sich mit anderen Untersuchungen, die in GPT-Modellen beispielsweise Hinweise auf interne Repräsentationen einfacher Konzepte wie Farbe oder Richtung gefunden haben.

Sollten sich diese Ergebnisse auch in großen Sprachmodellen bestätigen, müssten wohl auch harte Kritiker:innen die Modelle damit zumindest irgendwo zwischen stochastischen Pagaeien und echten Krähen einordnen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.