Neue Methode generiert bessere Prompts aus Bildern

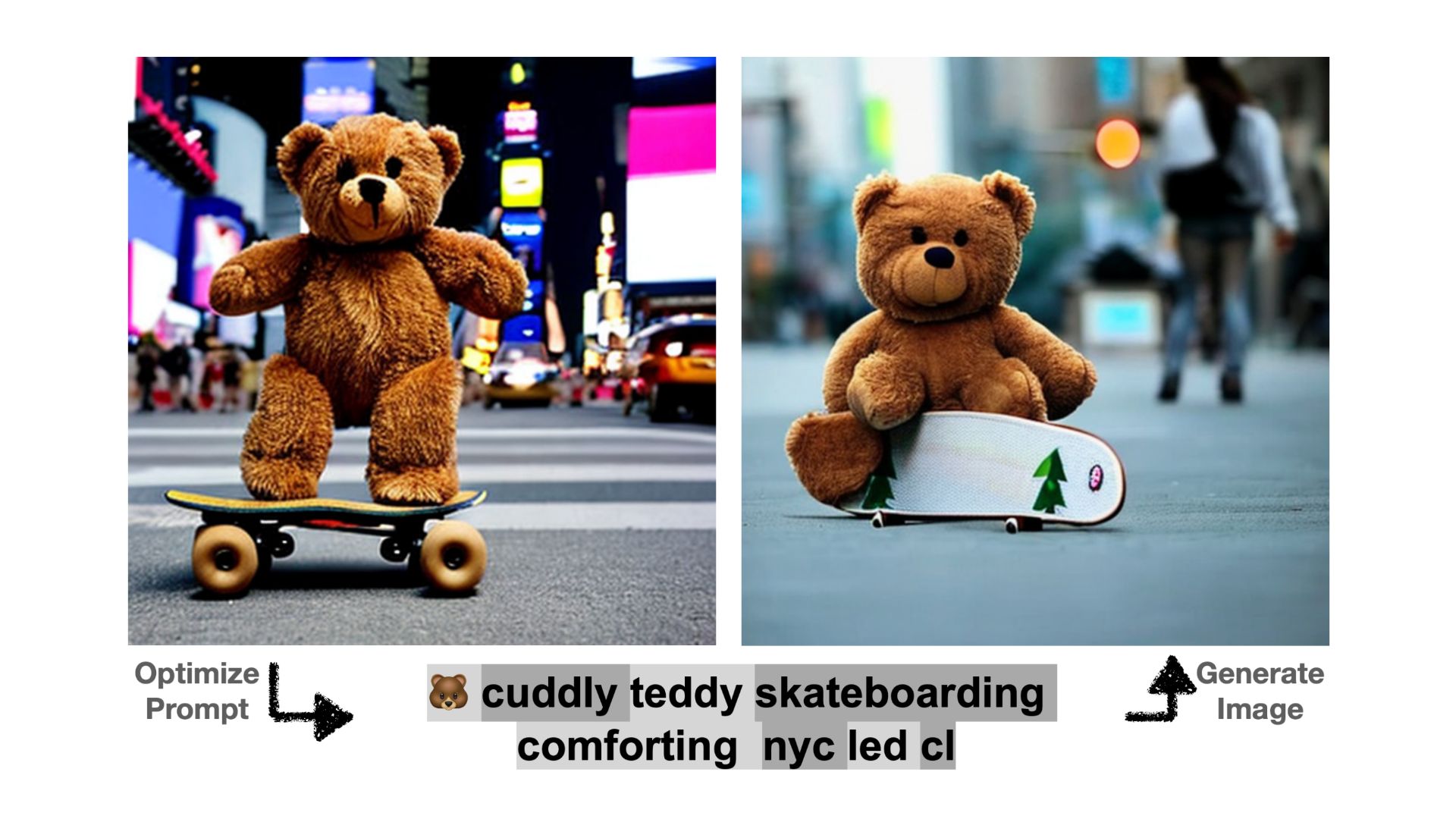

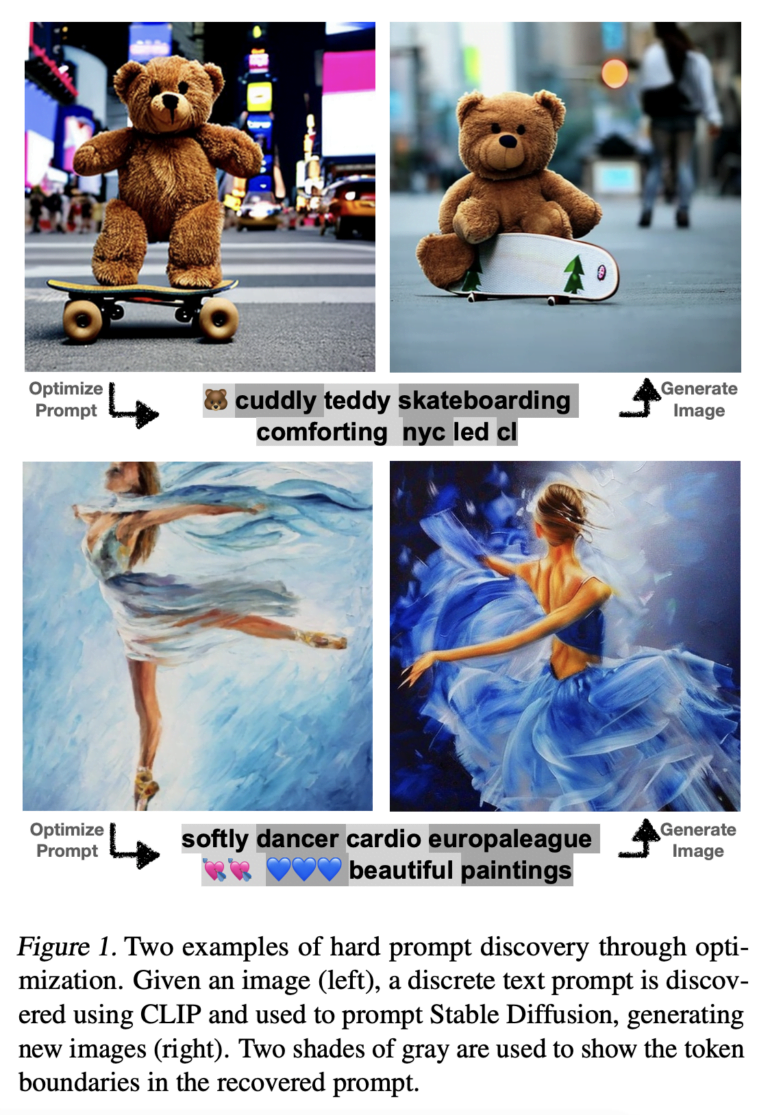

Eine neue Methode lernt Prompts aus einem Bild und erlaubt so die präzise Steuerung von Stable Diffusion - ganz ohne Handarbeit.

Ob DALL-E 2, Midjourney oder Stable Diffusion: Alle aktuellen generativen Bildmodelle werden durch Texteingaben, sogenannte Prompts, gesteuert. Das Ergebnis generativer KI-Modelle hängt stark von der Formulierung dieser Prompts ab, weshalb sich das "Prompt Engineering" mittlerweile als eigene Disziplin in der KI-Szene etabliert hat. Das Ziel dieser Bemühungen ist unter anderem, Prompts zu finden, die wiederholbare Ergebnisse hervorbringen, sich mit anderen Prompts mischen lassen und im Idealfall auch bei anderen Modellen funktionieren.

Abseits solcher Text-Prompts können die KI-Modelle auch über sogenannten "Soft Prompts" gesteuert werden. Dabei handelt es sich um automatisch aus dem Netzwerk abgeleitete Text-Embeddings, also Zahlenwerte, die nicht direkt menschlichen Begriffen entsprechen. Da die weichen Prompts direkt aus dem Netzwerk abgeleitet werden, produzieren sie sehr präzise Ergebnisse für bestimmte Synthese-Aufgaben, lassen sich jedoch nicht auf andere Modelle übertragen.

"Gelernte harte Prompts" benötigen viel weniger Tokens

Wissenschaftler:innen der University of Maryland und der New York University zeigen in einem neuen Paper mit dem Titel "Hard Prompts Made Easy" (PEZ), wie sich die Präzision von weichen Prompts mit der Übertragbarkeit und Mischbarkeit von Text-Prompts - oder harten Prompts, wie es im Paper heißt - verbinden lässt.

Das Finden harter Prompts sei "eine besondere Alchemie" und erfordere ein hohes Maß an Intuition oder viele Versuche. Weiche Prompts hingegen seien für den Menschen nicht lesbar und eine mathematische Wissenschaft.

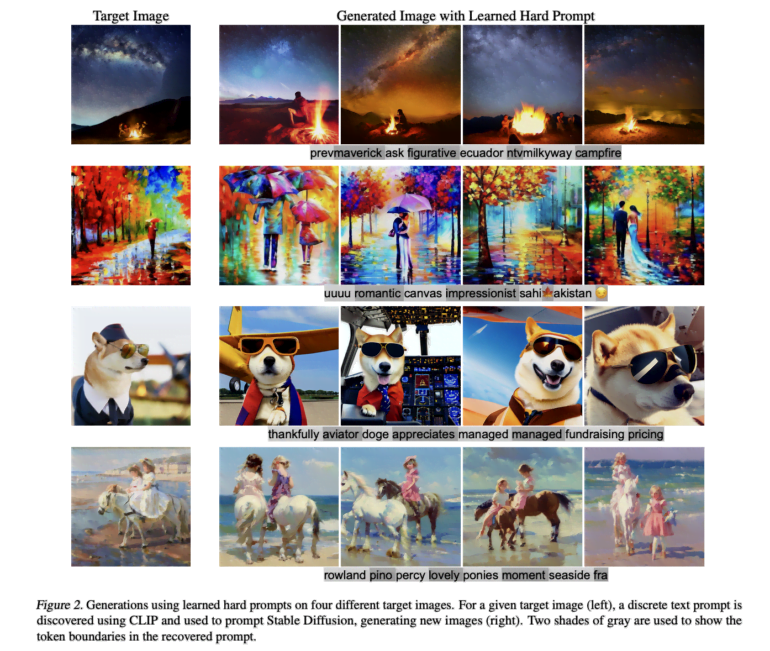

Mit PEZ stellt das Team dagegen eine Methode vor, die harte Prompts automatisch aus einem Input-Bild lernt. PEZ optimiert die Genauigkeit der gelernten Prompts während des Lernprozesses per CLIP. "Gelernte harte Prompts kombinieren die Einfachheit und Automatisierung weicher Prompts mit der Portabilität, Flexibilität und Einfachheit harter Prompts", heißt es in dem Artikel.

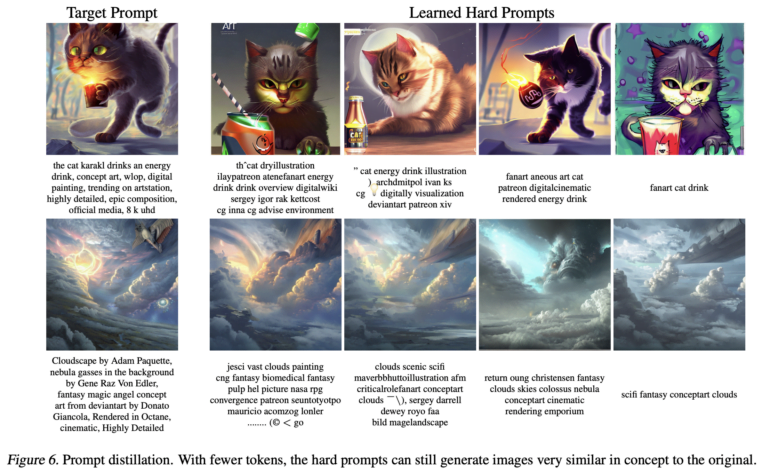

PEZ sei damit ein Werkzeug zur Generierung von Text-Prompts, die ohne aufwändige "Alchemie" zuverlässig bestimmte Bildstile, Objekte und Erscheinungsbilder erzeugen und sich dabei auf ähnlichem Niveau bewegen wie hochspezialisierte Werkzeuge zur Generierung weicher Prompts. Durch "Prompt Distillation" reduziert das Team zudem die Anzahl der benötigten Tokens.

Die erlernten harten Prompts lassen sich nach Aussage der Forscher:innen auch gut auf andere Modelle anwenden.

Methode an mehreren Datensätzen getestet

Das Team zeigt Beispiele für Prompts in vier Trainingsdatensätzen, namentlich LAION-5B (gemischt), Celeb-A (Prominenten-Portraits), MS COCO (Fotografie) und Lexica.art (KI-Bilder). Zur Generation der KI-Bilder haben sie Stable Diffusion verwendet.

Obwohl Unterschiede zwischen dem Original und dem generierten Bild erkennbar sind, erzeugen die gelernten harten Prompts deutlich erkennbare Variationen von Objekten, Kompositionen oder Stilen. Die Forscher:innen erwarten in Zukunft weitere Verbesserungen bei der automatisierten Entdeckung von Prompts und der Steuerung von generativen KI-Modellen wie Stable Diffusion.

Obwohl unsere Arbeit Fortschritte in Richtung einer zeitnahen Optimierung macht, ist das Verständnis der Community für den Embedding Space von Sprachmodellen noch in den Kinderschuhen. Ein tieferes Verständnis der Geometrie des Embedding-Spaces wird wahrscheinlich in Zukunft eine noch stärkere Prompt-Optimierung ermöglichen.

Aus dem Paper

Die Suche nach solchen effizienten Prompts könnte jedoch in Zukunft auch für die Reproduktion von Bildern in KI-Modellen genutzt werden. Jüngste Bemühungen um die KI-Reproduktion von Trainingsbildern haben bereits gezeigt, dass Diffusionsmodelle ein Reproduktionsproblem haben.

Das Team zeigt auch, dass PEZ geeignet ist, um Textprompts für große Sprachmodelle zu entdecken und diese beispielsweise für Klassifikationsaufgaben besser anzupassen.

Mehr Informationen und den Code gibt es bei GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.