Google PaLM-E verbindet Sprache, Sicht und Robotik

Mit PaLM-E stellen Google Robotics, die TU Berlin und Google Research ein neues KI-Modell vor, das Sprache erzeugen, Bilder verstehen und beides zusammen für komplexe Roboterbefehle nutzen kann.

PaLM-E umfasst 562 Milliarden Parameter und kombiniert Googles riesiges Sprachmodell PaLM mit ViT-22B, dem bisher größten Vision Transformer.

Die Hauptidee der PaLM-E-Architektur besteht darin, kontinuierliche, verkörperte Beobachtungen wie Bilder, Zustandseinschätzungen oder andere Sensormodalitäten in den Spracheinbettungsraum eines vortrainierten Sprachmodells zu injizieren.

Aus dem Paper

Video: Google

Das größte PaLM-E-Modell ist in der Lage, natürliche Sprache auf PaLM-Niveau zu verarbeiten, gleichzeitig aber auch Bildinhalte zu verstehen und zu beschreiben und durch die Kombination von Sprache und Computer Vision Roboter durch präzise, aufeinander aufbauenden Arbeitsschritten zu führen.

PaLM-E kann durch Sprach- und Bildverständnis Roboter durch die reale Welt führen. | Video: Google

Mit PaLM-SayCan zeigte Google bereits in der Vergangenheit, dass Sprachmodelle bei der Steuerung von Robotern helfen können. Der kombinierte Trainingsansatz von PaLM-E über verschiedene Domänen hinweg soll zu einer "signifikant höheren Leistung" im Vergleich zu rein für die Robotik optimierten Modellen führen.

Perhaps most exciting about PaLM-E is **positive transfer**: simultaneously training PaLM-E across several domains, including internet-scale general vision-language tasks, leads to significantly higher performance compared to single-task robot models. pic.twitter.com/sUqrX6U7BU

— Danny Driess (@DannyDriess) March 7, 2023

Wichtig ist, dass wir gezeigt haben, dass dieses vielseitige Training zu mehreren Übertragungswegen von der visuellen Sprache zur verkörperten Entscheidungsfindung führt, wodurch Roboterplanungsaufgaben dateneffizient durchgeführt werden können.

Aus dem Paper

PaLM-E beherrscht verschiedene Robotik- und Bildaufgaben

Google zeigt eine weitere Demo, in der PaLM-E einen Roboterarm steuert, der Blöcke anordnet. Die Besonderheit hier ist, dass der Roboter visuelle und sprachliche Eingaben parallel verarbeitet und für die Lösung der Aufgabe nutzt. So kann er beispielsweise Blöcke nach Farben sortiert in verschiedene Ecken schieben. PaLM-E generiert dabei aus dem visuellen Input Schritt für Schritt die Lösungsanweisungen.

Video: Google

Nach Ansicht des Forschungsteams zeigt das Modell auch die Fähigkeit zur Generalisierung. In der folgenden Demonstration bewegt es die roten Blöcke präzise und wie vorgegeben in Richtung des Kaffeebechers. In den Trainingsdaten gab es nur drei Beispiele mit Kaffeebechern, von denen keines rote Blöcke im Bild hatte.

Video: Google

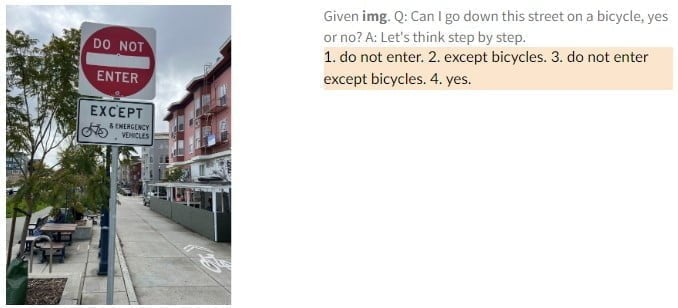

Ferner sei PaLM-E auch ein "kompetentes Bild-Sprach-Modell", schreiben die Forschenden. So erkennt es etwa den Basketballstar Kobe Bryant auf einem Bild und kann Text-Informationen über ihn generieren, etwa wie viele Meisterschaften er gewonnen hat. In einem anderen Beispiel sieht PaLM-E ein Verkehrsschild und erklärt, welche Regeln damit verbunden sind.

Die Sprachfähigkeiten von PaLM-E verlieren durch das multimodale und Robotertraining bei den kleineren PaLM-E-Modellen deutlich an Leistung. Dieses Phänomen ist als "katastrophales Vergessen" bekannt und wird normalerweise durch eingefrorene Sprachmodelle beim Training vermieden.

Der Leistungsabfall gegenüber dem größeren PaLM-Modell ist dagegen minimal, was nach Ansicht der Forscherinnen und Forscher zeigt, dass Skalierung gegen das katastrophale Vergessen helfen kann.

We observe a notable trend with model scale: the larger the language model, the more it maintains its language capabilities when training on visual-language and robotics tasks – quantitatively, the 562B PaLM-E model nearly retains all of its language capabilities. pic.twitter.com/sWrPOfGxhp

— Danny Driess (@DannyDriess) March 7, 2023

Darüber hinaus zeigt das größte PaLM-E-Modell mit 562 Milliarden Parametern emergente Fähigkeiten wie multimodale Gedankenketten und die Fähigkeit, über mehrere Bilder hinweg zu schlussfolgern, obwohl das Modell nur mit Einzelbild-Prompts trainiert wurde.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.