Med-PaLM 2: Google rollt medizinisches Sprachmodell für erste Tests aus

Update vom 17. Mai 2023:

Google hat das wissenschaftliche Paper zu Med-PaLM 2 veröffentlicht.

Update vom 14. April 2023:

Google Cloud kündigt an, dass Med-PaLM 2 in den kommenden Wochen an ausgewählte Google Cloud Kunden für einen "begrenzten Test" ausgerollt wird. Ziel sei es, sichere, verantwortungsvolle und sinnvolle Anwendungsszenarien zu untersuchen.

Das medizinische Sprachmodell könne "reichhaltige und informative Diskussionen erleichtern, komplexe medizinische Fragen beantworten und Erkenntnisse in komplizierten und unstrukturierten medizinischen Texten finden".

Darüber hinaus könne es kurze und lange Antworten auf medizinische Fragen generieren und Zusammenfassungen aus internen Dokumentationen und Datensätzen sowie aus wissenschaftlichen Quellen erstellen.

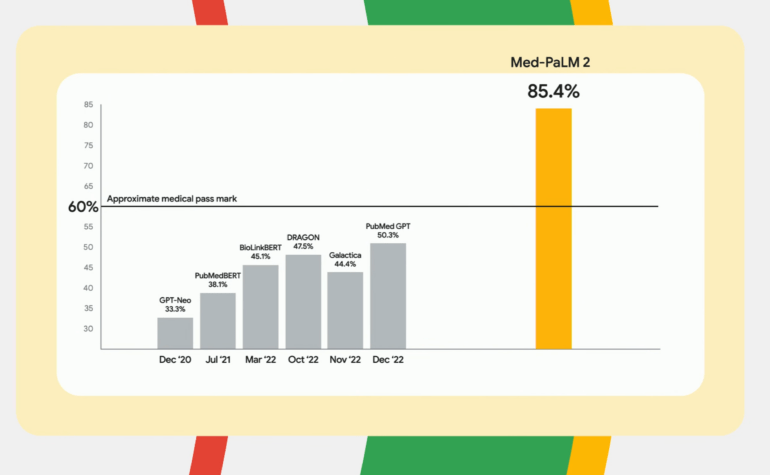

Laut Google ist Med-PaLM 2 das erste Sprachmodell, das bei Fragen im Stil der US Medical Licensing Examination (USMLE) mit einer Genauigkeit von mehr als 85 Prozent eine Leistung auf Expertenniveau erreicht hat. Im MedMCQA-Datensatz, der indische AIIMS- und NEET-Fragen für medizinische Prüfungen enthält, erreichte es ein "ausreichendes Ergebnis" von 72,3 Prozent.

Ursprünglicher Artikel vom 18. März 2023:

Med-PaLM 2: Googles Medizin-Sprachmodell soll Prüfungsfragen bestehen

Mit Med-PaLM entwickelt Google eine für medizinische Fragen optimierte Variante des PaLM-Sprachmodells. Die neueste Version soll bei medizinischen Prüfungsfragen verlässlich auf Experten-Niveau antworten.

Im Dezember letzten Jahres stellte Google Med-PaLM vor, eine für die Beantwortung medizinischer Fragen optimierte Version von Googles riesigem Sprachmodell PaLM (Pathways Language Model). Für die Entwicklung von Med-PaLM wurde eine spezielle Prompting-Methode in Kombination mit von Kliniker:innen geschriebenen Antworten auf medizinische Prompts verwendet.

In den anschließend getesteten Benchmarks erzielte Med-PaLM bei den meisten Aufgaben Ergebnisse auf dem Niveau von medizinischem Fachpersonal. Potenziell schädlich seien die generierten Antworten in 5,9 Prozent der Fälle gewesen, im Vergleich zu 5,7 Prozent bei menschlichen Expert:innen, so das Forschungsteam.

Med-PaLM sei zudem das erste KI-Modell, das medizinische Zulassungsfragen in den USA bestanden habe (67,2 Prozent korrekte Antworten), Multiple Choice und offene Fragen korrekt beantworten und seine Antworten begründen könne.

Med-PaLM 2 ist noch akkurater - aber hat noch Lücken

Im Rahmen der Google-Health-Veranstaltung "The Check Up" hat Google die Weiterentwicklung von Med-PaLM angekündigt: Die aktuelle Version, Med-PaLM 2, soll medizinische Prüfungsfragen auf Facharztniveau beantworten können und 85 Prozent der medizinische Zulassungsfragen richtig beantworten.

Damit erreicht Med-PaLM 2 eine Leistungssteigerung von 18 Prozent gegenüber dem Vorgängermodell und liegt weit über dem Niveau vergleichbarer Sprachmodelle bei medizinischen Aufgaben. Dennoch sieht das Team erheblichen Verbesserungsbedarf, damit Med-PaLM 2 den eigenen Ansprüchen an die Produktqualität gerecht wird. Über die technischen Veränderungen gegenüber Med-PaLM 1 schweigt sich das Team noch aus.

Getestet wurden Med-PaLM 2 nach 14 Kriterien, darunter wissenschaftliche Faktizität, Genauigkeit, medizinischer Konsens, Argumentation, Voreingenommenheit und Schaden, bewertet von Klinikerinnen und Nichtklinikern mit unterschiedlichem Hintergrund und aus verschiedenen Ländern. Dabei stellte das Team "erhebliche Lücken bei der Beantwortung medizinischer Fragen" fest, ohne die Defizite näher zu beschreiben.

In Zusammenarbeit mit Forschungsteams will Google Med-PaLM weiterentwickeln, um diese Lücken zu schließen und zu verstehen, wie das Sprachmodell die Gesundheitsversorgung verbessern kann. Das folgende Video zeigt die Ankündigung von Med-PaLM 2 ab circa Minute 16:30.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.