DragGAN: Eine neue Ära der Bildbearbeitung?

Update –

- Es gibt mittlerweile eine Demo für DragGAN, außerdem ist der Quellcode bei Github verfügbar.

DragGAN eröffnet eine völlig neue Kategorie der Bildbearbeitung, bei der fotorealistische Bilder von Nutzer:innen via Drag & Drop angepasst werden. Die Details übernimmt ein GAN.

Heutige Methoden der Bildbearbeitung, etwa mit Werkzeugen wie Photoshop, erfordern ein hohes Maß an Geschicklichkeit, wenn Position, Form, Ausdruck oder Anordnung einzelner Objekte flexibel und präzise gesteuert werden sollen. Eine andere Möglichkeit ist die Erzeugung völlig neuer Bilder durch generative KI wie Stable Diffusion oder GANs, die jedoch wenig Kontrolle bieten.

Mit DragGAN zeigen Forschende des Max-Planck-Instituts für Informatik, des Saarbrücken Research Center for Visual Computing, des MIT CSAIL und von Google nun eine neue Methode, GANs so zu steuern, dass sie die Bildberarbeitung ermöglichen.

DragGAN: Bildbearbeitung per Drag & Drop

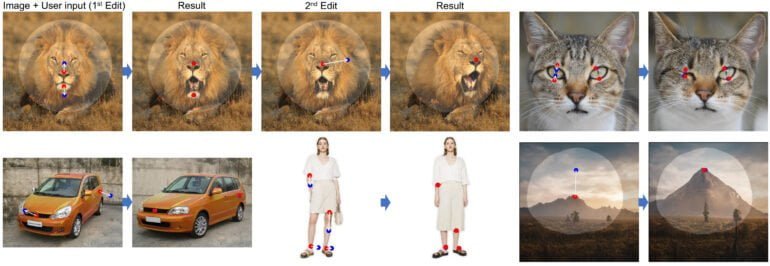

DragGAN kann fotorealistische Bilder verarbeiten, sofern die Darstellungen den Kategorien des GAN-Trainingsdatensatzes entsprechen. Dazu gehören beispielsweise Tiere, Autos, Menschen, Zellen oder Landschaften. Nutzer:innen ziehen dann in einem simplen Interface von ihnen festgelegte Punkte in einem Bild an gewünschte Positionen, um etwa die Augen einer Katze zu schließen, den Kopf eines Löwen zu drehen und das Maul zu öffnen oder ein Auto in ein anderes Modell zu verwandeln.

Video: Pan et al.

DragGAN verfolgt diese Punkte und erzeugt Bilder, die den gewünschten Veränderungen entsprechen.

DragGAN "führt in der Regel zu realistischen Ergebnissen"

"Mit DragGAN kann jeder ein Bild mit präziser Kontrolle über die Position der Pixel verformen und so die Pose, die Form, den Ausdruck und das Layout verschiedener Kategorien manipulieren", so das Team. "Da diese Manipulationen auf der gelernten generativen Bildvielfalt eines GAN durchgeführt werden, führen sie in der Regel zu realistischen Ergebnissen, selbst bei schwierigen Szenarien wie der Halluzination verborgener Inhalte und der Verformung von Formen, die konsequent der Rigidität des Objekts folgen."

Das Team zeigt in einem Vergleich, dass DragGAN anderen Ansätzen deutlich überlegen ist. Allerdings sind einige Änderungen immer noch von Artefakten begleitet, wenn diese außerhalb der Trainingsverteilung liegen.

Mehr Informationen gibt im Paper, auf Hugging Face oder auf der Projektseite von DragGAN.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.