Open-Source ToolLLaMA kann über 16.000 APIs ansteuern

Das auf API-Aufrufe spezialisierte Sprachmodell ToolLLaMA kann über 16.000 APIs zu nutzen und erreicht dabei die Performance von ChatGPT.

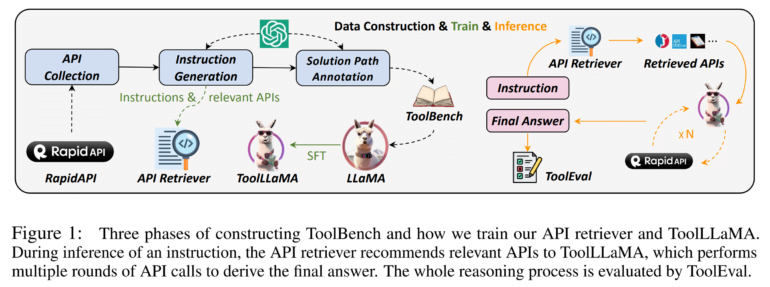

Chinesische Forschende haben mit ToolLLM ein Framework vorgestellt, das Open-Source-Modelle bei der Nutzung von APIs auf die Qualität von ChatGPT bringt - ein Aspekt, bei dem diese Modelle bisher weit hinter kommerziellen Angeboten zurücklagen.

ToolLLM basiert auf dem Open-Source-Modell LLaMA. Das Team trainierte das Meta-Modell mit einem hochwertigen Datensatz namens ToolBench, der automatisch mit ChatGPT generiert wurde, um das spezialisierte ToolLLaMA zu erstellen. ToolBench enthält Anweisungen mit entsprechenden API-Aufrufen aus 49 Kategorien.

Eine Anweisung könnte zum Beispiel lauten: "Ich organisiere einen Filmabend und brauche ein paar Filmvorschläge. Kannst du mir die besten Liebesfilme aus den USA heraussuchen und auch noch einen passenden Veranstaltungsort in meiner Nähe finden?" Um eine solche Anweisung zu lösen, muss das Modell die relevanten APIs korrekt aufrufen, zum Beispiel eine API für die Filmsuche und eine API für die Hotelsuche.

Entscheidungsbäume helfen bei Datensatzerstellung

Für die Erstellung des ToolBench-Datensatzes verwendet das Team auch eine Technik namens "Depth-First Search Decision Tree" (DFSDT), die es Sprachmodellen wie GPT-4 ermöglicht, mehrere Suchpfade zu verfolgen, um die beste Lösung für eine API-Anfrage zu finden. Den Forschenden zufolge zeigt DFSDT in Experimenten einen deutlichen Vorteil bei der Lösung schwieriger Aufgaben im Vergleich zum nativen Modell oder anderen Methoden wie Chain-of-Thought-Reasoning.

Um die Fähigkeiten von ToolLLaMA weiter zu verbessern, haben die Forschenden zusätzlich einen neuronalen API-Retriever trainiert, der automatisch relevante APIs für jede Anweisung aus einem gesamten Pool von über 16.000 APIs empfiehlt.

Durch die Integration des Retrievers in ToolLLaMA entsteht eine automatisierte Pipeline für die Nutzung komplexer Werkzeuge ohne die Notwendigkeit einer manuellen API-Auswahl.

ToolLLaMA erreicht bei API-Aufrufen ChatGPT-Qualität

Um die Fähigkeiten von ToolLLaMA zu bewerten, stellt das Team auch einen automatischen Modell-Evaluator namens ToolEval vor. Dieser misst zwei Schlüsselindikatoren - die Erfolgsrate (Fähigkeit, eine Anweisung erfolgreich abzuschließen) und die Gewinnrate (Vergleich der Lösungsqualität mit bestehenden Methoden).

Im ToolEval-Vergleich erreicht das Modell ToolLLaMA eine mit ChatGPT vergleichbare Erfolgsrate, obwohl es mit deutlich weniger Beispielen trainiert wurde. ToolLLaMA kann auch mit vorher unbekannten APIs erfolgreich umgehen, indem es deren Dokumentation liest. Dass das Studium solcher Dokumentationen erfolgreich sein kann, zeigt auch eine kürzlich veröffentlichte Studie von Google.

Mehr Informationen und Code gibt es auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.