Sprachmodelle wie OpenAIs GPT-3 sollen mit "Chain of Thought"-Prompting bessere Antworten geben. Was ist CoT-Prompting und was bringt es?

Autor*innen: Moritz Larsen, Prof. Dr. Doris Weßels

Die Nutzung von generativen KI-Sprachmodellen, wie GPT-3 von OpenAI, kann zu überraschenden Ergebnissen führen. Dies liegt an der fehlenden Überprüfbarkeit und Erklärbarkeit solcher „Black Box“-Systeme, die ein inhärentes Merkmal von Deep-Learning-Systemen sind. Die kontinuierlich wachsende Anzahl von Parametern korreliert positiv mit der Leistungsstärke der „Large Language Models (LLM)“.

Sie lösen Aufgaben immer besser, allerdings bleibt der Lösungsweg dabei in der Regel intransparent. Nun winkt ein Durchbruch mit dem sogenannten „Chain of Thought“-Prompting, abgekürzt CoT-Prompting. Bei diesem Verfahren wird das Modell aufgefordert, den Lösungsweg „Schritt für Schritt“ zu erläutern.

Prompts beschreiben die Anforderung an das gewählte Modell in natürlicher Sprache. Bei einem sogenannten „Zero-Shot-Prompt“ reicht eine Anweisung oder Frage wie „Erkläre den Begriff Chain of Thought-Prompting“ aus, um zu einem Ergebnis zu kommen. Je genauer die Formulierung, desto eher entsprechen die Ergebnisse den Erwartungen.

Zusätzlich können wir dem Modell genauer anhand von Beispielen erklären, wie wir uns das Ergebnis vorstellen. Ein Beispiel (One-Shot-Prompt) kann bereits ausreichen, mehrere Beispiele (Few-Shot-Prompt) unterweisen das Modell genauer. Schon kleine Veränderungen im Prompt können völlig andere Ergebnisse erzielen. Das Ziel des „Prompt-Designs“ oder „Prompt-Engineering“ besteht darin, den optimalen Prompt zu finden, sodass das Sprachmodell die vorgegebene Aufgabe bestmöglich löst (Liu et al. 2021). Kleine Ergänzungen der Eingabeaufforderung können in dieser Hinsicht zu einem qualitativ besseren Ergebnis führen.

Einen signifikanten Effekt hat die Hinzufügung des Satzes „Lass uns Schritt für Schritt überlegen …“ oder eine Form dieses Satzes, in der deutlich gemacht wird, dass ein schrittweises Vorgehen erforderlich ist. Das Sprachmodell wird dadurch angeregt, ein schrittweises Vorgehen zur Lösung einer Aufgabe darzustellen und auf diese Weise seine vermeintliche Gedankenkette für die Nutzer sichtbar zu machen. Die Google-Forscher konnten in ihren Experimenten mit verschiedenen Sprachmodellen nachweisen, dass die Qualität der Ergebnisse durch das CoT-Prompting ab einer bestimmten Modellgröße verbessert wird (Wei/Zhou 2022). Dies ist neben dem Transparenzgewinn ein weiterer großer Vorteil.

Wie "Chain of Thought"-Prompting die Ausgabe von Sprachmodellen beeinflusst

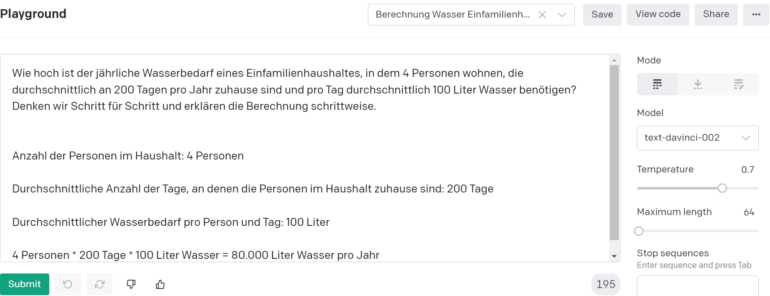

Die folgenden Beispiele, die wegen der zufallsgesteuerten Ergebnisproduktion zwangsläufig Unikate und nicht reproduzierbare Ergebnisse darstellen, wurden im Playground mit dem Modell Davinci-2 aus der Modellfamilie GPT-3 von OpenAI erstellt und sind als „cherry-picked“ Outputs zu bewerten.

Beispiel 1: Auswirkung von CoT-Prompting auf arithmetische Aufgaben

Das CoT-Prompting soll anhand einer arithmetischen Aufgabe erläutert werden. In Tabelle 1 ist auf der linken Seite der Eingabetext ohne CoT-Prompt dargestellt. Auf der rechten Seite ist der gleiche Eingabetext und zusätzlich der hier besonders relevante CoT-Prompt: „Denken wir Schritt für Schritt und erklären die Berechnung schrittweise“ zu sehen.

Im unteren Teil ist jeweils das KI-generierte Ergebnis abgebildet. Links ist es eine ausführliche Antwort, in der die Informationen aus der Aufgabenstellung wiederholt und das Ergebnis genannt werden. Auf der rechten Seite ist es eine Darstellung der vier Einzelschritte zur Erläuterung des Ergebnisses.

| Arithmetische Aufgabenstellung ohne CoT-Prompt: | Arithmetische Aufgabenstellung mit CoT-Prompt: |

| Wie hoch ist der jährliche Wasserbedarf eines Einfamilienhaushaltes, in dem vier Personen wohnen, die durchschnittlich an 200 Tagen pro Jahr zu Hause sind und pro Tag durchschnittlich 100 Liter Wasser benötigen? | Wie hoch ist der jährliche Wasserbedarf eines Einfamilienhaushaltes, in dem vier Personen wohnen, die durchschnittlich an 200 Tagen pro Jahr zu Hause sind und pro Tag durchschnittlich 100 Liter Wasser benötigen?

Denken wir Schritt für Schritt und erklären die Berechnung schrittweise. |

| Ergebnis ohne CoT-Prompt: | Ergebnis mit CoT-Prompt: |

| Der jährliche Wasserbedarf eines Einfamilienhaushaltes, in dem vier Personen wohnen, die durchschnittlich an 200 Tagen pro Jahr zu Hause sind und pro Tag durchschnittlich 100 Liter Wasser benötigen, beträgt 80.000 Liter. | Anzahl der Personen im Haushalt: 4 Personen

Durchschnittliche Anzahl der Tage, an denen die Personen im Haushalt zu Hause sind: 200 Tage Durchschnittlicher Wasserbedarf pro Person und Tag: 100 Liter 4 Personen * 200 Tage * 100 Liter Wasser = 80.000 Liter Wasser pro Jahr |

Tabelle 1: Vergleich der arithmetischen Aufgabenstellung ohne CoT-Prompt (links) und mit CoT-Prompt (rechts).

Dieses Beispiel zeigt, dass bereits erste Schritte in Richtung „Explainability“ durch ein intelligentes „Prompt-Design“ beschritten werden können. Die Erklärbarkeit ist allerdings nur auf den Output und die formalen Lösungsschritte bezogen, nicht auf die nach wie vor als „Black Box“ geltende innere Struktur des zugrunde liegenden Künstlichen Neuronalen Netzes (KNN) als Ergebnis des Deep Learning. Die durch das CoT-Prompting erzeugte Kette der (vermeintlichen) Gedanken einer KI darf nicht als der tatsächliche Einblick in die „Logik“ des KI-Modells fehlinterpretiert werden.

Beispiel 2: Verbessert CoT-Prompting die Erklärung eines Zitats?

Bei diesem weiteren Beispiel geht es um die Erläuterung eines Zitates. Als Zitat wurde die folgende Passage aus Hannes Bajohrs Text „Künstliche Intelligenz und digitale Literatur. Theorie und Praxis konnektionistischen Schreibens“ zur Frage der Autorschaft im Zusammenhang mit KI-generierten Texten gewählt:

„Der Bruch zwischen den Paradigmen berührt auch die Autorschaftsfrage, deren menschliche Seite im Mensch-Maschine-Gefüge eine zunehmende Distanzierung durchläuft: Konnte man im sequenziellen Paradigma noch plausibel von sekundärer Autorschaft sprechen, die in der Formulierung einer Regelfolge besteht, deren Ausführung das Werk produziert – hier ergibt die Idee eines »writer of writer« durchaus Sinn –, steht man bei KNNs vor einer tertiären Autorschaft: Es bleiben allein der Datensatz für das Training zu definieren, aus denen das KNN selbstständig das Modell bildet, und die Parameter zu bestimmen, mittels derer das Modell schließlich den Output hervorbringt. Bei großen Sprach-KIs wie GPT-3 ist selbst das nicht mehr möglich, denn das Training ist hier zu aufwändig, um es auf je neue Datensätze abzustimmen. Die ›Programmierung‹ erfolgt durch die normalsprachliche Formulierung von Aufforderungen (›prompt design‹) nach dem Vorbild dialogischer Kommunikation – hier wäre gar von quartärer Autorschaft zu sprechen.“ (Bajohr 2022)

Der Prompt auf der linken Seite besteht aus zwei Teilen: Der erste Teil ist das oben erwähnte Zitat (aus Platzgründen in der Tabelle mit dem Platzhalter <<ZITAT>> dargestellt). Der zweite Teil ist die Aufgabenstellung bzw. Frage „Was beschreibt dieses Zitat von Hannes Bajohr?“.

Der Prompt auf der rechten Seite enthält die gleichen Elemente und zusätzlich die entscheidende Formulierung „Überlegen wir schrittweise, um zu einer Schlussfolgerung zu gelangen.“, die die Darstellung des schrittweisen Vorgehens anregen soll.

| Aufgabenstellung ohne CoT-Prompt: | Aufgabenstellung mit CoT-Prompt: |

| <<ZITAT>>

Was beschreibt dieses Zitat von Hannes Bajohr? |

<<ZITAT>>

Was beschreibt dieses Zitat von Hannes Bajohr?

Überlegen wir schrittweise, um zu einer Schlussfolgerung zu gelangen. |

| Ergebnis ohne CoT-Prompt: | Ergebnis mit CoT-Prompt: |

| Dieses Zitat von Hannes Bajohr beschreibt den Bruch zwischen den sequenziellen und den KNN-Paradigmen. Im sequenziellen Paradigma ist es möglich, von sekundärer Autorschaft zu sprechen, die in der Formulierung einer Regelfolge besteht, deren Ausführung das Werk produziert. Bei KNNs ist es jedoch nur möglich, die Parameter zu bestimmen, mittels derer das Modell den Output hervorbringt. Bei großen Sprach-KIs wie GPT-3 ist selbst das nicht mehr möglich. | Zunächst wird davon ausgegangen, dass es im sequenziellen Paradigma eine sekundäre Autorschaft gebt [sic!], die aus einer Regelfolge besteht, deren Ausführung das Werk produziert. Diese Idee eines 'writer of writer' ergibt in diesem Kontext Sinn.

Im nächsten Schritt wird darauf hingewiesen, dass bei KNNs (künstlichen neuronalen Netzen) eine tertiäre Autorschaft vorliegt. Dies bedeutet, dass der Datensatz für das Training und die Parameter, mittels derer das Modell schließlich den Output hervorbringt, vom KNN selbstständig erstellt werden.

Im letzten Schritt wird erwähnt, dass bei großen Sprach-KIs wie GPT-3 sogar eine quartäre Autorschaft vorliegt. Dies bedeutet, dass das Training so aufwändig ist, dass es nicht mehr möglich ist, es auf je neue Datensätze abzustimmen. Die 'Programmierung' erfolgt hier durch die normalsprachliche Formulierung von Aufforderungen ('prompt design') nach dem Vorbild dialogischer Kommunikation.

In diesem Zitat wird also die Tatsache beschrieben, dass sich die Autorschaft von Werken im Zuge der Weiterentwicklung der künstlichen Intelligenz von einer sekundären hin zu einer tertiären und quartären Autorschaft verändert hat. |

Tabelle 2: Erläuterung eines Zitats ohne CoT-Prompt (links) und mit CoT-Prompt (rechts).

Vergleichen wir die Ergebnisse, wird auf den ersten Blick deutlich, dass der Output mit CoT-Prompt deutlich umfangreicher ist. Zu erkennen ist eine Aufzählungsstruktur. Zu dieser Strukturierung tragen auch die Zeilenumbrüche nach jedem Absatz bei, die neben dem Text ebenfalls durch das Sprachmodell generiert wurden. Durch die Strukturierung entsteht demnach der Eindruck, dass die einzelnen Aspekte des Zitates aufgegriffen werden und im letzten Schritt daraus eine Schlussfolgerung gezogen wird.

Das schrittweise Vorgehen wird hier sehr deutlich. Die Kernaussage des Zitats wird erkannt und in drei Abschnitte unterteilt und jeweils genannt, welche Form der Autorschaft damit verbunden ist. Im zweiten Abschnitt ist jedoch ein inhaltlicher Fehler enthalten. Dort steht, dass der Datensatz und die Parameter vom KNN selbstständig erstellt werden. Laut Bajohr ist dies allerdings gerade nicht der Fall, sondern es handelt sich dabei um genau die Elemente, die vom Menschen festgelegt werden.

Wie es zu diesem inhaltlichen Fehler kommt, können wir jedoch nicht nachvollziehen. Die Gedankenkette, genauer gesagt das schrittweise Abhandeln, um zu einer Schlussfolgerung zu gelangen, bleibt weiterhin ein Output des Sprachmodells, dessen Entstehung aufgrund der Black-Box-Problematik nicht nachvollziehbar ist. Im letzten Abschnitt wird die Hauptaussage schließlich korrekt zusammengefasst.

Der Output ohne CoT-Prompt ist hingegen ein einzelner Textblock. Es ist deutlich zu erkennen, dass kein schrittweises Vorgehen durch den Prompt angeregt wurde. Zwar ist auch hier eine Dreiteilung des Zitats erkennbar, sie wird jedoch nicht durch entsprechende Formulierungen und Formatierungen explizit gemacht.

Inhaltlich fasst der erste Satz die Kernaussage treffend zusammen. Allerdings wird im weiteren Verlauf nur die Form der sekundären Autorschaft genannt, die weiteren Formen werden nicht genannt. Inhaltliche Fehler finden sich in diesem Output nicht. So gesehen, kann dieser Output als teilweise extrahierte und reduzierte Form des Zitats betrachtet werden.

Wie diese Ergebnisse zu bewerten sind, ist u. a. abhängig von unserer subjektiven Erwartung. Doch führt der CoT-Prompt auch objektiv zu einem besseren Ergebnis? Der Output ohne CoT-Prompt enthält keinen inhaltlichen Fehler und fasst den Inhalt des Zitats im ersten Satz treffend zusammen, geht jedoch nicht in die Tiefe. Somit ist die Aufgabe („Was beschreibt dieses Zitat?“) erfüllt. Das Ergebnis des CoT-Prompts enthält jedoch einen inhaltlichen Fehler, kommt aber zu einer richtigen Schlussfolgerung und führt alle Formen der Autorschaft aus.

Die Frage nach dem richtigen Prompt und die Gefahr der Vermenschlichung

Beide Beispiele können nur einen kleinen Einblick geben, welche Möglichkeiten und Herausforderungen sich durch gezieltes Prompting ergeben. Vorlagen zu schreiben oder automatisiert schreiben zu lassen, ist eine anspruchsvolle Aufgabe, die Zeit und Erfahrung erfordern. Der Einsatz von KI in Sprachmodellen wird zukünftig im Bildungsbereich immer relevanter. Um erfolgreich mit KI umzugehen, ist es jedoch entscheidend, zu wissen, welche Art des Promptings das gewünschte Ergebnis hervorruft.

Mit der zunehmenden Nutzung von künstlicher Intelligenz (KI) stellt sich die Frage, ob und inwiefern diese neuen Technologien auch neue Risiken mit sich bringen. Eines dieser Risiken ist die Vermenschlichung einer KI, bei der einem KI-Sprachmodell menschliche Fähigkeiten und Denkweisen unterstellt werden (Larsen/Weßels 2022). Bei Google führte dies sogar zur Entlassung eines Mitarbeiters, der einer Sprach-KI ein Bewusstsein zuschrieb (Bastian 2022).

Ein voraussichtliches Risiko, das mit einer Vermenschlichung einhergeht, ist das Verringern oder Aufgeben einer kritischen Distanz. Dies könnte u. a. dann dazu führen, dass wir einem KI-System übermäßig vertrauen und Informationen preisgeben, die wir andernfalls für uns behalten würden (Weidinger et al. 2022).

Die aktuelle Entwicklung der exponentiell wachsenden Anzahl von Parametern bei KI-Sprachmodellen (Megatron-Turing NLG mit 530 Milliarden Parameter und PaLM mit 540 Milliarden Parametern) beflügelt sogar den Traum von einer starken KI. DALL·E 2, ebenfalls aus dem Hause OpenAI, ermöglicht den Weg von Text zu Image per Knopfdruck. Auch hier werden die Anweisungen in natürlicher Sprache gegeben (Zero-Shot-Prompt).

Noch weitreichendere Multi-Tasking-Fähigkeiten hat der KI-Agent Gato von DeepMind, der zusätzlich noch Bewegungen ausüben können soll. Kersting spricht in diesem Zusammenhang von einer „Zeitenwende“, da bei neuronalen Sprachmodellen Größe und Fähigkeiten korrelieren (Kersting 2022). Er betont die Notwendigkeit, ein eigenes KI-Ökosystem für Deutschland aufzubauen, um die Abhängigkeit von amerikanischen oder auch asiatischen KI-Sprachmodellen zu reduzieren, die mit ihren Trainingsdaten naturgemäß auch ihre Kultur und Wertvorstellungen inhärent in sich tragen und bei der Textgenerierung widerspiegeln.

Über die Autor:innen

Moritz Larsen: Masterstudierender der Christian-Albrechts-Universität Kiel für Pädagogik, Sprache und Variation; Projektmitarbeiter im KI-Projekt „Das akademische Schreiben von Studierenden im Zeitalter KI" des Forschungs- und Entwicklungszentrums der Fachhochschule Kiel.

Doris Weßels: Professorin für Wirtschaftsinformatik mit den Schwerpunkten Projektmanagement und Natural Language Processing an der Fachhochschule Kiel; Projektleiterin des KI-Projektes „Das akademische Schreiben von Studierenden im Zeitalter KI" und Leiterin des Virtuellen Kompetenzzentrums für „Schreiben lehren und lernen mit Künstlicher Intelligenz - Tools und Techniken für Bildung und Wissenschaft“.

Literaturverzeichnis

- Bajohr, H. (2022): Schreibenlassen: Texte zur Literatur im Digitalen. Erste Auflage. Berlin.

- Bastian, M. (2022): Forscher hält neue Google-KI für bewusst – und wird gefeuert. In: The Decoder. (23.06.2022).

- Kersting, K. (2022): Kommentar von Kristian Kersting: Zeitenwende in der Künstlichen Intelligenz. In: iX Magazin/heise online. https://www.heise.de/meinung/Kommentar-von-Kristian-Kersting-Zeitenwende-in-der-Kuenstlichen-Intelligenz-7132372.html (6. Juni 2022).

- Larsen, M./Weßels, D. (2022): Chain of Thought Prompting - KI-Transfer Hub SH. https://kuenstliche-intelligenz.sh/de/chain-of-thought-prompting (22. August 2022).

- Liu, P./Yuan, W./Fu, J./Jiang, Z./Hayashi, H./Neubig, G. (2021): Pre-train, Prompt, and Predict: A Systematic Survey of Prompting Methods in Natural Language Processing.

- OpenAI: GPT-3. https://openai.com/ (25. Juli 2022).

- Wei, J./Zhou, D. (2022): Language Models Perform Reasoning via Chain of Thought: Google AI Blog. https://ai.googleblog.com/2022/05/language-models-perform-reasoning-via.html (11.05.2022).

- Weidinger, L./Uesato, J./Rauh, M./Griffin, C./Huang, P.-S./Mellor, J./Glaese, A./Cheng, M./Balle, B./Kasirzadeh, A./Biles, C./Brown, S./Kenton, Z./Hawkins, W./Stepleton, T./Birhane, A./Hendricks, L. A./Rimell, L./Isaac, W./Haas, J./Legassick, S./Irving, G./Gabriel, I. (2022): Taxonomy of Risks posed by Language Models. In: 2022 ACM Conference on Fairness, Accountability, and Transparency. New York, NY, USA. S. 214–229. https://doi.org/10.1145/3531146.3533088.