Schau dir den Sci-Fi-Kurzfilm "The Last Artist" an, der mit KI generiert wurde

Nach Text und Bild erobert KI allmählich auch bewegte Bilder. Ein ambitionierter KI-Regisseur teilt seine ersten Ergebnisse und seinen Workflow auf Reddit.

Der YouTube-Kanal "Machine_Mythos" experimentiert mit Text-zu-Video-Modellen und anderen KI-Tools, um Kurzfilme mit KI zu generieren. Für das Video "The Day Hell Froze Over" verwendete der KI-Regisseur eine Kombination aus KI-generierten animierten Bildern und dem Text-zu-Video-Modell Runway Gen-2.

https://www.youtube.com/watch?v=rMoOuH9of_M

Die folgende Anleitung von Machine Mythos bezieht sich auf Runway-Gen 2. Für das Video galt noch die 4-Sekunden-Grenze für Runway-Videos, die mittlerweile auf 18 Sekunden angehoben wurde. Das Erstellen von zusammenhängenden Filmen mit längeren Szenen sollte also schon deutlich einfacher sein als im Beispiel oben. Hier der grundlegende Workflow von Machine Mythos für "The Day when Hell Froze Over".

-

Ich wähle zuerst die Musik aus, weil sie mir normalerweise hilft, die Schnitte flüssig zu gestalten. Ich achte auch darauf, dass ich die Bewegung aus den vorherigen Aufnahmen übernehme. Das ist nur eine grundlegende Anleitung, aber es sollte der erste Schritt sein, bevor man irgendetwas macht.

-

Dann erstelle ich das Bild in Midjourney oder Stable Diffusion und verbessere es, bis es fast perfekt ist. Ein genaues Ausgangsbild spart viel Zeit und Geld. Verwende Inpainting, Outpainting usw. Alle Bilder sollten die gleichen Ankerpunkte haben, um ein einheitliches Erscheinungsbild zu gewährleisten. Variationen sind eine gute Möglichkeit, verschiedene Blickwinkel auf ein und dasselbe Motiv zu erhalten. Dies ist wegen des 4-Sekunden-Limits notwendig.

-

Ich verwende hauptsächlich Bild- und Text-Prompts, da Bild-Prompts allein nicht genug Bewegung erzeugen und nicht kontrolliert werden können. Spam den Vorschau-Button, er ist kostenlos (Anm. d. Red.: Der Vorschaubutton in Runway erzeugt ein Bild der Szene, bevor sie als Video animiert wird.)

Achte auf alle Anzeichen von Bewegung und generiere keine Dinge, bei denen Bewegung unwahrscheinlich ist. Wenn du auf statische Dinge stößt oder Dinge, die schrecklich aussehen, ändere einfach deine Strategie, es hat keinen Sinn, darauf herumzuhacken.Man kann Screenshots vom Video machen und sie in Photoshop bearbeiten, um sie wieder in den Prozess einzufügen und für Konsistenz zu sorgen.

-

Interpolation, Zeitlupe, Umkehrung des Filmmaterials usw. - Es gibt selten eine Einstellung, die nicht gerettet werden kann. Die Geschichte kann so verändert werden, dass sie zu dem passt, was zu sehen ist.

Als weiteren Tipp für visuelle Konsistenz bei Runway nennt Machine Mythos eine sehr genaue Beschreibung im Prompt. Vermutlich aufgrund der begrenzten Trainingsmenge des Runway-Modells führe dies automatisch zu ähnlichen Ergebnissen. Weitere Methoden für mehr Konsistenz seien Bildprompts und eindeutige, kategorische Namen für Charaktere, die dann in weiteren Prompts verwendet werden können.

Für das Upscaling bevorzugt der KI-Regisseur "Topaz Labs", das je nach Szene bessere Ergebnisse liefern kann als das direkte Upscaling von Runway. Insgesamt, macht Machine Mythos deutlich, benötigt man im KI-Filmprozess noch Geduld und Experimentierfreude.

Pika Labs: Neue Text-to-Video-Plattform generiert Science-Fiction-Kurzfilm "The Last Artist"

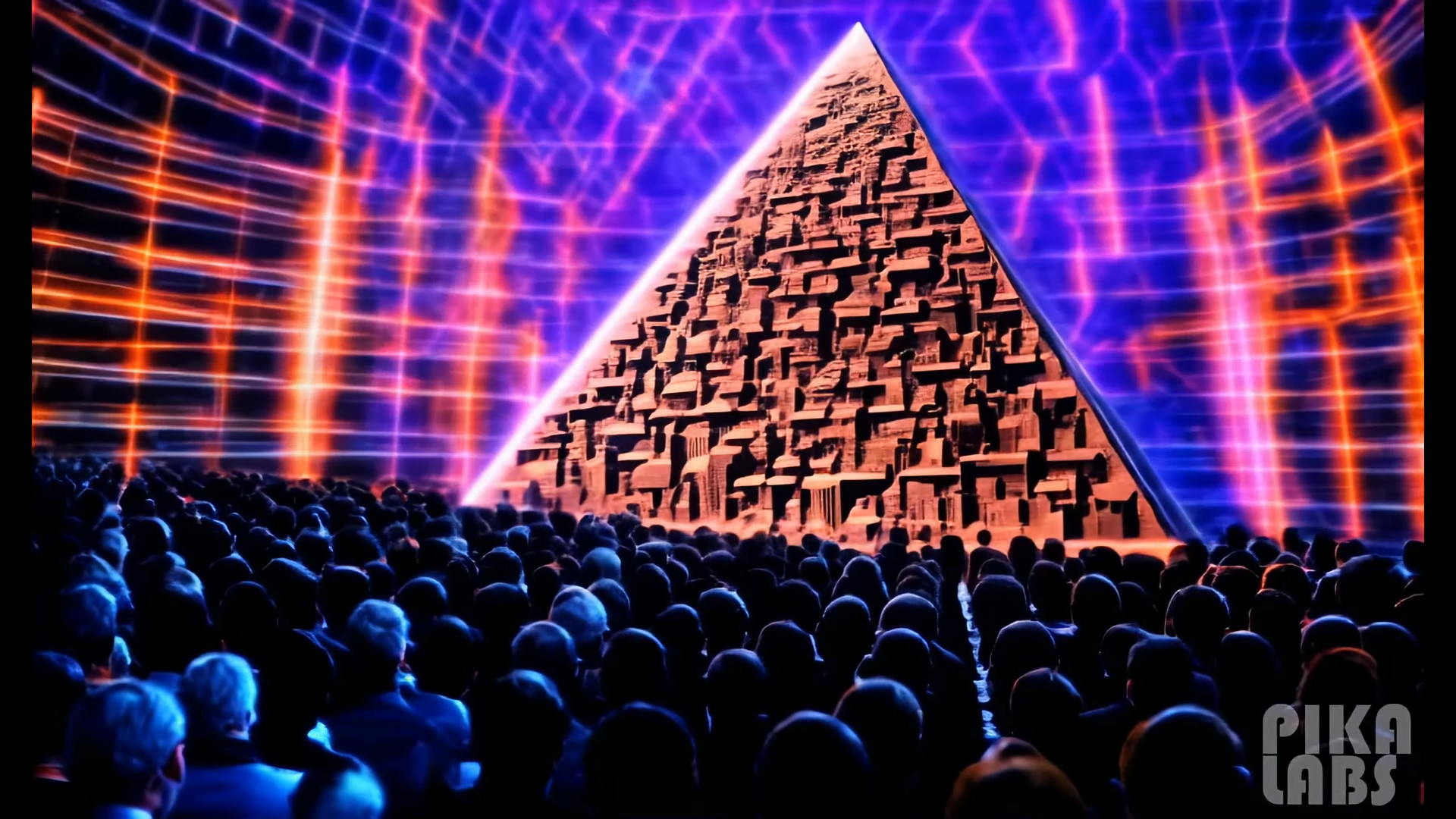

Für den neuesten KI-Kurzfilm "The Last Artist" nutzte der KI-Regisseur die Text-to-Video-Plattform "Pika Labs", die derzeit als Beta-Version verfügbar ist. Pika Labs kann wie Midjourney über Discord gesteuert werden.

Mit dem Befehl "/create" und einer textuellen Beschreibung wird ein drei Sekunden langes Video erzeugt. Weitere Parameter für das Seitenverhältnis oder die Bewegungsintensität dienen zur Feinabstimmung des Prompts. Das folgende Video zeigt einige Beispielvideos, die mit Pika Labs erstellt wurden.

Laut Machine Mythos ist es viel einfacher, epische und visuell beeindruckende Szenen zu generieren als einfache Dialogszenen oder grundlegende Interaktionen. Für den Anfang erwartet er daher vorwiegend hybride Filme mit gefilmten und generierten Szenen. Langfristig sieht er KI-generierte Inhalte im Vorteil: "Nur der hochwertigste von Menschen produzierte Inhalt wird bleiben, aber ich denke, er wird bleiben."

Die Videosequenzen des folgenden Sci-Fi-Kurzfilms "The Last Artist" wurden vollständig mit Pika Labs generiert.

https://www.youtube.com/watch?v=o9Lngj3K9Iw

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.