OpenAI führt neues Sprachmodell InstructGPT-3.5 ein

OpenAI stellt "gpt-3.5-turbo-instruct" vor, ein neues KI-Modell für Instruktionen, das genauso leistungsfähig ist wie das für Chat optimierte GPT-3.5 Turbo.

OpenAI führt "gpt-3.5-turbo-instruct" als Ersatz für die bisherigen Instruct-Modelle sowie für text-ada-001, text-babbage-001, text-curie-001 und die drei text-davinci-Modelle ein, die am 4. Januar 2024 eingestellt werden.

Die Kosten und die Performance von "gpt-3.5-turbo-instruct" liegen auf dem Niveau der bisherigen GPT-3.5-Modelle mit 4K-Kontextfenster. Die Trainingsdaten des Modells sind auf dem Stand von September 2021.

Laut OpenAI wurde gpt-3.5-turbo-instruct "ähnlich trainiert" wie frühere Instruct-Modelle. Das Unternehmen nennt keine Details oder Benchmarks für das neue Instruct-Modell und verweist stattdessen auf die damalige Ankündigung von InstructGPT im Januar 2022, das wiederum die Grundlage für GPT-3.5 war.

Die generelle Ansage von OpenAI ist, dass GPT-4 komplexe Anweisungen besser befolgt als GPT-3.5 und eine höhere Qualität generiert als GPT-3.5, das dafür aber deutlich schneller und billiger ist.

Gpt-3.5-turbo-instruct ist anders als GPT-3.5 kein Chat-Modell. Statt auf Gespräche ist es auf die direkte Beantwortung von Fragen oder die Vervollständigung von Texten optimiert. Es soll dabei ebenso schnell sein wie GPT-3.5 in der Turboversion.

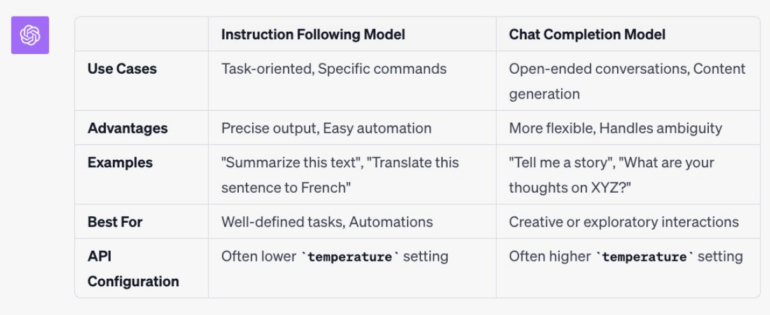

Die folgende Grafik zeigt eine von OpenAI autorisierte Unterscheidung zwischen Instruct- und Chat-Modellen. Die Unterscheidung kann beeinflussen, wie Prompts geschrieben werden müssen.

Der bei OpenAI für Entwicklerbeziehungen verantwortliche Logan Kilpatrick bezeichnet das neue Instruct-Modell als Übergangslösung für den Umstieg auf das Chat-Modell 3.5 Turbo. Es sei keine "langfristige Lösung".

Wer feingetunte Modelle im Einsatz hat, muss das Feintuning auf Basis der neuen Modellversionen erneut durchführen. Das Feintuning-Feature ist für GPT-3.5 verfügbar, GPT-4 soll später in diesem Jahr erscheinen.

Instruct-Modelle sind die Basis für ChatGPTs Durchbruch

Instruct-Modelle sind große Sprachmodelle, die nach einem Vortraining mit vielen Daten durch menschliches Feedback (RLHF) verfeinert werden. Dabei bewerten Menschen den Output des Modells auf von Nutzern gestellte Prompts und verbessern ihn, um ein gewünschtes Endergebnis zu erzielen, mit dem das Modell dann weiter trainiert wird.

Instruct-Modelle sind dadurch besser in der Lage, menschliche Anfragen zu verstehen und wie erwartet zu beantworten, wobei sie weniger Fehler machen und weniger bösartige Inhalte verbreiten. OpenAI-Tests haben gezeigt, dass Menschen ein InstructGPT-Modell mit 1,3 GB einem GPT-Modell mit 175 GB vorziehen, obwohl es 100 Mal kleiner ist.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.