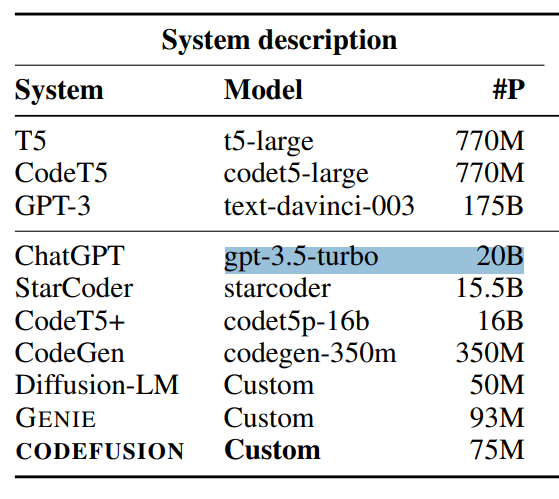

GPT-3.5 von OpenAI könnte ein anschauliches Beispiel für das Effizienzpotenzial großer KI-Modelle sein.

Denn das Modell hinter der freien ChatGPT-Variante soll "nur" 20 Milliarden Parameter haben. So steht es in einem von Microsoft veröffentlichten Benchmark-Papier für ein Code-Modell. OpenAI hatte sich bei der Vorstellung von GPT-3.5 nicht zur Parameterzahl geäußert.

Der "Leak" ist insofern interessant, als OpenAI das im Mai 2020 vorgestellte Modell GPT-3 mit 175 Milliarden (!) Parametern vermutlich deutlich destillieren und komprimieren und damit Effizienzgewinne bei Inferenz und Geschwindigkeit erzielen konnte. Mit GPT-3.5 hat OpenAI die Generierungsgeschwindigkeit erhöht und gleichzeitig die Kosten deutlich gesenkt.

Das Beispiel zeigt auch, dass die reine Modellgröße wahrscheinlich weniger wichtig ist als die Vielfalt und Qualität der Daten sowie der Trainingsprozess. In GPT-3.5 verwendete OpenAI zusätzliches menschliches Feedback (RLHF), um die Ausgabequalität zu optimieren.

Kommt GPT-4.5?

Die spannende Frage ist nun, ob OpenAI mit GPT-4 ein ähnliches Kunststück gelingt. GPT-4 soll auf einer wesentlich komplexeren Mixture-of-Expert-Architektur basieren, die 16 KI-Modelle mit ~111 Milliarden Parametern zu einem gigantischen ~1,8 Billionen Parametern verbindet.

Die Inferenz von GPT-4 ist deutlich teurer als die der anderen KI-Modelle. GPT-3.5 liegt bei $0.0048 pro 1000 Token, GPT-4 8K hingegen ist mit $0.072 pro 1000 Token 15x teurer. Allerdings ist auch die Qualität deutlich besser als bei GPT-3.5.

Insbesondere das ursprüngliche GPT-4-Modell "0314" von OpenAI vom März 2023 folgt den Eingabeaufforderungen genauer und erzeugt qualitativ hochwertigere Generierungen als GPT-3.5. Es übertrifft nach unseren wiederholten anekdotischen Tests auch das neuere GPT-4-Modell "0613" von OpenAI vom Sommer, das dafür Texte deutlich schneller schreibt.

Möglicherweise hat OpenAI hier bereits an der Effizienzschraube gedreht. Microsoft und die Open-Source-Entwicklung üben Berichten zufolge Druck auf die Margen von OpenAI aus.

OpenAI-CEO Sam Altman sagte im April 2023, dass er glaube, dass die Ära der großen Modelle vielleicht zu Ende gehe und man die Modelle "auf andere Weise" verbessern werde. Datenqualität dürfte hier ein entscheidender Faktor sein.