Gaia 9B: Wayve stellt neues generatives KI-Modell fürs autonome Fahren vor

Im Juni 2023 stellte das britische Start-up Wayve, das sich auf KI-gestütztes autonomes Fahren spezialisiert hat, mit GAIA-1 (Generative Artificial Intelligence for Autonomy) ein generatives Modell für autonomes Fahren vor. Jetzt berichtet das Unternehmen über Fortschritte bei der Entwicklung.

GAIA-1 erzeugt aus Texten, Bildern, Videos und Aktionsdaten synthetische Videos von einer Vielzahl von Verkehrssituationen, die dann für das Training autonomer Autos verwendet werden können.

Damit soll die Datenlücke geschlossen werden, die durch die Komplexität des Straßenverkehrs entsteht: Es ist kaum möglich, alle theoretisch denkbaren Verkehrssituationen auf Video festzuhalten, etwa einen Fußgänger, der im Nebel hinter einem Lastwagen hervorspringt, während gleichzeitig ein Motorradfahrer zum Überholen ansetzt und ein Radfahrer entgegenkommt.

Vom Video- zum Weltmodell

Laut Wayve ist GAIA-1 kein "Standard-generierendes Videomodell", sondern ein "echtes Weltmodell", das "lernt, die wichtigsten Konzepte des Fahrens zu verstehen und zu entwirren". Es verstehe und trenne Konzepte wie verschiedene Fahrzeuge und ihre Eigenschaften, Straßen, Gebäude oder Ampeln.

GAIA-1 lernt, die Umgebung und ihre zukünftige Dynamik zu repräsentieren und bietet so ein strukturiertes Verständnis der Umgebung, das für informierte Entscheidungen während der Fahrt genutzt werden kann.

Die Vorhersage zukünftiger Ereignisse ist ein entscheidender Aspekt autonomer Systeme, da eine genaue Vorhersage der Zukunft es autonomen Fahrzeugen ermöglicht, ihre Aktionen vorherzusehen und zu planen, was die Sicherheit und Effizienz im Straßenverkehr erhöht.

Das Modell verwendet Video-, Text- und Aktionsdaten, um realistische Fahrzeugvideos zu generieren und bietet eine feinkörnige Steuerung des Fahrzeugverhaltens und der Szenenmerkmale. Aufgrund seines multimodalen Charakters ist GAIA-1 in der Lage, Videos aus einer Vielzahl von Eingabearten und -kombinationen zu generieren.

Seit der ersten Vorstellung im Juni hat das Team GAIA-1 optimiert, um effizient hochauflösende Videos zu generieren und die Qualität des Weltmodells durch umfangreiches Training zu verbessern.

Das jetzt 9-Milliarden-Parameter umfassende Modell, die Juni-Version hatte nur eine Milliarde Parameter, ermöglicht zudem eine präzise Steuerung des Fahrzeugverhaltens und der Szenencharakteristika in Videos. Es soll ein leistungsfähiges Werkzeug für das Training und die Validierung von autonomen Fahrsystemen sein.

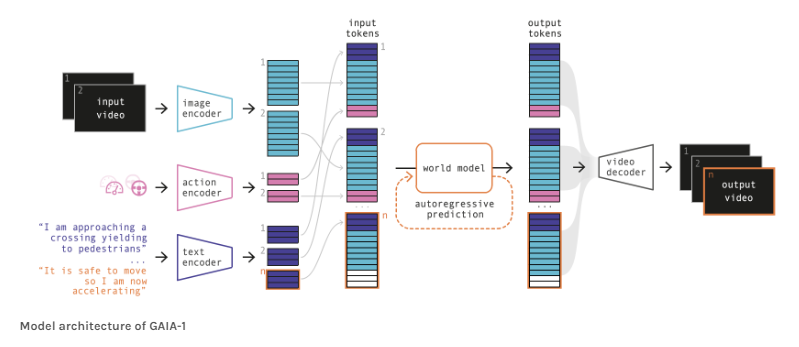

Das GAIA-1-Modell von Wayve wurde mit 4.700 Stunden proprietärer Fahrdaten trainiert, die zwischen 2019 und 2023 in London, Großbritannien, gesammelt wurden. Die Modellarchitektur umfasst spezialisierte Encoder für jede Eingabemodalität (Video, Text und Aktion), das Weltmodell, ein autoregressiver Transformer, und einen Video-Decoder, ein Video-Diffusionsmodell, das die vorhergesagten Bildelemente zurück in den Pixelraum übersetzt.

Skalierungsgesetze greifen auch bei der Videogenerierung

Die Formulierung der Weltmodellierungsaufgabe in GAIA-1 ähnelt stark dem Ansatz, der üblicherweise für große Sprachmodelle (LLMs) verwendet wird, bei denen die Aufgabe auf die Vorhersage des nächsten Tokens vereinfacht wird.

Diese Methodik wird in GAIA-1 auf Videomodellierung anstelle von Sprache angewendet. Das lässt vermuten, dass sich die Leistung und Effizienz von GAIA-1 bei der Videogenerierung mit zunehmender Modellgröße und Trainingsdatenmenge weiter verbessern wird, ähnlich den Skalierungstendenzen, die bei großen Sprachmodellen in ihren jeweiligen Domänen beobachtet wurden. Die Entwickler sehen weiter "signifikanten Raum für Verbesserungen" durch mehr Daten und Rechenleistung beim Training.

GAIA-1 modelliert verschiedene Zukünfte und reagiert auf plötzliche Veränderungen

GAIA-1 kann aus kontextbezogenen Videobildern der Vergangenheit verschiedene Zukünfte vorhersagen. Dazu gehören das Verhalten von Fußgängern, Radfahrern, Motorradfahrern und der Gegenverkehr. So kann das Modell die Interaktion mit anderen Verkehrsteilnehmern berücksichtigen und auf Situationen reagieren.

In einem Beispiel wird das Kamerafahrzeug durch eine Rechtslenkbewegung zum Verlassen der Fahrspur gezwungen und anschließend wieder zurückgelenkt. Interessanterweise reagierte das entgegenkommende Fahrzeug mit einem Ausweichmanöver, um eine Kollision zu vermeiden. Das zeige die Fähigkeit des Modells, potenzielle Gefahren im Straßenverkehr zu antizipieren und darauf zu reagieren.

GAIA-1 kann durch Eingabe von Text kontrolliert werden. Beispielsweise kann das Modell Fahrszenen mit dem Textbefehl "Es ist" gefolgt von "sonnig", "regnerisch", "neblig" oder "schneebedeckt" erzeugen. Es kann auch Szenen mit unterschiedlichen Lichtverhältnissen erzeugen, indem Textbefehle wie "Es ist Tag, wir sind im direkten Sonnenlicht", "Der Himmel ist grau", "Es ist Dämmerung" und "Es ist Nacht" verwendet werden.

Auf seiner Website demonstriert Wayve das Verhalten des Modells anhand zahlreicher weiterer Beispiele.

Wayve berichtet auch über die Grenzen von GAIA-1: Der autoregressive Generierungsprozess ist zwar effektiv, benötigt aber viel Rechenzeit, was die Generierung langer Videos sehr rechenintensiv macht.

Darüber hinaus ist das aktuelle Modell hauptsächlich auf die Vorhersage von Einzelkameraausgaben ausgerichtet, während für das autonome Fahren eine Gesamtsicht aus allen umgebenden Blickwinkeln entscheidend ist.

Zukünftige Arbeiten werden die Fähigkeiten des Modells erweitern, um diese breitere Perspektive zu erfassen und seine Generierungseffizienz zu optimieren, um die Technologie anwendbarer und effizienter zu machen.

Neben GAIA-1 entwickelt Wayve auch Lingo-1, ein autonomes Fahrsystem, das maschinelles Sehen mit textbasierter Logik kombiniert, um Entscheidungen und Situationen auf der Straße zu erklären. Diese textbasierte Logik könnte unter anderem das Sicherheitsgefühl im Auto erhöhen, da die Entscheidungen der KI weniger wie eine "Black Box" wirken.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.