ChatGPT bekommt PDF- und Datei-Chat mit GPT-4 32K für extra lange Dokumente

Offensichtlich hat OpenAI mit dem Übergang zum All-GPT-4-Modell, das alle GPT-4-Modelle integriert, eine weitere wesentliche Änderung vorgenommen.

OpenAI rollt gerade das neue "GPT-4 (All Tools)"-Modell aus, das automatisch die besten Werkzeuge wie Browsing, Advanced Data Analytics oder DALL-E 3 auswählt.

Das Modell kann zudem deutlich längere Inhalte in einem Durchgang verarbeiten, nämlich bis zu 32.000 Token, was etwa 25.000 Wörtern entspricht. Dadurch können Nutzer etwa mit längeren PDFs ohne externe Vektordatenbank chatten. Hinzu kommt ein Kontextfenster von 2,7K für den System-Prompt.

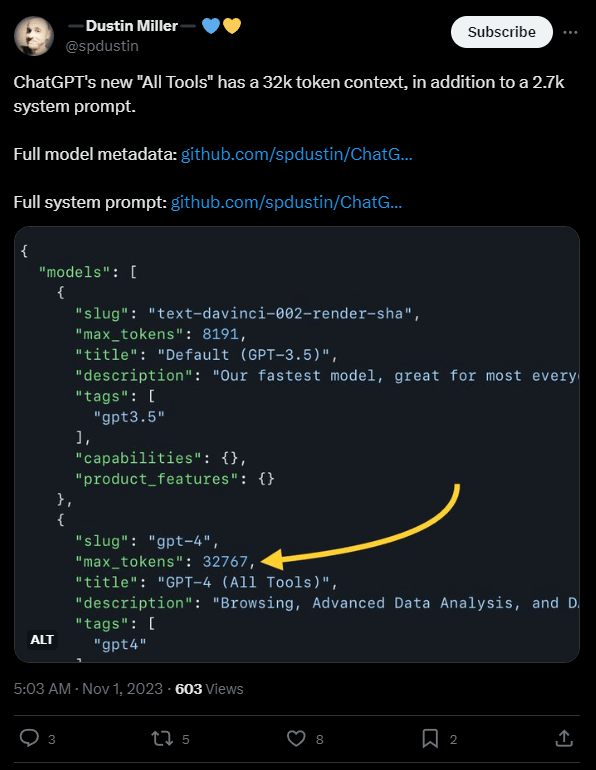

Dies berichtet der Entwickler Dustin Miller auf twitter.com und beruft sich dabei auf einen Code-Fund. Ein anderer Nutzer bestätigt die Beobachtung anhand eines langen Dokuments mit 16.000 Wörtern, das ChatGPT mit GPT-4-All analysieren konnte.

OpenAI stellte das 32K-Modell erstmals bei der Vorstellung von GPT-4 im März vor, beschränkte den Zugang aber zunächst auf ausgewählte Nutzerinnen und dann auf die Programmierschnittstelle, wohl auch aus Kostengründen. Das 32K-Modell ist noch teurer als das 8K-Modell, das über die API bereits 15x teurer ist als GPT-3.5.

Wenn OpenAI jetzt das 32K-Modell flächendeckend in ChatGPT einführt, könnte das bedeuten, dass es die Kostenseite besser im Griff haben. Interessant ist die Frage, ob das Unternehmen diesen Vorteil an die Entwicklergemeinde weitergeben wird. Ein geeigneter Zeitpunkt für eine Ankündigung wäre die OpenAI Entwicklerkonferenz am 6. November.

Der LLM-Wettbewerb nimmt zu

Ein weiterer Grund für die Erweiterung des Kontextfensters könnte sein, dass OpenAIs Hauptkonkurrent Anthropic den Rollout seines eigenen Chatbots Claude 2 im Web und über Programmierschnittstellen beschleunigt. Google und Amazon investierten zuletzt bis zu sechs Milliarden US-Dollar in Anthropic.

Das Alleinstellungsmerkmal von Claude 2 ist ein Kontextfenster von 100K (ca. 75.000 Wörter), also immer noch ca. dreimal so groß wie GPT-4 mit 32K, das aber immerhin ein deutliches Upgrade zum 8K-Kontextfenster (4.000 bis 6.000 Wörter) des ursprünglichen GPT-4-Modells in ChatGPT ist.

Außerdem steht Googles Gemini vor der Tür, das neben Multimodalität ebenfalls auf ein großes Kontextfenster setzen könnte.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.