MagicAnimate & Animate Anyone: Chinas Tech-Riesen forschen an automatisierten TikToks

Generative KI kann fotorealistische Bilder erzeugen, erste Modelle können Videos generieren. Bytedance und Alibaba zeigen nun jeweils Modelle, die fotorealistische Videoclips von animierten Menschen erzeugen.

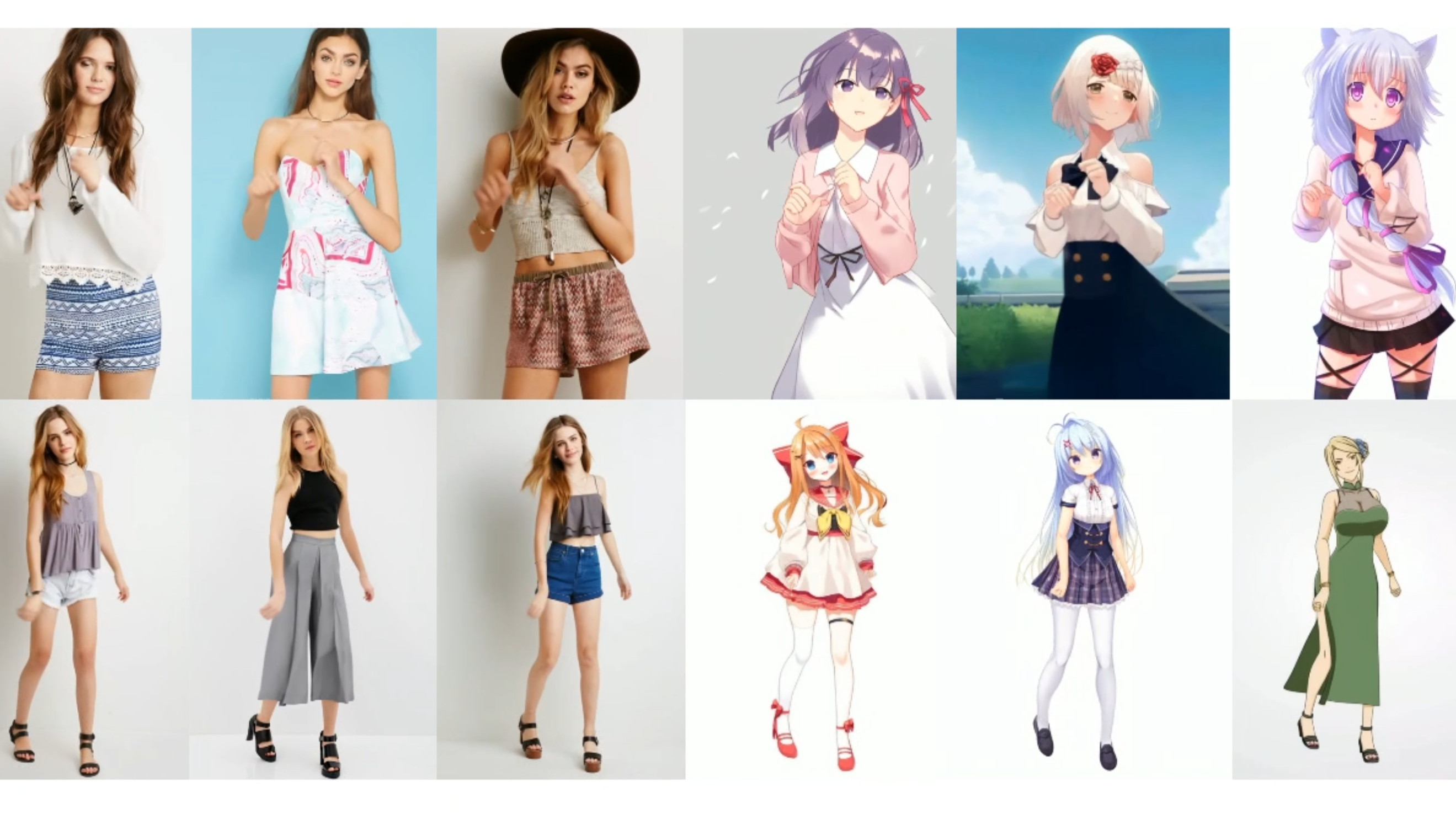

Beide Unternehmen setzen auf leicht unterschiedliche Architekturen, nutzen aber im Kern Diffusionsmodelle, die Bilder an ein Modell anpassen, das die Posen etwa einer Tanzsequenz über einen bestimmten Zeitraum vorgibt. MagicAnimate von Bytedance und dem Show Labder National University of Singapore sowie Animate Anyone von Alibaba und dem Institute for Intelligent Computing generieren dann aus einem Referenzbild und einer Tanzsequenz kurze Videoclips von tanzenden Menschen oder Zeichentrickfiguren.

Durch den Einsatz von Methoden wie ControlNet und anderen Methoden zur Sicherstellung der zeitlichen Stabilität erreichen die Videos eine wesentlich höhere Konsistenz als andere Text-zu-Video- oder Bild-zu-Video-Modelle und übertreffen die aktuellen Bestwerte des TikTok-Benchmarks um fast 40 Prozent.

Beide Methoden benötigen nur ein Bild und eine Bewegungssequenz, um Videos zu erzeugen - das kann eine reale Person, die Mona Lisa oder ein KI-generiertes Bild sein. Bytedance MagicAnimate kann sogar mehrere Personen gleichzeitig animieren.

Video: ByteDance

Mehr Möglichkeiten für TikTok - und KI-Influencer

Mit diesen Methoden könnten KI-Influencer, die heute vor allem in Form von statischen Bildern und KI-generierten Texten existieren, bald auch aktuelle TikTok-Trends aufgreifen oder andere Bewegtbilder erstellen. Bytedance könnte die Modelle in Zukunft auch direkt auf TikTok für die eigenen Kunden anbieten.

Der Code für MagicAnimate ist auf der Projektseiten auf Github verfügbar. Für MagicAnimate gibt es auch eine Demo. Der Code für Animate Anyone soll ebenfalls bald auf Github verfügbar sein - das Team will noch einige Verbesserungen vor der Veröffentlichugn vornehmen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.