Google-Chef Pichai glaubt weiter an LLM-Skalierung und sieht "großen Spielraum"

Mit Gemini bietet Google als erstes Unternehmen ein leistungsfähigeres LLM als OpenAIs GPT-4, wenn man den gängigen Benchmarks Glauben schenken darf.

Dass Gemini in der Ultra-Version GPT-4 in 30 von 32 Benchmarks übertrifft, ist aber nicht die große Neuigkeit an Googles LLM-Veröffentlichung. Die große Neuigkeit ist, dass Gemini GPT-4 nur knapp schlägt.

Selbst die kompaktere Gemini-Pro-Variante ist nur auf Augenhöhe mit OpenAIs ein Jahr altem GPT-3.5-Modell. Das wirft die Frage auf: Hat Google es nicht besser hinbekommen - oder geht es nicht viel besser?

Sind Gemini und GPT-4 bereits die Spitze der LLM-Fähigkeiten?

Im Gespräch mit MIT nimmt Pichai dazu Stellung: "Die Gesetze der Skalierung werden weiter greifen", sagt Pichai.

Konkret geht Pichai davon aus, dass KI-Modelle mit zunehmender Größe und Komplexität noch leistungsfähiger und effizienter werden. Google sehe noch "viel Spielraum" bei der Skalierung von Sprachmodellen.

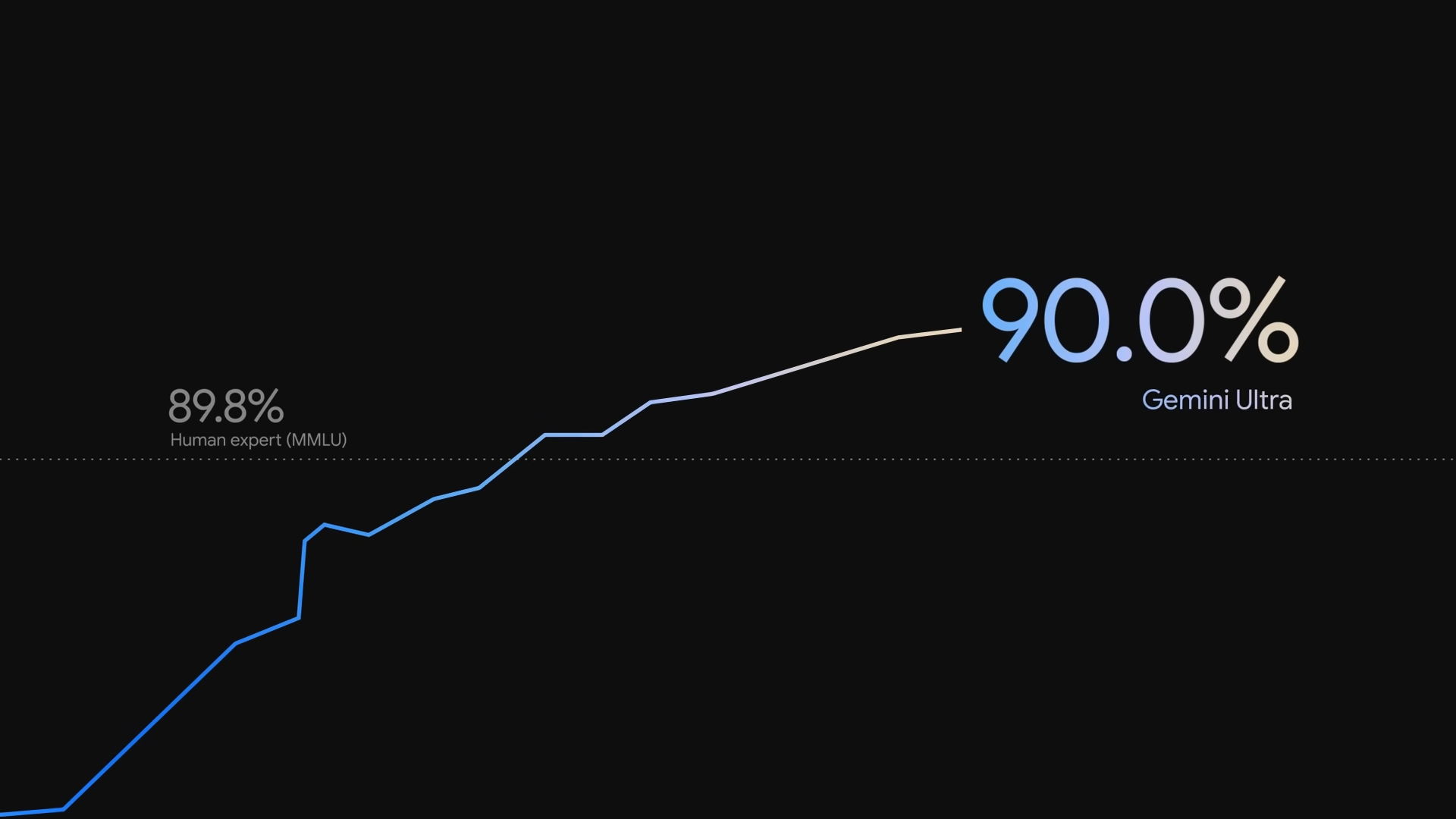

Zudem brauche es neue Benchmarks, die diesen Fortschritt messbar machen. Pichai verweist auf den häufig gemessenen Sprachverständnis-Benchmark MMLU (massive multi-task language understanding), bei dem Gemini erstmals die 90-Prozent-Marke knackt und damit Menschen übertrifft (89,8 %). Noch vor zwei Jahren habe der Standard im MMLU bei 30 bis 40 Prozent gelegen, so Pichai.

Betrachtet man jedoch im technischen Bericht zu Gemini die MMLU-Zahlen, die Google nicht ins Schaufenster stellt, so zeigt sich, dass Google nur bei einer von zwei Prompting-Methoden GPT-4 übertrifft, nämlich der aufwendigeren (CoT@32). Bei der von OpenAI berichteten Prompting-Methode (5-Shot, fünf Beispiele) schneidet Gemini Ultra schlechter als GPT-4 ab.

Das zeigt, wie nah GPT-4 und Gemini in vielen Bereichen tatsächlich beieinander liegen. Auch ältere Sprachmodelle wie PaLM 2 sind im MMLU-Benchmark nicht völlig abgehängt.

Bei vielen aktuellen Benchmarks sei man bereits am Limit, so Pichai. Das wirke sich auch auf die Wahrnehmung des Fortschritts aus. "Es mag nicht nach viel klingen, aber es sind Fortschritte", sagte Pichai.

In anderen Bereichen ist noch deutlich mehr Luft nach oben, etwa bei der multimodalen Verarbeitung und Bearbeitung von Aufgaben. Damit ist unter anderem die Fähigkeit gemeint, auf ein Bild passend mit Text zu antworten. Hier macht Gemini in den Benchmarks zum Teil große Sprünge von mehr als fünf Prozentpunkten (MMMU).

"Je größer wir die Modelle machen, desto mehr Fortschritte werden wir machen. Wenn ich es in seiner Gesamtheit betrachte, habe ich wirklich das Gefühl, dass wir noch ganz am Anfang stehen", sagt Pichai.

Warten auf GPT-5

Wenn Pichais Prognose zutrifft, bedeutet dies auch, dass Google trotz jahrelanger Investitionen in KI-Forschung und -Entwicklung und trotz gigantischer Forschungs- und Rechenkapazitäten einige Monate gebraucht hat, um seine internen Prozesse und Strukturen so auf die LLM-Skalierung umzustellen, dass es GPT-4 zumindest knapp schlagen konnte. Seit der Veröffentlichung von GPT-4 ist gut ein dreiviertel Jahr vergangen. Die Fusion von Googles KI-Abteilung mit Deepmind dürfte zusätzliche Zeit in Anspruch genommen haben.

OpenAI hatte mit GPT-3 bereits 2020 ein großes einsatzfähiges Sprachmodell auf den Markt gebracht und in den Jahren zuvor entsprechende Strukturen aufgebaut.

Andererseits: Auch Google hatte beispielsweise mit PaLM und Vorgängerprojekten bereits große LLMs vorgestellt. Die Skalierung von Sprachmodellen war für den Konzern also keineswegs neu.

Größere Sprünge erfordern möglicherweise zunächst Fortschritte bei der grundlegenden LLM-Architektur, was mehr Forschungszeit in Anspruch nimmt. Der letzte große Sprung, die Transformer-Architektur, die die Skalierungsprinzipien ermöglichte, die später von OpenAI genutzt wurden, kam von Google.

Das Rennen geht also weiter und die spannende Frage ist nun: Wie schnell und wie stark kann OpenAI mit GPT-5 kontern?

Bisher hieß es von OpenAI offiziell, das nächste große Sprachmodell sei noch weit von der Marktreife entfernt. Zuletzt war durchgesickert, dass GPT-5 bereits Anfang 2024 soweit sein könnte.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.