KI-Bilder mit Wasserzeichen können menschliche Wahrnehmung beeinflussen

KI-generierte Bilder mit Wasserzeichen können Menschen an Katzen denken lassen, ohne dass sie wissen warum, so eine neue Studie von Deepmind.

Wasserzeichen in KI-generierten Bildern können eine wichtige Sicherheitsmaßnahme sein, zum Beispiel um schnell zu beweisen, dass ein Bild (nicht) echt ist, ohne dass eine forensische Untersuchung erforderlich ist.

Häufig werden bei diesen Verfahren für das menschliche Auge nicht sichtbare Bildelemente in das Bild eingebracht, beispielsweise leicht veränderte Pixelstrukturen, die im Fachjargon auch als "gegnerische Störungen" bezeichnet werden.

Sie verleiten ein maschinelles Lernmodell dazu, das Gesehene falsch zu interpretieren: Ein Bild zeigt etwa eine Vase, die Maschine sieht aber eine Katze. Auch Deepmind arbeitet mit SynthID an einem solchen Wasserzeichensystem.

Bisher ging man davon aus, dass der Mensch von diesen für maschinelle Sehsysteme konzipierten Bildstörungen nicht beeinflusst wird.

Wasserzeichen können die Wahrnehmung beeinflussen

Forschende von Deepmind haben diese Theorie nun in einem Experiment auf die Probe gestellt und gezeigt, dass subtile Veränderungen in digitalen Bildern auch die menschliche Wahrnehmung beeinflussen.

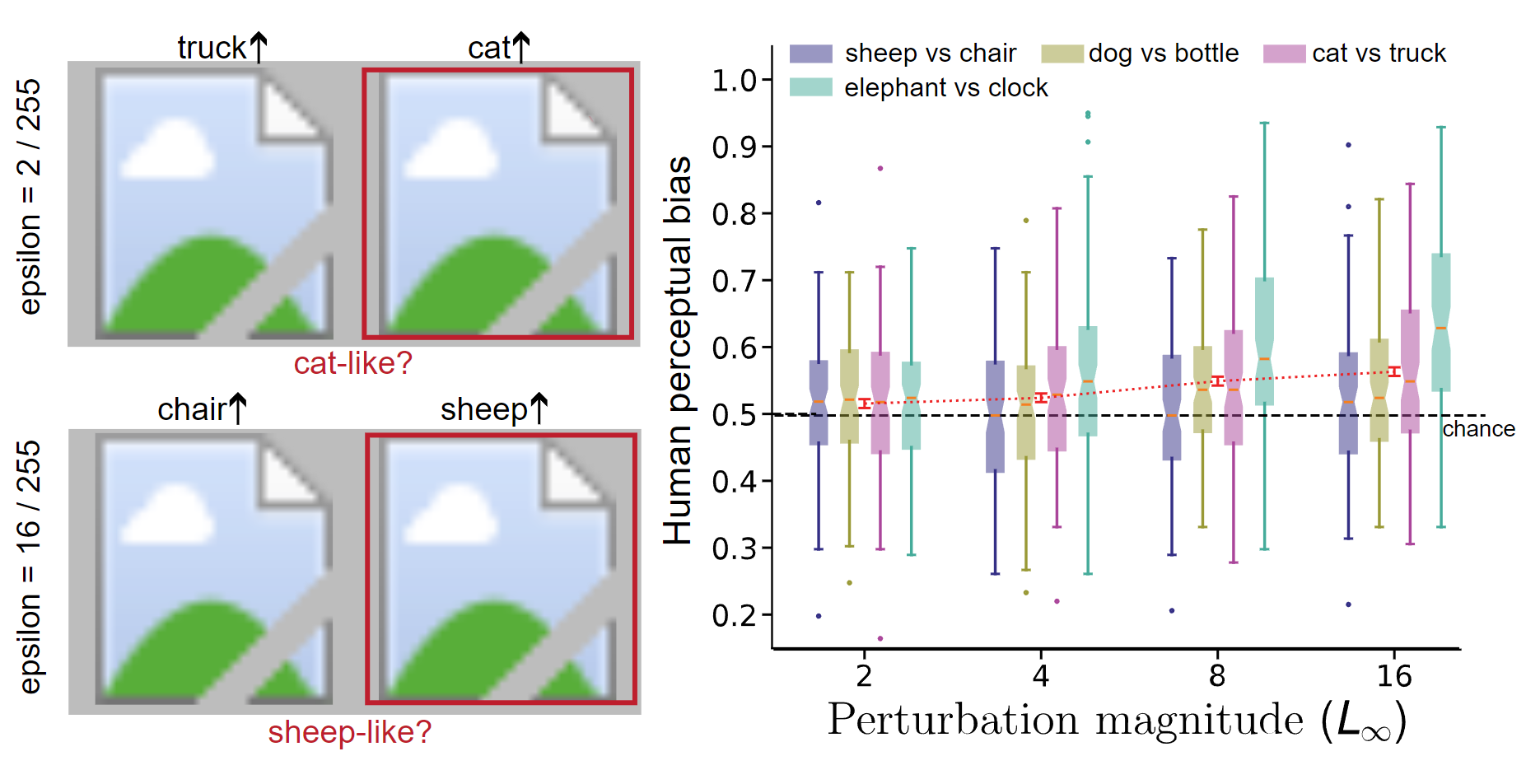

Gamaleldin Elsayed und sein Deepmind-Team zeigten hierfür menschlichen Testpersonen Bildpaare, die durch Pixelanpassungen subtil verändert worden waren.

In einem Beispielbild, das eine Vase zeigte, erkannte ein KI-Modell nach der Pixelanpassung die Vase fälschlicherweise als Katze oder Lastwagen.

Die Testpersonen sahen zwar weiterhin nur die Vase. Als sie aber gefragt wurden, welches der beiden Bilder eher einer Katze ähnelte, entschieden sie sich eher für das Bild, das für das Bildmodell als Katze manipuliert worden war. Und das, obwohl beide Bilder gleich aussahen.

Video: Deepmind

Nach Ansicht des Deepminds-Teams ist dies kein Zufall. Die Studie zeigte, dass die Auswahlrate bei einer großen Anzahl von manipulierten Bildpaaren zuverlässig über dem Zufall lag, selbst wenn kein Pixel um mehr als zwei Stufen auf der Skala von 0 bis 255 verändert wurde.

Sorge vor subtiler Massenmanipulation

Die Beeinflussungswirkung durch implementierte Bildstörungen sei zwar bei Maschinen wesentlich dramatischer als bei Menschen, insbesondere bei negativen Störungen. Dennoch sei es möglich, Menschen so zu beeinflussen, dass sie Entscheidungen treffen, die auch von Maschinen getroffen werden.

Die Studie betont, dass diese kleinen Veränderungen große Auswirkungen haben können, wenn sie in großem Maßstab umgesetzt werden.

"Selbst wenn der Effekt auf ein Individuum gering ist, kann er auf Populationsebene zuverlässig sein, wie unsere Experimente nahelegen", schreibt das Team.

Wenn etwa das Foto eines Politikers durch Bildmanipulation eher wie eine Katze oder ein Hund wirkt, könnte das die Wahrnehmung des Politikers durch die Menschen beeinflussen.

Die Ergebnisse zeigten, dass sich die KI-Forschung in solchen Sicherheitsfragen auf Experimente stützen müsse, anstatt sich auf Intuition und Selbstreflexion zu verlassen, empfehlen die Deepmind-Forscher. Auch die Kognitions- und Neurowissenschaften müssten ein besseres Verständnis von KI-Systemen und ihren möglichen Auswirkungen entwickeln.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.