Meta will KI-Bilder und -Content besser identifizieren und kenntlich machen

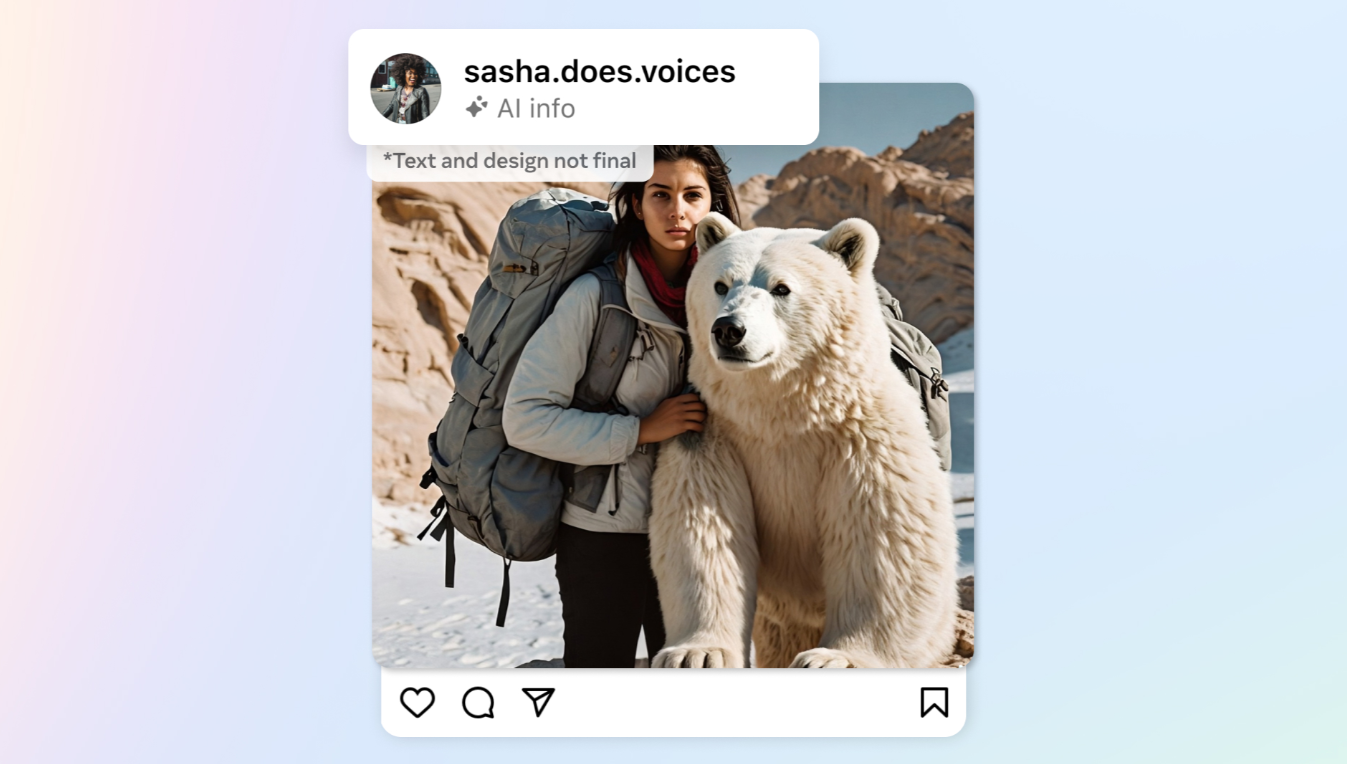

Meta arbeitet an der Implementierung von "Imagined with AI"-Kennzeichnungen auf KI-generierten Bildern, die auf Facebook, Instagram und Threads veröffentlicht werden.

Damit will das Unternehmen die Transparenz von KI-generierten Inhalten, einschließlich Video und Audio, durch sichtbare Kennzeichnungen, unsichtbare Wasserzeichen und in die Bilddateien eingebettete Metadaten erhöhen.

Konkret arbeitet Meta mit Industriepartnern wie Google, OpenAI, Microsoft, Adobe, Midjourney und Shutterstock zusammen, um gemeinsame Standards für die Kennzeichnung von KI-generierten Inhalten etwa durch IPTC-Metadaten zu entwickeln und identifizierbar zu machen.

Fotorealistische Bilder, die mit der eigenen Meta AI-Funktion erstellt wurden, erhalten ebenfalls die sichtbare Kennzeichnung "Imagined with AI" und ein unsichtbares Wasserzeichen sowie entsprechende Metadaten.

In den "kommenden Monaten" wird Meta damit beginnen, Tagging in allen Sprachen durchzuführen, die von den einzelnen Anwendungen unterstützt werden.

Das sei zwar der derzeit beste technisch machbare Ansatz, aber es sei nicht möglich, alle KI-generierten Inhalte zu identifizieren, und Menschen könnten unsichtbare Markierungen entfernen.

Das Unternehmen entwickelt daher fortschrittlichere Klassifikatoren für die automatische Erkennung von KI-generierten Inhalten und erforscht beispielsweise die Wasserzeichentechnologie Stable Signature, bei der Wasserzeichen direkt in den Bilderzeugungsprozess integriert werden, sodass sie laut Meta nur schwer zu deaktivieren sind.

Bis die Erkennungstechnologie für Video und Audio standardisiert und ausgereift ist, sind auch die Nutzer gefragt: Meta will ein Offenlegungs- und Kennzeichnungs-Tool anbieten, mit dem Nutzer organische Inhalte mit fotorealistischem Video oder realistisch klingendem Audio, die digital erstellt oder verändert wurden, kennzeichnen müssen. Andernfalls droht Meta mit Sanktionen. Bild-, Video- oder Audioinhalte, die "ein besonders hohes Risiko darstellen", sollen gegebenenfalls auffälliger gekennzeichnet werden.

Meta testet LLMs fürs Community-Management

Meta testet zudem große Sprachmodelle, um die Durchsetzung seiner Community-Standards zu unterstützen und Inhalte zu identifizieren, die gegen seine Richtlinien verstoßen. Erste Tests deuten laut Meta darauf hin, dass LLMs eine bessere Leistung erbringen können als bestehende maschinelle Lernmodelle.

Das Unternehmen verwendet LLMs auch, um Inhalte aus der Warteschlange für die Prüfung zu entfernen, wenn es sehr sicher ist, dass der Inhalt nicht gegen die Richtlinien verstößt. Auf diese Weise sollen sich die Prüfer auf Inhalte konzentrieren können, die mit größerer Wahrscheinlichkeit gegen die Richtlinien verstoßen.

OpenAI testet ebenfalls, inwieweit Sprachmodelle das Community-Management teilweise automatisieren können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.