DeepMinds Prompt-Technik "Self-Discover" soll LLMs zum selbständigen Denken anregen

Logisches Denken stellt große Sprachmodelle vor Probleme. Spezielle Prompting-Techniken sollen Abhilfe schaffen. DeepMind hat einen Werkzeugkasten zusammengestellt, aus dem ein LLM automatisch das passende Denkwerkzeug auswählt.

Logische Schlussfolgerungen sind trotz aller Fortschritte noch immer die größte Herausforderung großer Sprachmodelle. Zur Lösung dieses Problems haben Wissenschaftler:innen von Google DeepMind und der University of Southern California nun einen neuen Ansatz namens "Self-Discover" vorgestellt. Damit sollen Sprachmodelle selbstständig logische Strukturen zur Lösung komplexer Probleme entdecken.

Auswählen, anpassen, implementieren

Das Framework gibt dem Sprachmodell Prompting-Bausteine wie "Schritt-für-Schritt", "kritisch hinterfragen" oder "in Teilprobleme zerlegen" vor.

Anhand von Aufgabenbeispielen ohne Lösungen wählt das Modell dann selbstständig Bausteine aus, passt sie an die konkrete Aufgabe an und setzt sie schließlich zu einem ausführbaren Lösungsplan zusammen.

In der zweiten Phase kann das Modell die Aufgabe lösen, indem es einfach dem Plan folgt, den es selbst entwickelt hat.

Nach Ansicht der Forschenden ahmt dieser Ansatz den menschlichen Problemlösungsprozess nach. Er verspricht bessere Ergebnisse und sei zudem sehr recheneffizient, da die Lösungsstrategie nur einmal auf der Metaebene entwickelt werden muss.

Eine mögliche Anwendung von Self-Discover ist die Lösung einer komplexen mathematischen Gleichung. Anstatt die Gleichung direkt zu lösen, könnte Self-Discover zunächst eine logische Struktur erstellen, die aus mehreren Schritten besteht, wie die Vereinfachung der Gleichung, die Isolierung von Variablen und schließlich die Lösung der Gleichung. Das LLM folgt dann dieser Struktur, um die Aufgabe Schritt für Schritt zu lösen.

Deutliche Verbesserungen gegenüber Chain of Thought

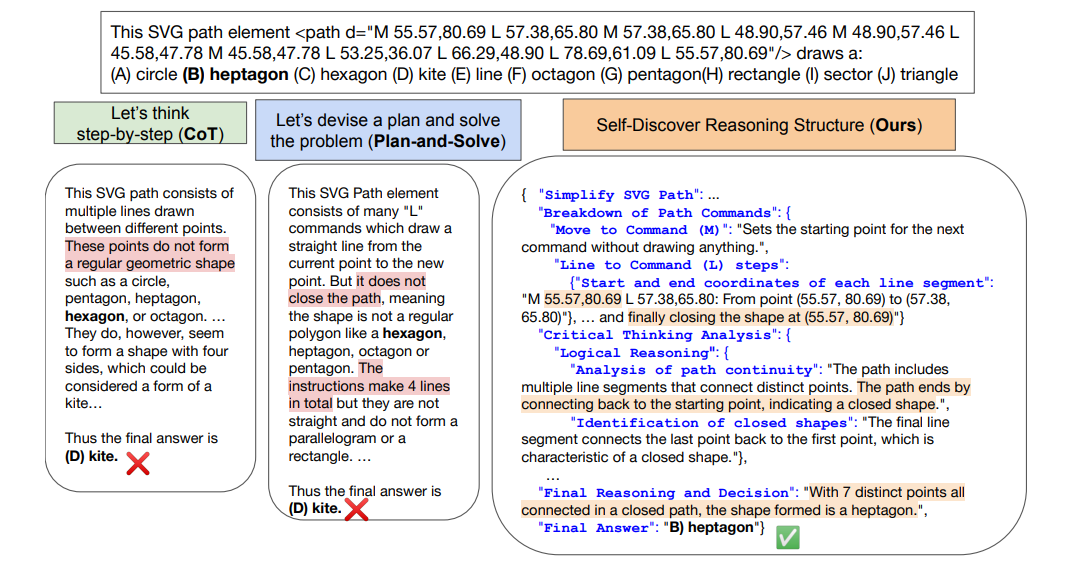

Ein Beispiel der Wissenschaftler:innen vergleicht Self-Discover mit Chain of Thought (CoT) und Plan-and-Solve, wobei das Sprachmodell aus dem SVG-Pfad einer Vektordatei die korrekte geometrische Form ableiten soll.

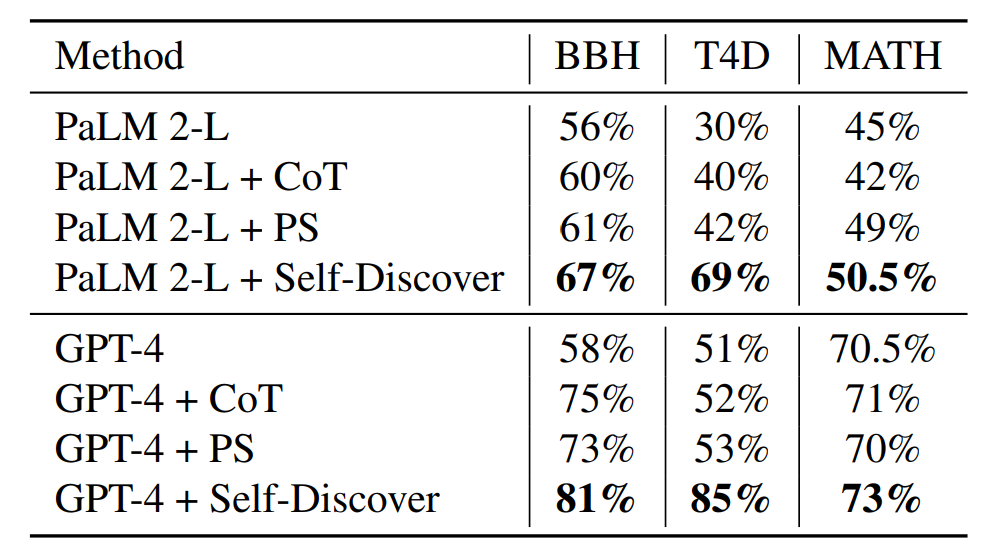

Die Forschenden testeten Self-Discover mit OpenAIs GPT-4 Turbo, GPT-3.5 Turbo, Metas LLaMa-2-70B und Googles PaLM 2. In 21 von 25 Aufgaben übertraf Self-Discover das bewährte CoT-Verfahren, das zudem mehr Rechenleistung benötige, um bis zu 42 Prozent. Self-Discover benötigte nur drei zusätzliche Inferenzschritte auf Aufgabenebene.

In drei weiteren Benchmarks zum logischen Denken (BigBench-Hard, Thinking for Doing, Math) konnte das Framework die LLM-Leistung unabhängig vom Sprachmodell zum Teil deutlich verbessern. In allen Tests übertraf Self-Discover die häufig verwendeten Chain-of-Thought- (CoT) und Plan-and-Solve-Prompts (PS). Das zeige, dass das Self-Discover-Prinzip universell einsetzbar ist.

Self-Discover soll inferenzintensive Methoden wie CoT-Self-Consistency oder Majority Voting um mehr als 20 Prozent übertreffen, bei einem 10- bis 40-fach geringeren Rechenaufwand.

Auch OpenAI hat kürzlich mit dem Meta-Prompting Framework eine mögliche Lösung für eine bessere logische Performance großer Sprachmodelle vorgestellt. Ähnlich wie Self-Discover zerlegt das Framework komplexe Aufgaben eines Sprachmodells in kleinere, handhabbare Teile, die dann von spezifischen "Experten"-Instanzen desselben Sprachmodells bearbeitet werden. Durch das Hin- und Herschalten zwischen einer Vielzahl an Experten steigen hier jedoch die Rechenkosten im Vergleich zu herkömmlichen Prompts an.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.