Neues Tool von Microsoft kann KI-Prompts um bis zu 80 Prozent komprimieren

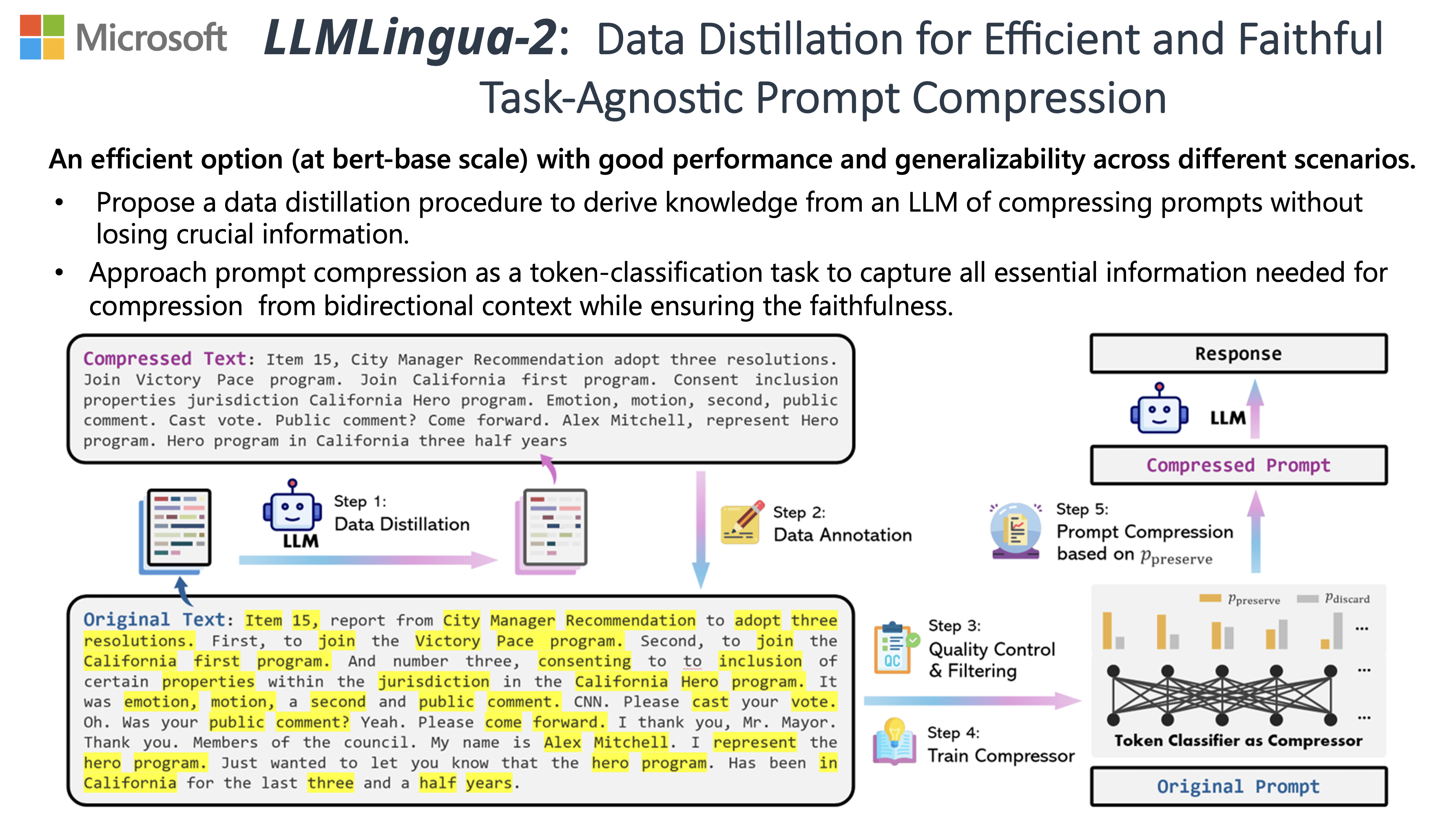

Microsoft Research hat mit LLMLingua-2 ein Modell zur aufgabenagnostischen Kompression von Prompts veröffentlicht. Es ermöglicht eine Verkürzung auf bis zu 20 Prozent der ursprünglichen Länge und senkt damit Kosten und Latenz.

LLMLingua-2 komprimiert lange Prompts auf intelligente Weise, indem unnötige Wörter oder Token entfernt werden, während die wesentlichen Informationen erhalten bleiben.

Dadurch können Prompts auf bis zu 20 Prozent ihrer ursprünglichen Länge reduziert werden, was wiederum zu geringeren Kosten und Latenzzeiten führt. "Natürliche Sprache ist redundant, der Umfang der Informationen variiert", schreibt das Forschungsteam.

Laut Microsoft Research ist LLMLingua 2 um den Faktor 3 bis 6 schneller als die Vorgängerversion LLMLingua und ähnliche Verfahren. LLMLingua 2 wurde mit Beispielen aus der MeetingBank trainiert, die Transkripte von Meetings und deren Zusammenfassungen enthält.

Weniger Text, gleiche Aussagekraft

Zur Kompression wird der Originaltext in das trainierte Modell eingegeben. Das Modell bewertet jedes Wort und vergibt Punkte für Beibehaltung oder Entfernung, wobei der umgebende Kontext berücksichtigt wird. Die Wörter mit den höchsten Beibehaltungswerten werden dann ausgewählt, um den verkürzten Prompt zu erstellen.

Das Team von Microsoft Research hat LLMLingua-2 auf verschiedenen Datensätzen evaluiert, darunter MeetingBank, LongBench, ZeroScrolls, GSM8K und BBH. Trotz seiner geringen Größe zeigte das Modell signifikante Leistungsverbesserungen gegenüber starken Baselines und demonstrierte eine robuste Generalisierungsfähigkeit über verschiedene LLMs hinweg.

System Prompt:

You are an excellent linguist and very good at compressing passages into short expressions by removing unimportant words, while retaining as much information as possible.

User Prompt:

Compress the given text to short expressions, and such that you (GPT-4) can reconstruct it as close as possible to the original. Unlike the usual text compression, I need you to comply with the 5 conditions below:

1. You can ONLY remove unimportant words.

2. Do not reorder the original words.

3. Do not change the original words.

4. Do not use abbreviations or emojis.

5. Do not add new words or symbols.

Compress the origin aggressively by removing words only. Compress the origin as short as you can, while retaining as much information as possible. If you understand, please compress the following text: {text to compress}

The compressed text is: [...]

Microsofts Kompressions-Prompt für GPT-4

Bei einer Vielzahl von Sprachaufgaben wie Frage-Antwort, Zusammenfassung und logischem Schlussfolgern übertraf es durchweg etablierte Benchmarks wie das ursprüngliche LLMLingua und Selective-Context-Strategien. Bemerkenswert ist, dass die gleiche Kompression sowohl für verschiedene LLMs (von GPT-3.5 bis Mistral-7B) als auch für verschiedene Sprachen (von Englisch bis Chinesisch) effektiv funktionierte.

LLMLingua-2 kann mit nur zwei Zeilen Code implementiert werden. Das Modell wurde auch in die weitverbreiteten RAG-Frameworks LangChain und LlamaIndex integriert.

Microsoft stellt eine Demo, praktische Anwendungsbeispiele und ein Skript zur Verfügung, das die Vorteile und Kosteneinsparungen der Prompt-Kompression veranschaulicht. Das Unternehmen sieht darin einen vielversprechenden Ansatz, um mit komprimierten Prompts eine bessere Generalisierbarkeit und Effizienz zu erreichen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.