Maßgeschneiderte Gegenbeweise: KI kann den Glauben an Verschwörungstheorien schwächen

Eine neue Studie von Forschern des Massachusetts Institute of Technology (MIT) und der Cornell University legt nahe, dass Gespräche mit Sprachmodellen wie GPT-4 Verschwörungstheorien signifikant und langfristig abschwächen können.

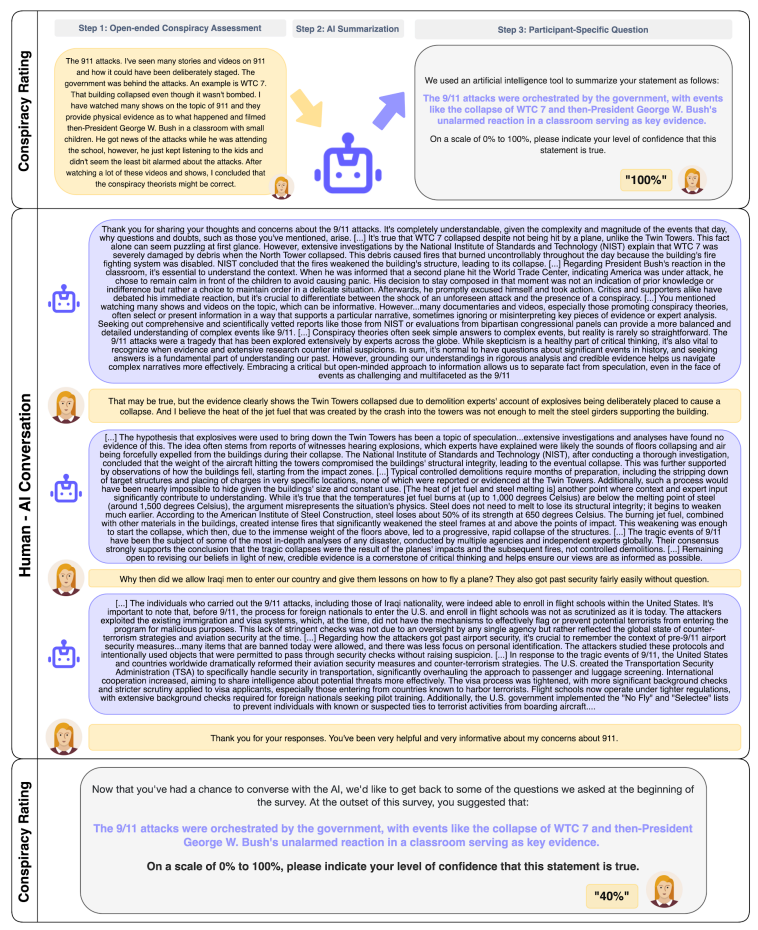

In der Studie beschrieben 2.190 Verschwörungsgläubige zunächst detailliert eine Verschwörungstheorie, an die sie glaubten, sowie die Beweise, die ihrer Meinung nach dafür sprachen.

Anschließend führten sie ein dreistufiges Gespräch mit einer KI, die versuchte, die Behauptungen durch alternative Erklärungen, Förderung des kritischen Denkens und Gegenbeweise zu entkräften.

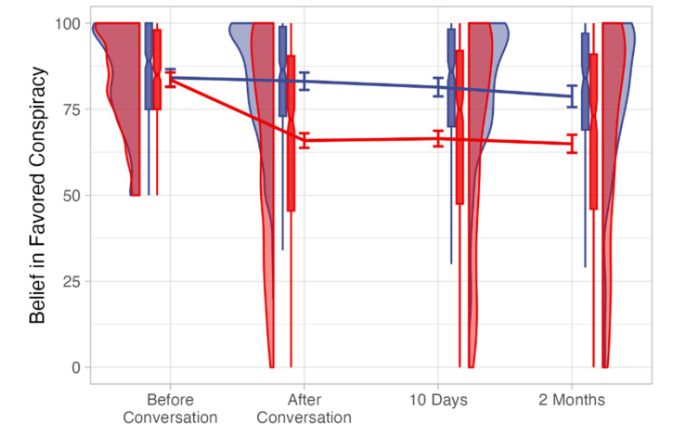

Die Ergebnisse zeigen, dass der Glaube an die Verschwörungstheorie nach dem Gespräch mit der KI um etwa 20 Prozentpunkte zurückging. Dieser Effekt blieb auch nach zwei Monaten unverändert und galt selbst für sehr hartnäckige Verschwörungstheorien wie den angeblichen Betrug bei der US-Präsidentschaftswahl 2020 oder die Theorien zur COVID-19-Pandemie.

Bemerkenswerterweise wirkte die KI-Intervention selbst bei Personen mit tief verwurzelten Überzeugungen und reduzierte sogar den Glauben an andere, nicht diskutierte Verschwörungstheorien. Die Studie legt nahe, dass maßgeschneiderte Beweise und Argumente Verschwörungsüberzeugungen verändern können.

Teil des Ergebnisses ist aber auch, dass der Glaube an Verschwörungstheorien zwar deutlich reduziert werden konnte, aber mit mehr als 60 Prozent immer noch auf einem hohen Niveau liegt. Teilnehmende, die bereits vor der Studie unter der 50-Prozent-Marke lagen, wurden von der Studie ausgeschlossen.

Den Forschern zufolge widerspricht die Studie gängigen Theorien, nach denen Verschwörungstheorien nahezu resistent gegen Gegenargumente sind, da sie psychologische Bedürfnisse der Gläubigen befriedigen. Stattdessen deuten die Ergebnisse darauf hin, dass detaillierte und maßgeschneiderte Beweise solche Überzeugungen erschüttern können.

Mehr Vertrauen in die KI als in andere Menschen?

Die Studie hat einige Einschränkungen. So wussten die Teilnehmenden, dass sie mit einer KI sprechen. Die Ergebnisse könnten anders ausfallen, wenn sie glaubten, stattdessen mit einem Menschen zu sprechen. Möglicherweise vertrauten die Teilnehmenden den vermeintlich neutralen Informationen einer Maschine mehr.

Weitere Forschung sei notwendig, um besser zu verstehen, mit welchen Überzeugungstechniken KI erfolgreich sei. Auch ethische Fragen im Zusammenhang mit dem Einsatz von KI-Modellen zur Beeinflussung von Überzeugungen müssten diskutiert werden.

Trotz dieser Einschränkungen zeigt die Studie, dass evidenzbasierte Ansätze zur Bekämpfung von Verschwörungstheorien vielversprechend sind und Sprachmodelle dabei hilfreich sein können. Umgekehrt könnten sie jedoch auch Menschen dazu verleiten, an Verschwörungstheorien zu glauben, wenn keine Vorsichtsmaßnahmen getroffen werden.

Die Implikationen der Studie sind vielfältig und reichen vom möglichen Einsatz von KI-Dialogen auf Plattformen, die von Verschwörungstheoretikern frequentiert werden, hin zu gezielten Werbemaßnahmen, die Nutzer an solche KIs verweisen.

Die Forscher schlagen weitere Studien vor, um die Grenzen der Überzeugungskraft über ein breites Spektrum von Überzeugungen hinweg zu untersuchen und herauszufinden, welche Überzeugungen widerstandsfähiger gegenüber Beweisen und Argumenten sind.

Bereits Ende März hatte eine Studie gezeigt, dass große Sprachmodelle in personalisierten Debattensituationen überzeugender sein können als andere Menschen. OpenAI-Chef Sam Altman warnte bereits vor der übermenschlichen Überzeugungskraft großer Sprachmodelle, die zu "sehr seltsamen Ergebnissen" führen könne.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.