Stanford-Studie: KI-Firmen legen Fortschritte bei Transparenz hin, aber Luft nach oben bleibt

Eine Studie der Stanford University zeigt, dass KI-Entwickler in den letzten sechs Monaten deutlich mehr Informationen über ihre Modelle preisgegeben haben. Dennoch gibt es noch viel Raum für Verbesserungen.

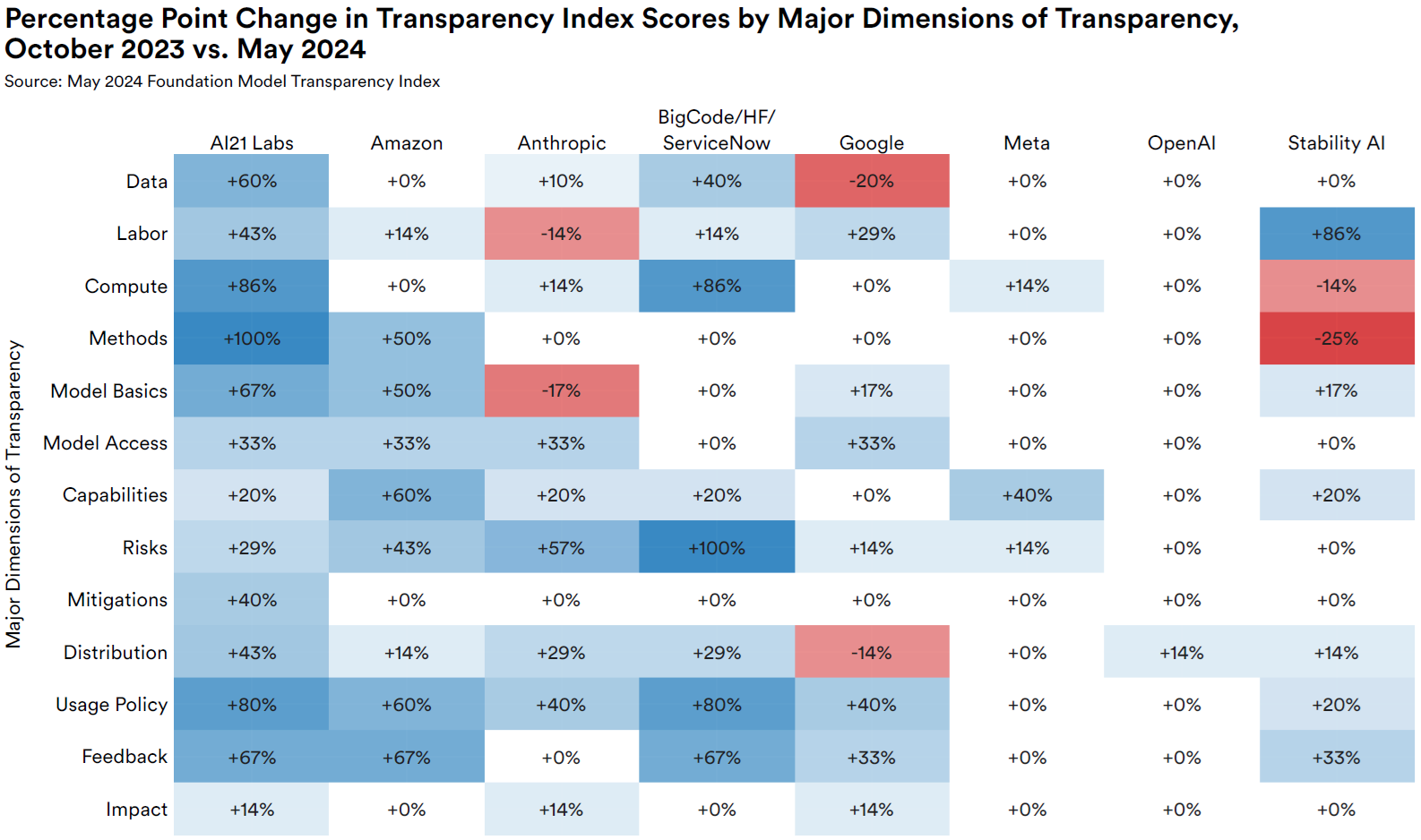

Laut einer aktuellen Studie der Stanford University sind KI-Firmen in den letzten sechs Monate transparenter geworden, wenn es um Informationen zu ihren großen Sprachmodellen geht. Der sogenannte "Foundation Model Transparency Index" (FMTI) bewertet Unternehmen anhand von 100 Transparenzindikatoren zu Themen wie Daten, Rechenleistung, Fähigkeiten und Risiken der Modelle.

Im Oktober 2023 erreichten die bewerteten Unternehmen im Durchschnitt nur 37 von 100 möglichen Punkten. Die jetzt veröffentlichte Folgestudie vom Mai 2024 zeigt nun einen Anstieg auf durchschnittlich 58 Punkte.

Im Vergleich zum Oktober 2023 haben sich jedoch alle acht bewerteten Unternehmen in beiden Studien verbessert. Einige haben sich drastisch verbessert, wie AI21 Labs von 25 auf 75 Punkte. Andere, wie OpenAI, verbesserten sich nur leicht von 48 auf 49 Punkte. Insgesamt eine Verbesserung, aber von echter Transparenz noch weit entfernt.

Für die aktuelle Studie haben 14 Entwickler, darunter acht aus der vorherigen Studie wie OpenAI und Anthropic und sechs neue wie IBM, Transparenzberichte eingereicht. Im Durchschnitt machten sie Angaben zu 16 zusätzlichen Indikatoren, die zuvor nicht öffentlich zugänglich waren.

Am transparentesten sind die Entwickler in Bezug auf die Fähigkeiten ihrer Modelle und die Dokumentation für nachgelagerte Anwendungen. Sehr intransparent bleiben dagegen bei besonders sensiblen Themen wie Trainingsdaten, Zuverlässigkeit der Modelle und deren Auswirkungen.

Bei 96 der 100 Indikatoren erreichte mindestens ein Unternehmen einen Punkt, bei 89 Indikatoren sogar mehrere. Würden sich alle an den transparentesten Unternehmen der jeweiligen Kategorie orientieren, wären große Fortschritte möglich, so die Forscher.

Allerdings zeigt die Studie auch systemische Intransparenz in einigen Bereichen, in denen fast alle Entwickler Informationen zurückhalten, zum Beispiel zum Copyright-Status der Trainingsdaten und zum Einsatz der Modelle in verschiedenen Ländern und Branchen.

Eine detaillierte Auswertung der einzelnen bewerteten Modelle ist hier auf einer interaktiven Webseite zugänglich.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.