Google räumt Mängel und Fehler in KI-generierten Suchergebnissen ein

Laut Google sind minderwertige KI-generierte Antworten die Ausnahme, zudem seien Fakes im Umlauf. In einigen Bereichen wie Nachrichten und Gesundheit schränkt Google die KI-Antworten ein.

In der vergangenen Woche tauchten im Netz zahlreiche Beschreibungen fehlerhafter KI-Antworten in der neuen Google-Suche auf. Einige "AI Overviews" enthielten Fehler in einem medizinischen Kontext.

In einem Blogeintrag erklärt Google nun, dass es sich bei einem Großteil der geteilten Screenshots um Fälschungen handelt. Nutzer sollten im Zweifelsfall selbst recherchieren, um die Echtheit zu überprüfen. AI Overviews seien in etwa so akkurat wie die lange bekannten "Feature Snippets", kleine Textauszüge aus Webseiten, die direkt in der Suche angezeigt werden.

Allerdings räumte Google ein, dass tatsächlich einige seltsame, ungenaue oder wenig hilfreiche KI-Übersichten angezeigt wurden. Dies geschah vorwiegend bei Suchanfragen, die Nutzer normalerweise nicht stellen, behauptet Google.

AI Overviews funktionieren laut Google grundsätzlich anders als Chatbots. Sie generieren ihre Ausgaben nicht nur auf Basis von Trainingsdaten, sondern sind in die Kernsysteme zur Bewertung von Webinhalten integriert. Ziel sei es, relevante und qualitativ hochwertige Ergebnisse aus dem Suchindex zu identifizieren.

Deshalb enthalten die KI-Übersichten auch Links zu den Quellen. Genauigkeit habe oberste Priorität, betont Google. Die KI-Übersichten sollen nur Informationen anzeigen, die durch die besten Webergebnisse gestützt werden.

Nutzt Google die relevantesten Quellen für die KI-Generierung - oder die billigsten?

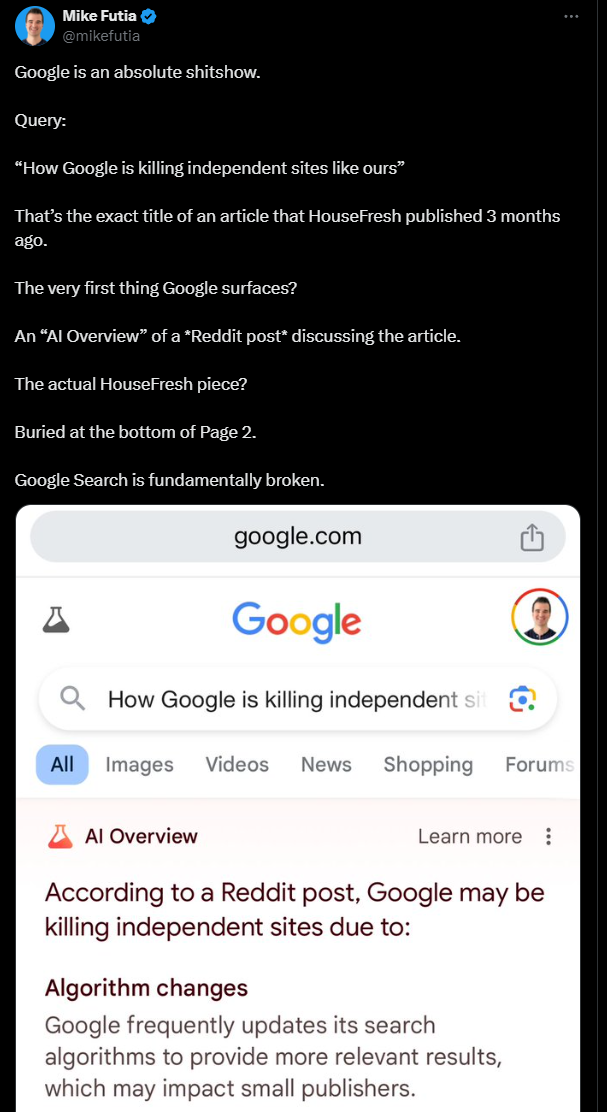

Soweit die Theorie von Google: In der Praxis gibt es in den sozialen Medien Hinweise darauf, dass gänzlich unbekannte Seiten oder Reddit als Vorlage für KI-Antworten dienen.

Ökonomisch würde das Sinn ergeben, denn würde Google KI-Antworten auf Basis hochwertiger lizenzierter Inhalte generieren, würde es sich rechtlich in noch fragwürdigere Gewässer begeben, als es ohnehin schon ist.

Google zahlte zudem dem Internetforum Reddit jährlich 60 Millionen US-Dollar für Zugang zu dessen Daten. Vor der weitläufigen Einführung von AI Overviews hatte Google Reddit monatelang systematisch mehr Traffic zukommen lassen, mit der Begründung, dass die Nutzerinnen und Nutzer die personalisierten Antworten auf Reddit schätzten.

Die Wahrheit ist aber auch: Die 60 Millionen US-Dollar für Reddit sind ein Bruchteil dessen, was Google etablierten Verlagen zahlen müsste, um direkte KI-Antworten auf Basis ihrer Inhalte zu generieren.

Zum Teil stehen auf Reddit wiedergegebene Publisher-Inhalte in den Suchergebnissen sogar vor der Originalquelle. Die Folge: Reddit wächst und wächst, Google bekommt seine Daten und KI-Antworten, kleine Publisher sterben aus.

KI-Wettbewerber OpenAI hat für seine wohl bald erscheinende Such-Alternative hunderte Millionen US-Dollar in die Inhalte ausgewählte Publisher investiert. Auch dieses Vorgehen ist problematisch, wirkt aber zumindest aufrichtiger als Googles Strategie.

Google räumt Fehler bei KI-Suche ein

Zurück zur Qualität der AI Overviews: Gelegentlich käme es zu Fehlinterpretationen von Suchanfragen oder sprachlichen Ungenauigkeiten, räumt Google ein.

Auch ein Mangel an qualitativ hochwertigen Informationen zu einem Thema könne die Qualität beeinträchtigen. Schwierigkeiten gebe es etwa bei der Interpretation unsinniger Suchanfragen und satirischer Inhalte.

Als Beispiel nennt das Unternehmen die Frage "Wie viele Steine soll ich essen?", die Googles KI mit "mindestens einen pro Tag" beantwortete.

Seriöse Web-Inhalte zu diesem Thema gebe es nicht, wohl aber einen satirischen Beitrag, der seinen Weg auf eine ansonsten thematisch passende Website fand, die in diesem Fall zitiert worden sei. Außerdem habe diese Suchanfrage bislang noch niemand gestellt. Google spricht hier von einer "Datenlücke".

In anderen Fällen enthielten KI-Übersichten sarkastische oder unseriöse Inhalte aus Diskussionsforen wie Reddit. Obwohl Foren oft authentische Erfahrungen vermitteln, können sie auch zu wenig hilfreichen Ratschlägen führen, so Google.

Google hat nach eigenen Angaben seine AI Overviews wie folgt angepasst:

- Erkennung unsinniger Anfragen, bei denen keine AI Overviews angezeigt werden sollen. Einschränkung von Satire und Humor.

- Einschränkung von nutzergenerierten Inhalten, die irreführende Ratschläge enthalten könnten.

- Zusätzliche Einschränkungen für Themen, bei denen sich KI-Überblicke als wenig hilfreich erwiesen haben.

- Verstärkte Schutzmaßnahmen bei sensiblen Themen wie Nachrichten und Gesundheit. Möglichst keine KI-Übersichten zu Nachrichten, wo Aktualität und Genauigkeit besonders wichtig sind.

KI-Übersichten, die gegen die Inhaltsrichtlinien verstoßen, werden entfernt. Solche Verstöße sind laut Google bisher bei weniger als einer von sieben Millionen Suchanfragen aufgetreten. Bei Milliarden von Suchanfragen täglich seien einzelne Fehler nicht zu vermeiden, so Google.

Natürlich kann sich Google bei jeder Kritik stets darauf zurückziehen, dass es sich nur um anekdotische Beobachtungen handelt, um wenige Ausnahmen bei Milliarden von Anfragen. Google-CEO Sundar Pichai hat kürzlich in einem Interview ähnliche Ausflüchte gemacht und so jede konkrete Stellungnahme vermieden.

Googles Behauptungen müssten durch umfangreiche Untersuchungen neutraler Stellen verifiziert oder falsifiziert werden. Solange das nicht geschieht, kann Google mit dem Internet machen, was es will. Und das tut es auch.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.