Studie zeigt: ChatGPT ist an jedem zehnten wissenschaftlichen Abstract beteiligt

Eine Analyse von 14 Millionen PubMed-Abstracts zeigt, dass seit der Einführung von ChatGPT mindestens 10 Prozent der wissenschaftlichen Abstracts von KI-Textgeneratoren beeinflusst wurden. In einigen Disziplinen und Ländern ist der Anteil sogar deutlich höher.

Forscherinnen und Forscher der Universitäten Tübingen und Northwestern haben die sprachlichen Veränderungen in 14 Millionen wissenschaftlichen Abstracts zwischen 2010 und 2024 untersucht. Dabei stellten sie fest, dass mit der Einführung von ChatGPT und ähnlichen KI-Textgeneratoren die Verwendung bestimmter Stilwörter sprunghaft angestiegen ist.

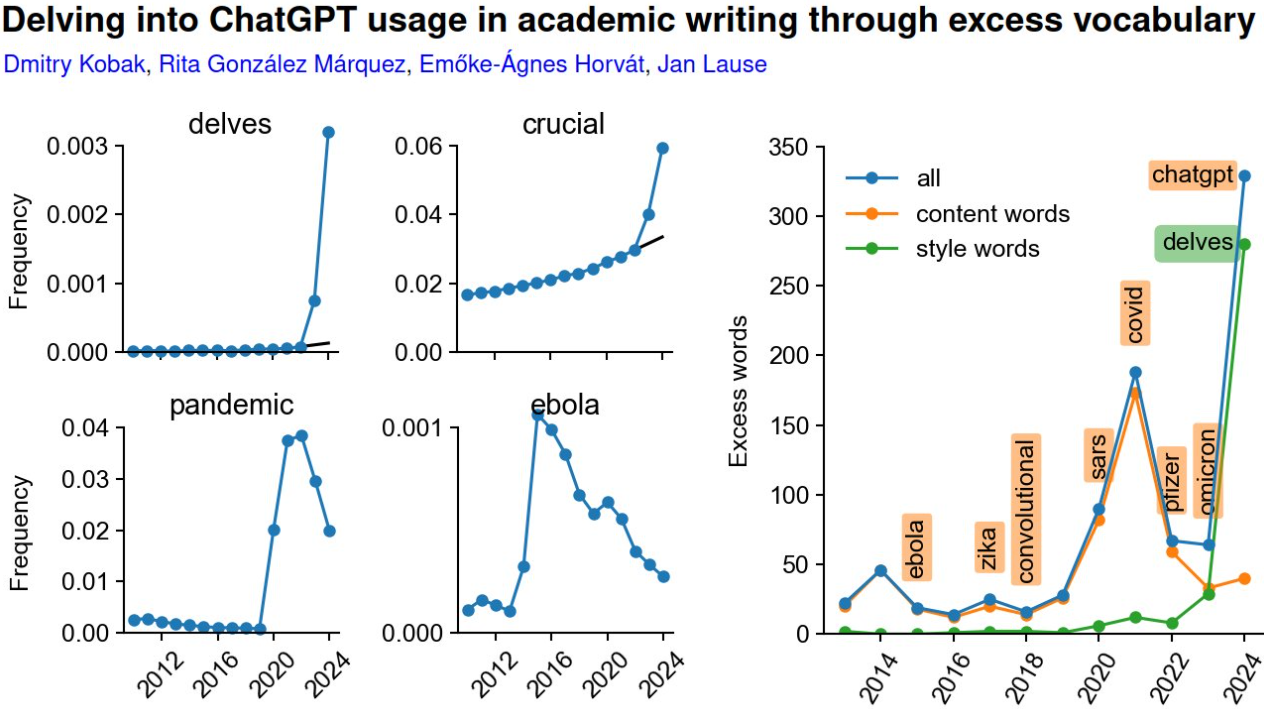

Die Wissenschaftler analysierten zunächst, welche Wörter 2024 im Vergleich zu den Vorjahren deutlich häufiger vorkamen. Darunter waren viele Verben und Adjektive wie "delve", "intricate", "showcasing" oder "underscores", die für den blumigen Schreibstil von ChatGPT typisch sind.

Basierend auf diesen Markern schätzen die Forschenden, dass im Jahr 2024 mindestens 10 Prozent aller PubMed-Abstracts mit Hilfe von KI-Textgeneratoren verfasst oder bearbeitet wurden. Der Einfluss ist teilweise sogar größer als derjenige von in ihrer Zeit inhaltlich prägnanten Wörtern wie "Covid", "Pandemie" oder "Ebola".

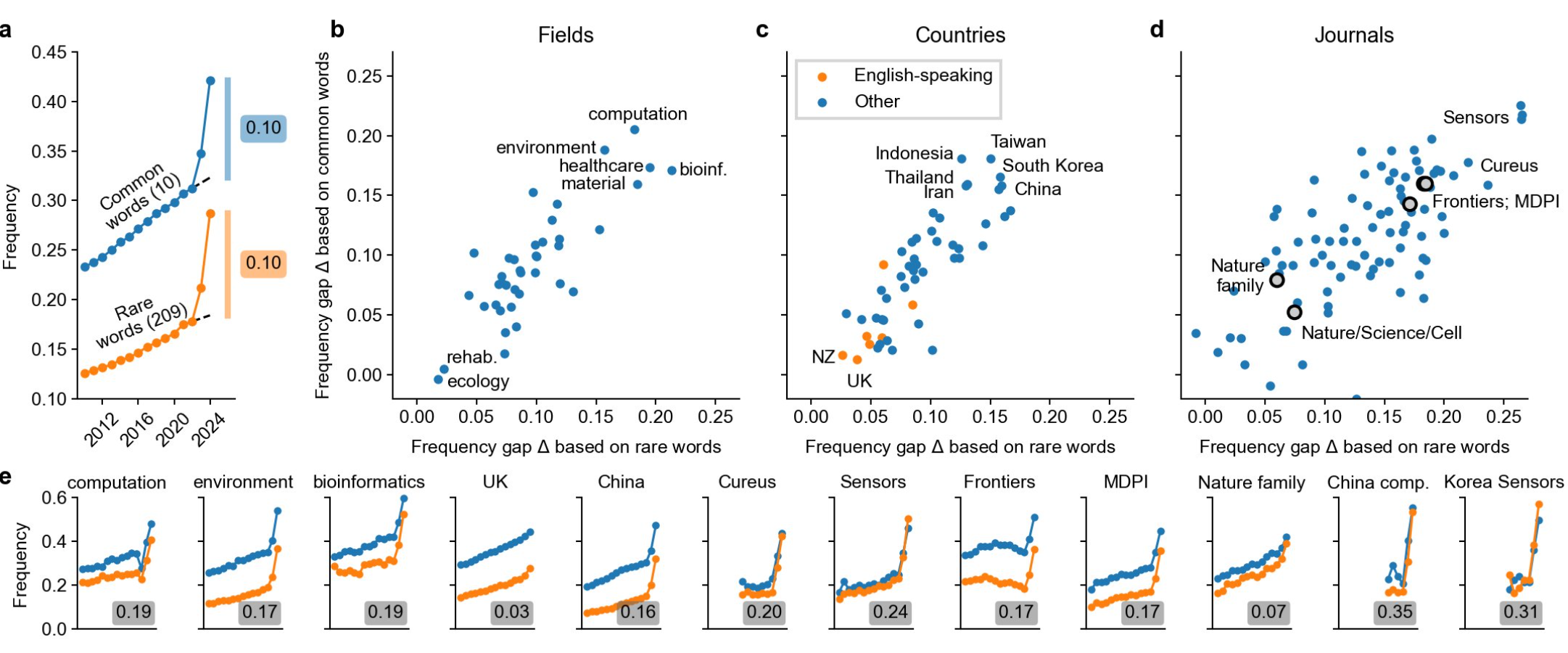

Die Forscher berechneten, dass bei PubMed-Untergruppen in Ländern wie China und Südkorea etwa 15 Prozent der Abstracts mittels ChatGPT erstellt wurden, in Großbritannien hingegen nur 3 Prozent. Das bedeutet aber nicht zwingend, dass UK-Autoren weniger ChatGPT nutzen.

Denn die tatsächliche Nutzung von KI-Textgeneratoren dürfte nach Einschätzung der Forschenden noch deutlich darüber liegen. Denn viele Forschende würden KI-generierte Texte so überarbeiten, dass typische Markerwörter nicht mehr auftauchen. Muttersprachler könnten hier im Vorteil sein, da sie solche Phrasen eher bemerken. Der tatsächliche Anteil der KI-beeinflussten Abstracts sei daher schwer zu ermitteln.

Besonders hoch war die gemessene KI-Nutzung in Zeitschriften wie Frontiers und MDPI mit etwa 17 Prozent, und in IT-Fachzeitschriften lag der Anteil sogar bei 20 Prozent. Bei chinesischen Autoren in IT-Zeitschriften war der Anteil mit 35 Prozent am höchsten.

Meta war zu früh dran

Der Einsatz von KI könnte wissenschaftliche Autoren unterstützen und Artikel lesbarer machen. Insbesondere bei Abstracts ist der Einsatz von KI nicht unbedingt problematisch, so Studienautor Dmitry Kobak.

KI-Textgeneratoren können aber auch Fakten erfinden, Vorurteile verstärken und sogar plagiieren. Außerdem könnten sie die Vielfalt und Originalität wissenschaftlicher Texte verringern.

Die Forschenden plädieren daher für eine Neubewertung der Richtlinien für den Einsatz von KI-Textgeneratoren in der Wissenschaft.

Fast schon ironisch erscheint in diesem Zusammenhang, dass das kurz vor ChatGPT von Meta veröffentlichte wissenschaftliche Open-Source-Sprachmodell "Galactica" von Teilen der wissenschaftlichen Community so scharf kritisiert wurde, dass Meta es wieder offline nehmen musste.

Offensichtlich hat das den Einzug generativer KI in das wissenschaftliche Schreiben nicht verhindert, womöglich aber ein für diese Aufgabe optimiertes System.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.