Erste Nutzer berichten über Apple Intelligence in iOS 18.1

Die ersten Entwickler:innen und andere Mutige, die die Developer-Beta auf ihren Geräten installieren, dürfen Apples KI-System auf iPhones und macOS ausprobieren.

Apple rollt seine KI-Funktionen unter dem Namen "Apple Intelligence" mit der ersten Entwickler-Beta von iOS 18.1, iPadOS 18.1 und macOS Sequoia 15.1 aus. Ein ungewöhnliches Vorgehen für das Unternehmen aus Cupertino, denn iOS 18 wartet noch auf seinen offiziellen Release für alle Nutzer:innen. Angesichts des großen Umbruchs, den der Einzug generativer KI in das Betriebssystem darstellt, will es sich und Entwickler:innen aber offenbar eine längere Testphase ermöglichen.

Ungewöhnlich frühe Entwickler-Beta für .1-Version

In der nun veröffentlichten Developer-Beta-Version sind bereits einige der auf der diesjährigen WWDC angekündigten Funktionen enthalten, auch wenn wie erwartet bisher nicht das volle Spektrum verfügbar ist. Bis dahin soll es wohl noch bis ins erste Halbjahr 2025 dauern, wie kürzlich durchgesickert ist.

Nutzer:innen können allerdings jetzt schon Schreibhilfen zum Umformulieren, Korrekturlesen und Zusammenfassen von Texten systemweit in den hauseigenen Apps sowie den meisten Drittanbieter-Apps ausprobieren.

Auch Siri hat ein Update erhalten. Neben neuer Optik ermöglicht der Assistent nun einen nahtlosen Wechsel zwischen Sprach- und Texteingabe und behält Kontext zwischen verschiedenen Anfragen bei.

Weitere praktische Neuerungen sind die automatische Anrufaufzeichnung und -transkription, die Priorisierung und Zusammenfassung von E-Mails sowie die Suche nach Fotos mittels natürlicher Sprache.

Allerdings fehlen in dieser frühen Beta-Phase noch einige angekündigte Funktionen wie die ChatGPT-Integration, Genmoji und die Bilderstellung. Zudem sind die Apple-Intelligence-Fähigkeiten aufgrund regulatorischer Einschränkungen derzeit (noch?) nicht in der EU verfügbar.

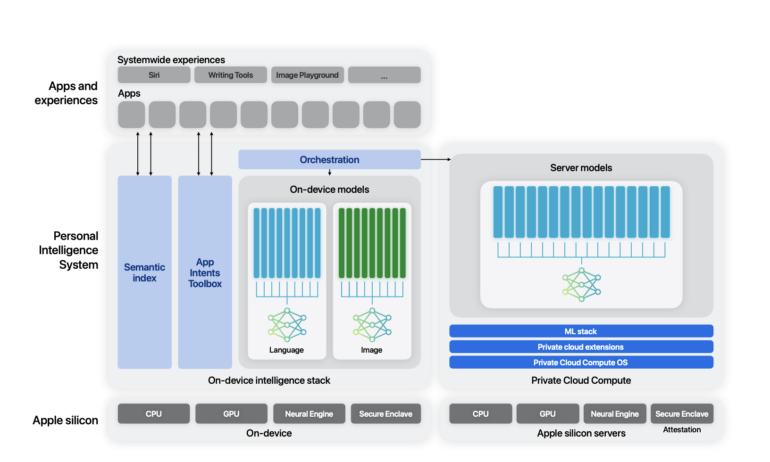

Doch selbst, wer es wagt, auf einem Gerät schon jetzt eine instabile Entwickler-Beta zu installieren, darf die KI-Funktionen nicht umgehend ausprobieren. Teile von Apple Intelligence werden nicht auf dem Gerät, sondern in einer "Private Cloud" ausgeführt. In der Beta erfolgt der Zugang über eine Warteliste, da die hohe Nachfrage die Server von Apple stark beansprucht. Weitere Voraussetzung ist ein iPhone-15-Pro-Modell, ein iPad mit M1 oder neuer sowie Mac mit M1 oder neuer.

Technischer Bericht gibt Einblicke in Apple Intelligence

Parallel hat Apple einen technischen Bericht zu Apple Intelligence veröffentlicht. Das System besteht demnach aus AFM-on-device, einem Modell mit etwa drei Milliarden Parametern, das für die effiziente Ausführung auf Geräten konzipiert ist, und AFM-server, einem serverbasierten Sprachmodell von unbekannter Größe, das die Private-Cloud-Compute-Infrastruktur von Apple nutzt.

Die Trainingsdaten für die Modelle stammen aus lizenzierten Datensätzen, kuratierten Open-Source-Daten und öffentlich verfügbaren Web-Crawl-Daten. Explizit seien keine privaten Apple-Nutzerdaten einbezogen worden.

Apple Intelligence wohl relativ langsam, aber dafür effizient

Im Netz kursieren erste Erfahrungsberichte der Apple-Intelligence-Funktionen. Ein Video von X-Nutzer @zaidmukaddam zeigt dabei jedoch, wie viel Zeit das On-Device-Modell benötigt, um einen Text umzuschreiben. Rund zehn Sekunden vergehen in seinem Test zwischen dem ersten Klick und dem überarbeiteten Text einer vergleichsweise kurzen E-Mail.

Video: X/@zaidmukaddan

Während Apple die Geschwindigkeit mit zukünftigen Updates womöglich noch erhöht, stellt das KI-System laut Tech-Journalist Max Weinbach schon jetzt seine Effizienz unter Beweis.

Abhängig von der Aufgabe sorge es für eine Leistungsaufnahme der Neural Engine von maximal sechs Watt beim Umformulieren, Mail-Zusammenfassungen benötigten nur rund ein bis zwei Watt. Auch längere Texte, im Video einer mit rund 1.000 Wörtern, verarbeite es problemlos.

Video: X/@MaxWinebach

Auffällige Änderung unter iOS ist das neue Siri-Design. Der Sprachassistent steht schon lange in der Kritik, weil er Anfragen häufig nicht wie gewünscht bearbeitet. Generative KI macht Hoffnung, dass sich das in Zukunft ändert, doch so weit ist Apple bei der Siri-Entwicklung bisher nicht. Im ersten Schritt gibt es beim Start des Sprachassistenten ein futuristisches Leuchten rund um den Bildschirm, aber keine fundamentalen Änderungen der Antworten.

Video: X/@VadimYuryev

Mit seinem kleinen Offline-Modell und der tiefen Integration ins Betriebssystem ist Apple in einer guten Position, um sich von KI-Firmen unabhängig zu machen. Gerade Rechtschreibtools wie Grammarly, LanguageTool oder DeepL könnten es auf Apple-Geräten schwer haben, wenn ähnliche Funktionen kostenlos ins Kontextmenü wandern. Apple konzentriert sich aber bewusst auf die Aufgaben, die ein Modell mit so wenigen Parametern bewältigen kann. Für die "großen Fragen" muss dann weiterhin OpenAIs ChatGPT einspringen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.