MedSAM-2 analysiert medizinische Bildserien mit minimalem menschlichem Aufwand

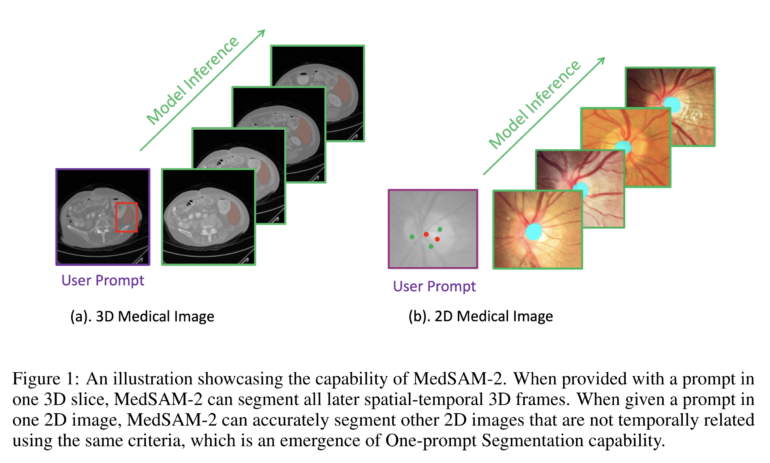

Forscher haben ein neues KI-Modell namens MedSAM-2 entwickelt, das die Segmentierung von 2D- und 3D-Bildern in der Medizin stark verbessert. Es kann mit nur einer manuellen Markierung ganze Bildserien bearbeiten.

Wissenschaftler der University of Oxford haben ein leistungsfähiges KI-Modell für die medizinische Bildsegmentierung vorgestellt. MedSAM-2 baut auf dem kürzlich von Meta veröffentlichten Segment Anything Model 2 (SAM 2) auf und behandelt medizinische Bilder ähnlich wie Videosequenzen. Laut der Studie übertrifft MedSAM-2 bisherige Spitzenmodelle bei der Segmentierung verschiedener Organe und Gewebe in 2D- und 3D-Bildern.

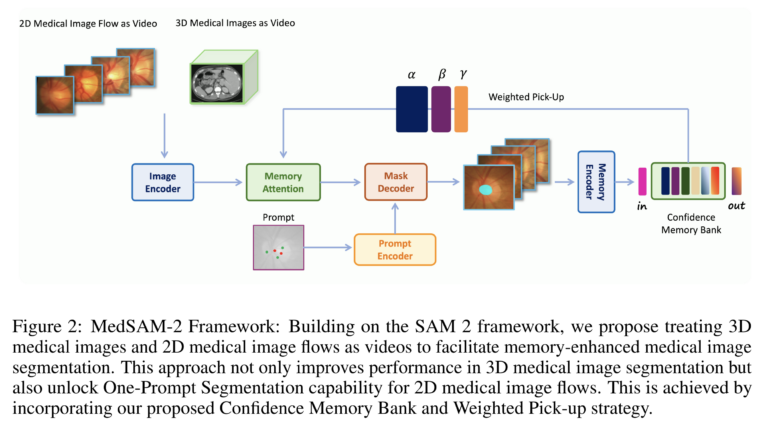

Um diese Fähigkeiten zu erreichen, behandelt MedSAM-2 medizinische Bildserien wie Videosequenzen. Das Modell nutzt außerdem eine "Confidence Memory Bank", die die zuverlässigsten Vorhersagen speichert. Bei der Analyse neuer Bilder greift es auf diese Informationen zurück und gewichtet sie je nach Ähnlichkeit zum aktuellen Bild.

Ein Kernmerkmal von MedSAM-2 ist die durch SAM 2 ermöglichte emergente Fähigkeit zur "One-Prompt-Segmentierung": Dabei kann das Modell mit nur einer Markierung in einem Beispielbild ähnliche Strukturen in weiteren Bildern erkennen und segmentieren. Diese Technik funktioniert auch bei Bildern ohne zeitlichen Zusammenhang und reduziert den Aufwand für medizinisches Personal erheblich.

MedSAM-2 setzt neue Maßstäbe in Leistung und Benutzerfreundlichkeit

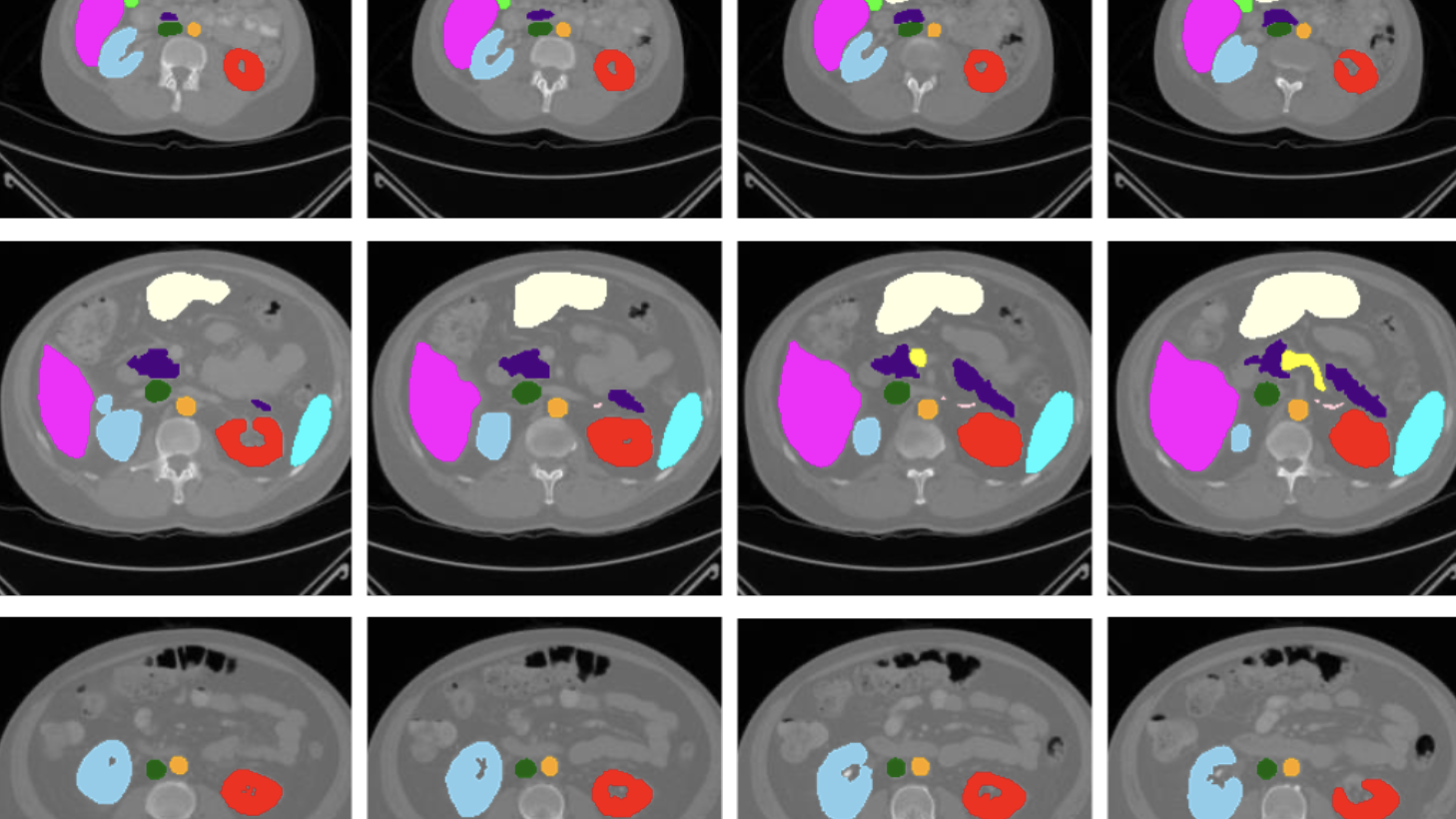

Die Forscher testeten MedSAM-2 an 15 verschiedenen medizinischen Datensätzen, darunter Aufnahmen von Bauchorganen, Sehnerven, Hirntumoren und Hautläsionen. In fast allen Fällen erzielte das neue Modell bessere Ergebnisse als spezialisierte Vorgängermodelle.

Bei der Segmentierung von Bauchorganen in 3D-Bildern erreichte MedSAM-2 einen durchschnittlichen Dice-Score von 88,6 Prozent. Dieser Wert übertrifft das bisherige Spitzenmodell MedSegDiff um 0,7 Prozentpunkte. Der Dice-Score ist ein Maß für die Übereinstimmung zwischen der KI-Vorhersage und der manuellen Segmentierung durch Experten.

Auch bei 2D-Bildern verschiedener Körperregionen schnitt MedSAM-2 besser ab als bisherige Modelle. Bei der Segmentierung des Sehnervs verbesserte es den Dice-Score um 2 Prozentpunkte, bei Hirntumoren um 1,6 und bei Schilddrüsenknoten um 2,8 Prozentpunkte.

Die Entwickler von MedSAM-2 sehen in dem Modell einen wichtigen Schritt zur Verbesserung medizinischer Bildanalysen und haben Modell und Code auf GitHub veröffentlicht. Das soll die Weiterentwicklung und Anwendung in der klinischen Praxis zu fördern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.