Neuronale Netze treffen auf Grafik-Shader: Nvidia präsentiert Zukunft des Renderings

Forscher von Nvidia haben eine Methode entwickelt, die komplexe Materialien mithilfe von künstlichen neuronalen Netzen in Echtzeit rendern kann. Sie ermöglicht fotorealistische Darstellungen bei deutlich höherer Geschwindigkeit als herkömmliche Verfahren.

Nvidia-Forscher haben eine neue Methode namens "Real-Time Neural Appearance Models" vorgestellt, die es ermöglicht, hochdetaillierte Materialien wie Keramik, Metall oder Kunststoff in Echtzeit zu rendern. Die Methode nutzt künstliche neuronale Netze, um die optischen Eigenschaften von Oberflächen zu simulieren.

Laut den Autoren können mit dem neuen Ansatz Materialien bis zu 10-mal schneller gerendert werden als mit herkömmlichen Verfahren, während die visuelle Qualität erhalten bleibt. Nvidia zeigte die Methode erstmals letztes Jahr und stellte sie auf der diesjährigen SIGGRAPH-Konferenz im Detail vor.

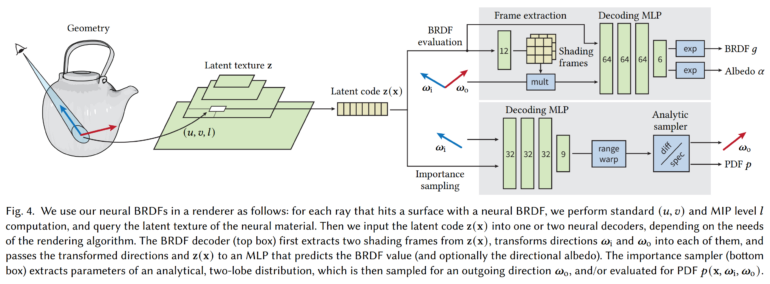

Das System besteht aus mehreren Komponenten: Ein Encoder wandelt zunächst die Materialeigenschaften um, die einer hierarchischen Textur gespeichert werden. Zwei neuronale Decoder interpretieren diese dann, um die Reflexionseigenschaften und Richtungen für das Sampling zu berechnen. Dabei setzen die Forscher auch auf gewisse grafische Priors in den Netzen, um die Methode effizienter zu machen.

Real-Time Neural Appearance Models liefern hohen Detailgrad in Echtzeit

Um die neuronalen Netze in Echtzeit-Shadern ausführen zu können, haben die Entwickler spezielle Optimierungen vorgenommen. Je nach Ausführungssituation werden die Berechnungen entweder auf Tensor-Kernen oder mit klassischen Shader-Instruktionen durchgeführt.

In Testszenen konnten die KI-Materialien die Renderzeit im Vergleich zu optimierten klassischen Implementierungen je nach Größe des Netzes um den Faktor 1,6 bis 4,1 reduzieren und Renderzeiten von unter 10 Millisekunden erreichen. Dabei blieb die visuelle Qualität weitgehend erhalten.

Die Forscher sehen ihr System als Grundlage, um filmqualitative Materialien in Echtzeit-Anwendungen wie Spielen oder interaktiven Vorschauen einsetzen zu können. Allerdings gibt es noch Einschränkungen, etwa bei Brechungseffekten.

Mehr Informationen und Beispiele zur neuen Methode sind auf der Projektseite von Nvidia verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.