So will Google Krankheiten erst hören und dann sehen

Googles HeAR zeigt vielversprechende Ergebnisse bei der Schätzung von Lungenfunktionsparametern, sogar aus Smartphone-Aufnahmen. Dies ebnet den Weg für neue, leicht zugängliche Screening-Tools für Lungenkrankheiten.

Google Research hat ein KI-System namens Health Acoustic Representations (HeAR) entwickelt, das Geräusche wie Husten oder Atmungsmuster analysiert und daraus Informationen über den Gesundheitszustand einer Person gewinnt. Das zugehörige Paper hatte Google bereits im März 2024 veröffentlicht, nun stellt es anderen Wissenschaftler:innen auch den entsprechenden Code zur Verfügung.

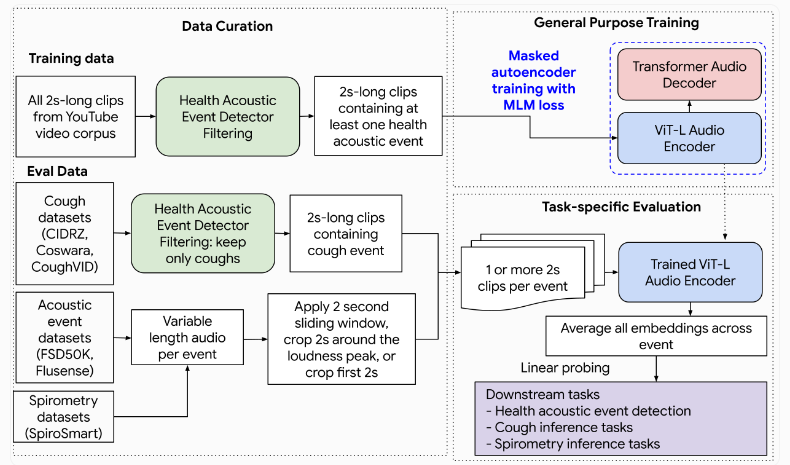

HeAR nutzt einen selbstüberwachten Lernansatz und wurde mit über 300 Millionen kurzen Audioclips trainiert, die aus nicht urheberrechtlich geschützten YouTube-Videos extrahiert wurden. Das zugrunde liegende neuronale Netzwerk basiert auf der Transformer-Architektur.

Während des Trainings wurden Teile der Audio-Spektrogramme ausgeblendet und das Netzwerk lernte, diese fehlenden Abschnitte zu rekonstruieren. So konnte HeAR kompakte Repräsentationen der Audiodaten erstellen, die relevante Gesundheitsinformationen enthalten.

Tuberkulose-Erkennung auf neuem Level

Die Forscher:innen testeten HeAR in 33 verschiedenen Aufgaben aus 6 Datensätzen, darunter die Erkennung gesundheitsrelevanter Geräusche, die Klassifizierung von Hustenaufnahmen und die Schätzung von Lungenfunktionswerten. In den meisten Benchmarks übertraf HeAR die bisher leistungsstärksten Audio-KI-Modelle.

Bei der Erkennung von Tuberkulose anhand von Hustengeräuschen erreichte es eine Genauigkeit (AUROC) von 0,739 und schlug damit das zweitbeste Modell TRILL mit 0,652. Die Autor:innen sehen hier Potenzial, mittels KI-Husten-Analyse Menschen in ressourcenarmen Gebieten zu identifizieren, die weitere Tests benötigen.

Auch bei der Schätzung von Lungenfunktionsparametern wie FEV1 (Einsekunden-Kapazität) und FVC (Vitalkapazität) aus Smartphone-Aufnahmen zeigte HeAR vielversprechende Ergebnisse. Mit einem durchschnittlichen Fehler von nur 0,418 Litern für FEV1 war es genauer als die beste Vergleichsmethode (0,479 Liter). Laut den Forscher:innen könnte dies den Weg für neue, leicht zugängliche Screening-Tools für Lungenkrankheiten wie COPD ebnen.

Bis jetzt auf zweisekündige Audioclips beschränkt

Gleichzeitig betonen sie aber auch, dass es sich bei HeAR um ein Forschungsartefakt handelt. Jegliche daraus abgeleiteten Diagnose-Tools müssten zunächst gründlich klinisch validiert werden. Auch gibt es noch technische Limitationen, beispielsweise kann HeAR bisher nur Audioclips von maximal zwei Sekunden Länge verarbeiten.

Das Google-Team plant nun, durch Techniken wie Modelldestillation und -quantisierung eine effizientere Nutzung von HeAR direkt auf mobilen Geräten zu ermöglichen. Die Fähigkeiten seines dedizierten KI-Chip, der unter anderem in Pixel-Smartphones verbaut ist, kostet Google mit seinen jüngsten Android-Ankündigungen voll aus.

Die Autor:innen sehen auch Unterstützung für ihren Ansatz von Organisationen wie der StopTB Partnership, einer von den Vereinten Nationen unterstützten Organisation, die Expert:innen und betroffene Gemeinschaften zusammenbringt, um Tuberkulose bis 2030 zu heilen.

Interessierte Wissenschaftler:innen können nun das trainierte HeAR-Modell sowie eine anonymisierte Version des CIDRZ-Datensatzes (Husten-Audiodaten) bei Google anfragen, weitere Informationen dazu finden sich auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.