Neuer Benchmark TableBench offenbart Schwächen von KI-Modellen bei Tabellendaten

Forschende haben einen neuen Datensatz entwickelt, um die Leistung von KI-Modellen bei der Beantwortung komplexer Fragen zu Tabellendaten zu bewerten. Selbst fortschrittliche Systeme schneiden dabei deutlich schlechter ab als Menschen.

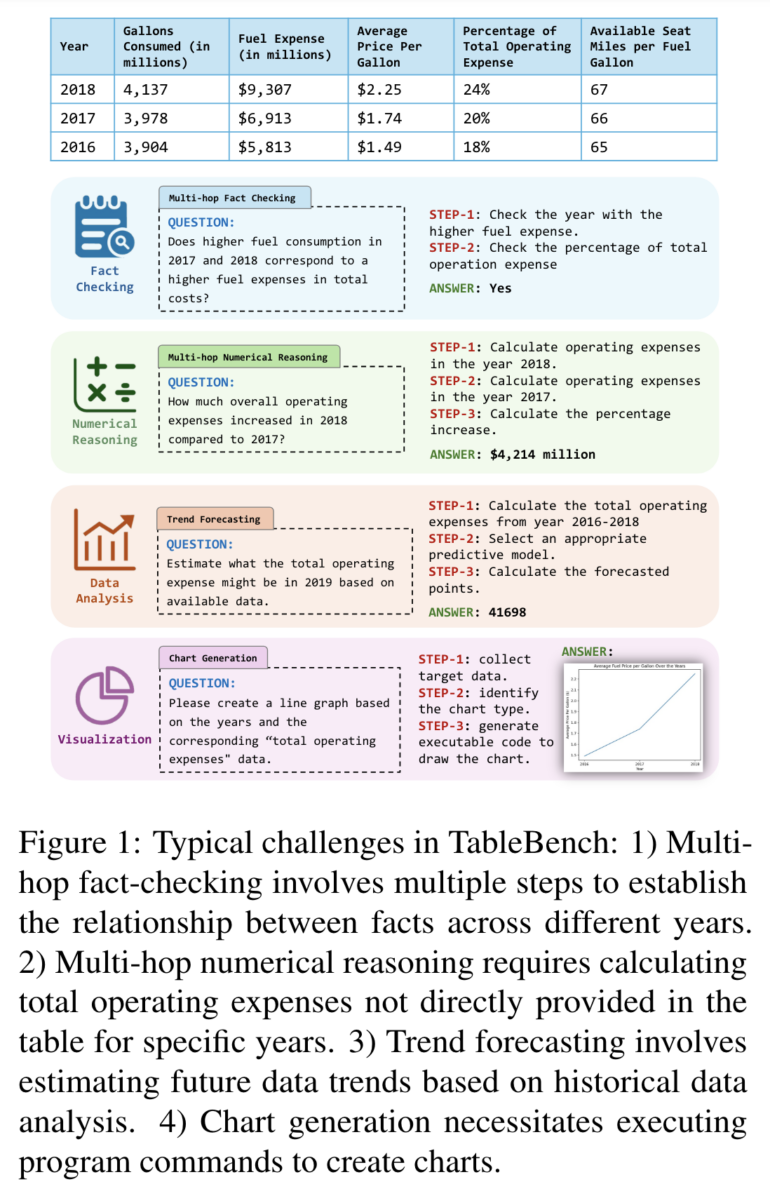

Ein Forschungsteam der Beihang Universität in China hat mit TableBench einen neuen Benchmark vorgestellt, der die Fähigkeiten von KI-Modellen im Umgang mit Tabellendaten auf die Probe stellt. Der Datensatz umfasst 886 Frage-Antwort-Paare aus 18 verschiedenen Kategorien und deckt damit ein breites Spektrum an Aufgaben ab, darunter Faktenüberprüfung, numerische Berechnungen, Datenanalyse und Visualisierung.

Laut den Forschenden soll TableBench die Lücke zwischen akademischen Benchmarks und realen Anwendungsszenarien schließen. Die durchschnittliche Anzahl der "Denkschritte", die für die Beantwortung einer Frage erforderlich sind, liegt bei 6,26 - deutlich höher als bei vergleichbaren Datensätzen.

Die Wissenschaftler evaluierten über 30 große Sprachmodelle auf TableBench, darunter sowohl Open-Source- als auch proprietäre Systeme. Selbst das leistungsfähige Modell GPT-4o erreichte nur etwa 54 % der menschlichen Leistung. Claude-Modelle wurden nicht getestet.

Die Ergebnisse zeigen, dass selbst fortschrittliche KI-Modelle noch erheblichen Verbesserungsbedarf haben, um den Anforderungen realer Anwendungen gerecht zu werden.

Microsoft arbeitet an Lösungen

Parallel zu TableBench stellten die Wissenschaftler auch TableInstruct vor, einen Trainingsdatensatz mit etwa 20.000 Beispielen. Damit trainierten sie ein eigenes Modell namens TABLELLM, das eine Leistung vergleichbar mit GPT-3.5 erzielte.

Forscher von Microsoft haben zudem kürzlich mit SpreadsheetLLM eine Methode vorgestellt, die die Leistung von Sprachmodellen in der Tabellenverarbeitung verbessern kann. Der neue Benchmark TableBench offenbart jedoch, dass es noch ein weiter Weg ist, bis KI-Systeme in diesem Bereich mit menschlichen Fähigkeiten mithalten können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.