Microsoft veröffentlicht Korrekturfunktion für KI-Halluzinationen

Microsoft kündigt eine neue Funktion für Azure AI Content Safety an, die nicht nur Inkonsistenzen in KI-Ausgaben erkennt, sondern diese auch korrigiert. Damit soll das Vertrauen in generative KI-Technologien gestärkt werden.

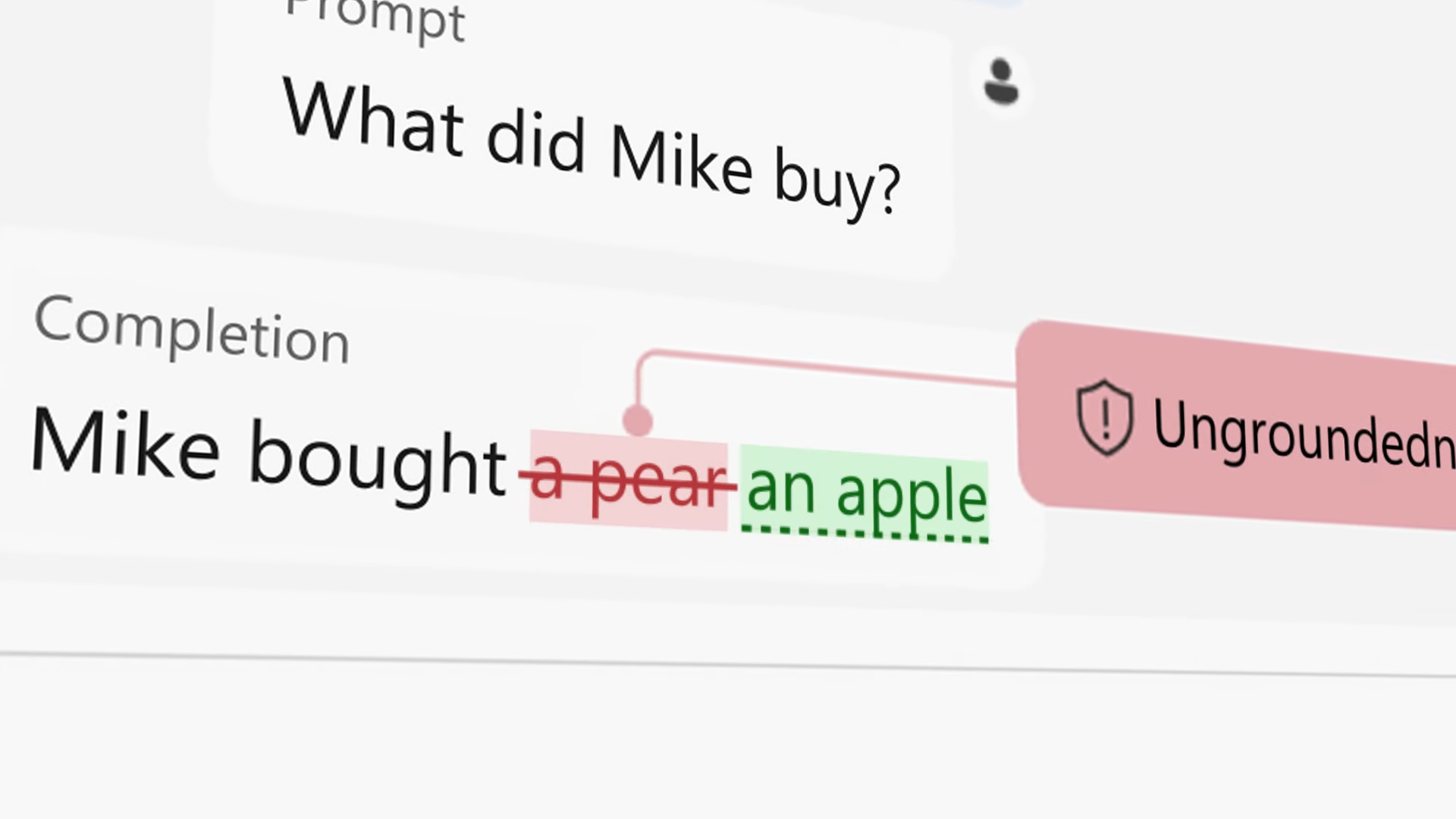

Microsoft hat eine Vorschau der neuen "Korrekturfunktion" innerhalb der Groundedness Detection von Azure AI Content Safety angekündigt. Groundedness Detection ist eine Funktion, die unzureichend begründete oder halluzinierte Inhalte in KI-Ausgaben identifizieren soll, indem sie die KI-Ausgaben mit zugrundeliegenden Dokumenten abgleicht. Eine ähnliche Funktion bietet Google bei Vertex AI mit dem Google Search Grounding.

Keine absolute Verbesserung, aber bessere Übereinstimmung mit den Grundlagendokumenten

Wie Microsoft betont, verbessert sie die Zuverlässigkeit und Vertrauenswürdigkeit der KI-Ausgaben, garantiert aber keine absolute Genauigkeit. Sie hilft dabei, die Übereinstimmung der generierten Inhalte mit den Quelldokumenten zu verbessern.

Die generative KI-Anwendung muss daher mit Grundlagendokumenten verbunden sein, die für die Dokumentenzusammenfassung und RAG-basierte Frage-Antwort-Szenarien verwendet werden.

Wird dann ein unzureichend begründeter Satz erkannt, löst dies eine neue Anfrage an ein kleines KI-Modell zur Korrektur aus. Das Large Language Model (LLM) bewertet den unbegründeten Satz anhand des Grundlagendokuments. OpenAI stellte kürzlich ein ähnliches Verfahren vor.

Wenn der Satz keinen Inhalt enthält, der sich auf das Grundlagendokument bezieht, kann er vollständig gefiltert werden. Wenn jedoch Inhalte aus dem Grundlagendokument vorhanden sind, schreibt das Foundation Model den unbegründeten Satz so um, dass er mit dem Grundlagendokument übereinstimmt.

Die Daten in einem Paper zu einer Vorabversion der Methode zeigen, dass die "Groundedness Detection" sehr effektiv darin ist, Inkonsistenzen zwischen KI-generierten Texten und den zugrundeliegenden Quellen zu erkennen und zu korrigieren. Nach Anwendung des Verfahrens verbleiben nur noch sehr wenige (im günstigsten Fall 0,1-1 %) dieser spezifischen Probleme.

Das bedeutet jedoch nicht, dass 99 Prozent aller generierten Inhalte fehlerfrei sind: Die Methode konzentriert sich nur auf bestimmte Arten von Inkonsistenzen und sagt nichts über die Gesamtgenauigkeit aus.

Halluzinationen erschweren Microsoft den Verkauf von KI

Bemerkenswerterweise räumt Microsoft in der Ankündigung ein, dass Halluzinationen bisher ein Showstopper für die Verbreitung der generativen KI sind. Das Unternehmen betont, dass Bedenken hinsichtlich Halluzinationen viele Anwendungen der generativen KI in kritischen Bereichen wie der Medizin zurückgehalten haben.

Ebenso hätten "Halluzinationsbedenken" einen breiteren Einsatz von Copiloten in der Öffentlichkeit verhindert. Die neue Korrekturfunktion soll helfen, diese Anwendungen zu ermöglichen.

Kritiker könnten anmerken, dass Microsoft hier KI-Fehler mit KI bekämpfen will, die noch immer für Halluzinationen, auch bekannt als Bullshit, anfällig ist, sodass das Problem nicht grundlegend gelöst und möglicherweise ein falsches Gefühl von Sicherheit vermittelt wird.

Die KI-Suche von Microsoft hat in der Vergangenheit Wahlinformationen und Informationen über eine Person erfunden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.