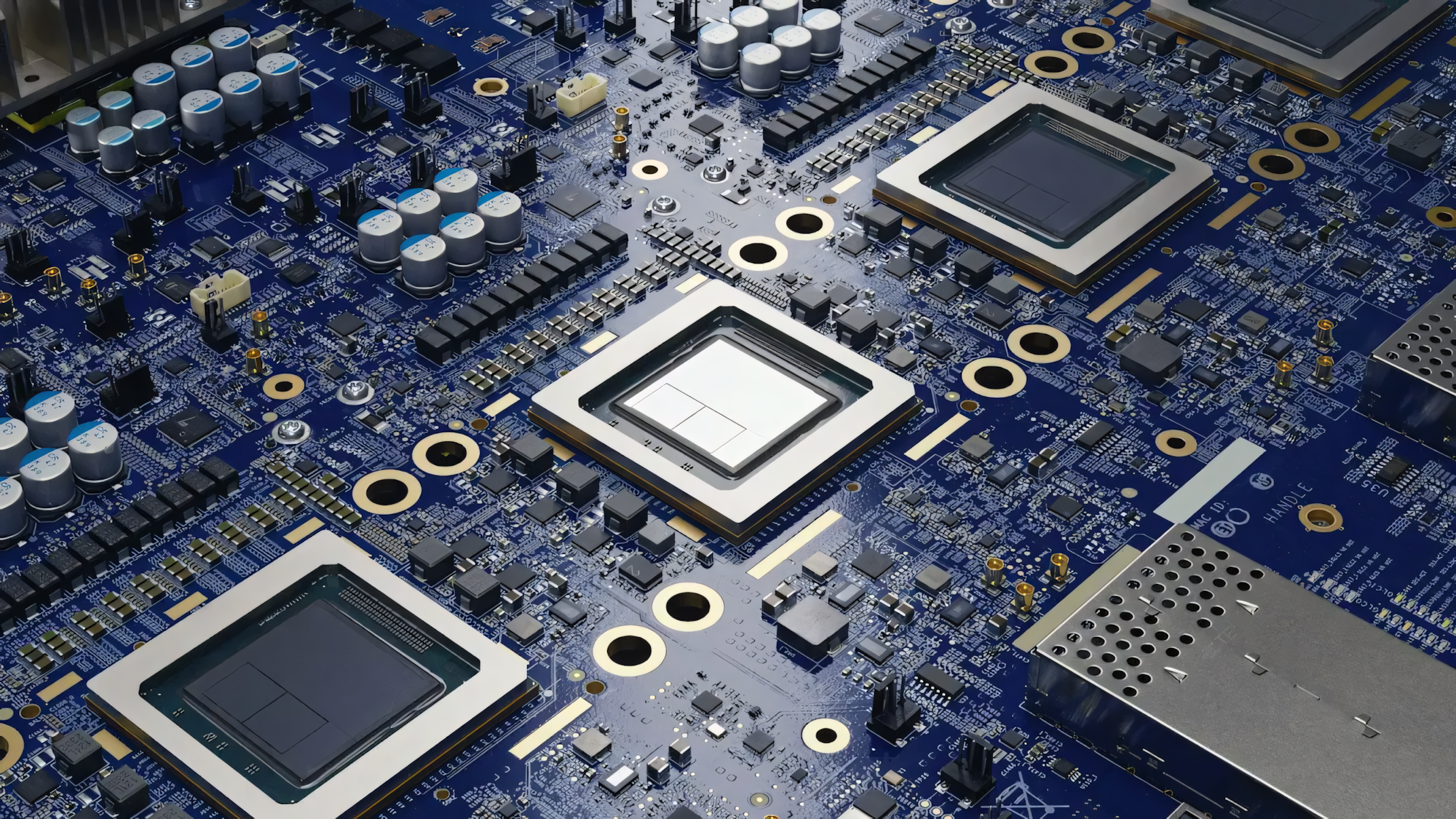

Google setzt auf KI-Chip-Designer: AlphaChip bereits in dritter TPU-Generation im Einsatz

Google DeepMind veröffentlicht Details zu seinem KI-System AlphaChip, das die Entwicklung von Computerchips beschleunigt und optimiert. Die von AlphaChip generierten Chip-Layouts werden bereits in Googles KI-Beschleunigern eingesetzt.

Google DeepMind hat in einem Nachtrag zu seiner 2021 in Nature veröffentlichten Studie weitere Details zu seinem KI-System für Chip-Design bekannt gegeben. Das System, das nun offiziell AlphaChip heißt, nutzt Reinforcement Learning, um in kurzer Zeit optimierte Chip-Layouts zu erstellen.

Laut Google DeepMind wurde AlphaChip bereits für das Design von Chip-Layouts in den letzten drei Generationen von Googles KI-Beschleuniger Tensor Processing Unit (TPU) eingesetzt. Die Leistung des Systems habe sich dabei stetig verbessert: Bei der TPU v5e wurden 10 Blöcke von AlphaChip platziert und die Leitungslänge um 3,2% gegenüber menschlichen Experten reduziert. Bei der aktuellen 6. Generation namens Trillium stieg dies auf 25 Blöcke und 6,2% Reduktion.

Laut Deepmind nutzt AlphaChip einen ähnlichen Ansatz wie AlphaGo und AlphaZero. Es behandelt das Chip-Layout als eine Art Spiel, bei dem Schaltkreiskomponenten nacheinander auf einem Gitter platziert werden. Ein dafür entwickeltes Graph Neural Network ermöglicht es dem System, Beziehungen zwischen verbundenen Komponenten zu lernen und über verschiedene Chips zu generalisieren.

Neben Google setzen auch andere Unternehmen auf den Ansatz. So hat der Chiphersteller MediaTek AlphaChip für die Entwicklung seiner fortschrittlichsten Chips erweitert, darunter der Dimensity Flagship 5G für Samsung-Smartphones.

AlphaChip erhält Open-Source-Update

Google DeepMind sieht weiteres Potenzial, den gesamten Chip-Design-Zyklus zu optimieren. Zukünftige Versionen von AlphaChip sollen von der Computerarchitektur bis zur Fertigung eingesetzt werden. Das Unternehmen hofft, damit Chips noch schneller, günstiger und energieeffizienter zu machen.

Im Rahmen der Veröffentlichung des Nature-Nachtrags hat Google DeepMind auch einige Open-Source-Ressourcen zu AlphaChip bereitgestellt. Laut den Forschern wurde ein Software-Repository veröffentlicht, mit dem die in der ursprünglichen Studie beschriebenen Methoden vollständig reproduziert werden können.

Externe Forscher können dieses Repository nutzen, um das System auf verschiedenen Chip-Blöcken vorzutrainieren und dann auf neue Blöcke anzuwenden. Google DeepMind stellt dafür auch einen vortrainierten Modell-Checkpoint zur Verfügung, der auf 20 TPU-Blöcken trainiert wurde.

Die Forscher empfehlen jedoch, für beste Ergebnisse ein Vortraining auf eigenen, anwendungsspezifischen Blöcken durchzuführen. Dafür haben sie ein Tutorial bereitgestellt, das erklärt, wie man das Vortraining mit dem Open-Source-Repository durchführen kann.

Das Tutorial und das vortrainierte Modell gibt es auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.