Movie Gen: Metas neues KI-Modell erzeugt Videos, Bilder und Audio aus Text

Meta hat sein bisher fortschrittlichstes KI-Medienmodell vorgestellt. "Movie Gen" kann Videos, Bilder und Audio generieren sowie Videos bearbeiten. Das Unternehmen sieht darin großes Potenzial für neue Anwendungen.

Das Herzstück von Movie Gen bildet ein Transformer-Modell mit 30 Milliarden Parametern, das Videos und Bilder aus Textbeschreibungen erzeugen kann. Laut Meta ist das Modell in der Lage, Videos mit einer Länge von bis zu 16 Sekunden bei 16 Bildern pro Sekunde zu generieren.

Die Videos können in verschiedenen Seitenverhältnissen (1:1, 9:16, 16:9) und mit einer Auflösung von 768 × 768 Pixeln erstellt werden. Ein zusätzlicher Upscaler kann die Auflösung auf Full HD (1080p) erhöhen.

Movie-Gen soll fotorealistische Szenen nur aus Text erzeugen können. | Video: Meta AI

Für die Audiogenerierung ist ein separates Modell mit 13 Milliarden Parametern zuständig. Es kann zu einem Video passenden Ton, Hintergrundmusik und Geräuscheffekte mit einer maximalen Länge von 45 Sekunden und einer Abtastrate von 48 kHz erzeugen.

Beispiel Audiogenerierung | Video: Meta AI

Darüber hinaus verfügt Movie Gen über eine Komponente zur Videobearbeitung, die bestehende Videos anhand von Textanweisungen verändern kann. Eine weitere Funktion ermöglicht die Erstellung personalisierter Videos durch die Kombination eines Bildes einer Person mit einer Textbeschreibung.

Beispiel Video-Editing | Video: Meta AI

Meta sieht Movie Gen vor der Konkurrenz

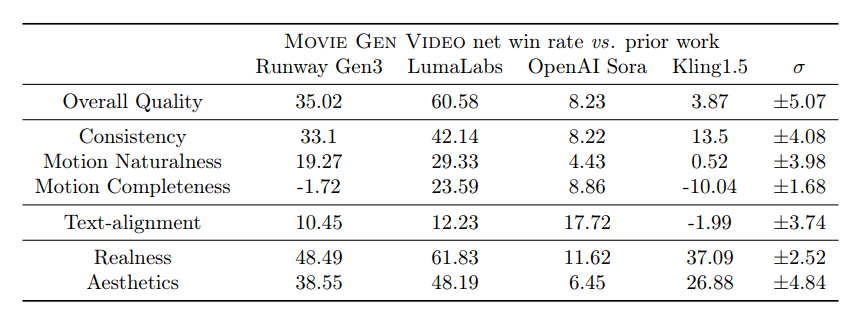

Laut Meta schneidet Movie Gen in menschlichen Bewertungen besser ab als vergleichbare Modelle anderer Unternehmen wie Runway, Sora, LumaLabs, Kling und Pika. Der Abstand zu Sora und Kling fällt dabei am geringsten aus. Allerdings soll Sora konsistente Videos von bis zu einer Minute erzeugen können, bei einer höheren Framerate, als sie Meta für Movie Gen angibt.

Meta gibt an, die Modelle mit einer Kombination aus lizenzierten und öffentlich verfügbaren Datensätzen trainiert zu haben. Das Videogenerierungsmodell wurde mit etwa 100 Millionen Videos und einer Milliarde Bildern vortrainiert. Für das Audio-Modell wurden etwa eine Million Stunden Audiodaten verwendet. Weitere technische Details hat Meta in einem Forschungspapier veröffentlicht.

Movie Gen wurde laut Meta für Forschungszwecke entwickelt und ist derzeit nicht öffentlich verfügbar. Das Unternehmen plant, eng mit Filmemachern und Kreativen zusammenzuarbeiten, um deren Feedback zu integrieren. Ein möglicher Veröffentlichungstermin wurde nicht genannt.

Dritte Generation von Metas KI-Medienmodellen

Meta bezeichnet Movie Gen als dritte Generation seiner KI-Medienmodelle. Die erste Generation umfasste die "Make-A-Video"-Modelle zur Erstellung von Bildern, Audio, Video und 3D-Animationen. Die zweite Generation bestand aus den "Llama Image"-Modellen zur Bildgenerierung und -bearbeitung.

Laut Meta kombiniert Movie Gen all diese Modalitäten und ermöglicht eine präzisere Kontrolle. Das Unternehmen geht davon aus, dass die Modelle verschiedene neue Produkte ermöglichen könnten.

Meta räumt ein, dass die aktuellen Modelle noch Einschränkungen haben. Insbesondere die Inferenzzeit und die Qualität der Modelle könnten durch weiteres Skalieren verbessert werden. Auch bei komplexer Geometrie, Objektmanipulation und Physik gebe es noch Herausforderungen. Die Audio-Synchronisation kann bei dichten oder kleinen Bewegungen ebenfalls noch Schwierigkeiten bereiten.

Meta betont, dass die Technologie Künstler und Animatoren nicht ersetzen, sondern neue Ausdrucksmöglichkeiten schaffen soll. Als mögliche Anwendungen nennt Meta animierte "Ein Tag im Leben"-Videos für Instagram Reels oder personalisierte Geburtstagsgrüße für WhatsApp.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.