Große Sprachmodelle als Konsens-Maschinen - ähnlich wie beim Crowdsourcing

Eine neue Studie von Harvard-Forschern zieht Parallelen zwischen großen Sprachmodellen und Crowdsourcing. Die Ergebnisse zeigen, warum KI-Systeme bei allgemeinen Themen oft korrekt sind, aber bei speziellen Fragen häufig halluzinieren.

Die Forscher Jim Waldo und Soline Boussard argumentieren, dass KI-Sprachmodelle ähnlich wie Crowdsourcing-Plattformen funktionieren. Statt Antworten von Experten zu sammeln, generieren sie die wahrscheinlichste Antwort basierend auf allen im Internet verfügbaren Fragen und Antworten.

"Ein GPT sagt uns, dass Gras grün ist, weil auf die Worte 'Gras ist' am häufigsten 'grün' folgt. Es hat nichts mit der Farbe des Rasens zu tun", heißt es in der Studie.

Diese Funktionsweise könnte laut den Forschern erklären, warum KI-Systeme bei Themen mit allgemeinem Konsens oft korrekte Antworten liefern, aber bei kontroversen oder obskuren Themen zu Halluzinationen neigen.

Um ihre Hypothese zu testen, stellten Waldo und Boussard verschiedenen KI-Modellen über mehrere Wochen hinweg eine Reihe von Fragen, die in ihrer Obskurität und Kontroversität variierten.

KI-Modelle versagen bei speziellen Themen

Die Ergebnisse bestätigten die Vermutung des Forschers und der Forscherin: Bei Themen mit breitem Konsens, wie bekannten Zitaten von Barack Obama, lieferten die Modelle meist korrekte Antworten. Bei spezielleren Fragen, etwa zu wissenschaftlichen Papieren über Ferroelektrizität, produzierten sie jedoch oft falsche Zitate oder kombinierten real existierende Autoren mit nicht existierenden Papieren.

Besonders deutlich wurde dies bei der Zitierung wissenschaftlicher Arbeiten. Zwar konnten alle getesteten Systeme korrekte Zitierformate liefern, die Inhalte waren jedoch oft falsch. ChatGPT-4 nannte etwa häufig Autorengruppen, die tatsächlich zusammen publiziert hatten - aber nicht die angegebene Arbeit.

Die Untersuchung zeigt auch, dass die Antworten der Systeme stark vom Kontext abhängen können, selbst wenn aufeinanderfolgende Fragen inhaltlich nicht zusammenhängen. So antwortete ChatGPT-3.5 auf die Frage "Israelis sind …" mit drei Wörtern, wenn zuvor nach einer dreiwortigen Beschreibung des Klimawandels gefragt wurde. Manchmal ignorierte das Modell die Anzahl vorgegebener Wörter.

Implikationen für den Umgang mit KI-generierten Inhalten

Die Studie legt nahe, dass KI-generierte Inhalte ähnlich wie Crowdsourcing-Ergebnisse behandelt werden sollten. Sie können bei allgemeinen Themen nützlich sein, sollten aber bei spezialisierten oder kontroversen Fragen mit Vorsicht interpretiert werden.

"LLMs und die darauf aufbauenden generativen vortrainierten Transformer passen in das Muster des Crowdsourcing, da sie auf dem in ihren Trainingsdaten verkörperten Diskurs basieren", schreiben die Autoren. "Die in diesem Diskurs gefundenen Konsensansichten sind oft sachlich korrekt, scheinen aber bei kontroversen oder ungewöhnlichen Themen weniger genau zu sein."

Waldo und Boussard warnen daher davor, LLMs bei obskuren oder polarisierenden Themen unkritisch zu vertrauen. Ihre Genauigkeit hänge stark von der Breite und Qualität der Trainingsdaten ab. Die Systeme könnten zwar für viele alltägliche Aufgaben nützlich sein, bei komplexen Themen sei jedoch Vorsicht geboten.

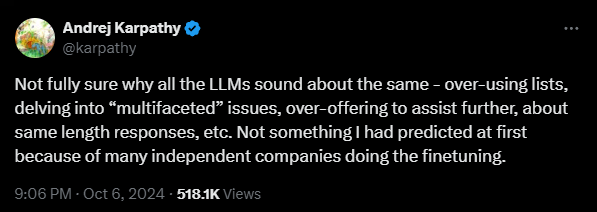

Zu den Beobachtungen der beiden Forscher passt auch die Feststellung des bekannten KI-Entwicklers Andrej Karpathy, Ex-OpenAI- und Tesla-KI-Chef: Alle LLMs klingen fast identisch. "Das hätte ich nicht erwartet, da viele unabhängige Firmen das Feintuning vornehmen", schreibt Karpathy.

Wissensrecherche ist nur ein Anwendungsszenario für Spachmodelle

Die Beobachtungen der Forschenden beziehen sich insbesondere auf die Anwendung von LLMs im Kontext des im Training erworbenen Wissens, etwa für die Recherche. Ansonsten bieten Sprachmodelle weitere Anwendungsszenarien, da sie beim Training neben dem Wissen über die Welt auch Wissen über Sprache erworben haben.

So können sie etwa als eine Art Text-Taschenrechner eingesetzt werden, um bestehende Quellen in neue Formate zu bringen, oder um auf der Basis von Wissensdatenbanken (RAG) mit Spezialwissen sinnvolle Textabschnitte zu extrahieren. Halluzinationen sind dabei nicht ausgeschlossen, aber besser kontrollierbar.

Schließlich kann das Spezialwissen von quelloffenen und einigen kommerziellen Sprachmodellen durch sogenanntes Feintuning mit eigenen Daten oder einfach durch geschicktes Prompting verbessert werden. Häufig erzielt eine Kombination aus Maßnahmen (RAG + Fine-Tuning + SOTA-Prompts) die besten Resultate.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.