KI-Software korrigiert Echtzeit-Blickkontakt in Videos für 10 Cent pro Minute

Mit einem einzigen API-Aufruf soll es möglich sein, den Blickkontakt in Videos in Echtzeit zu korrigieren. Das verspricht zumindest das KI-Start-up Sieve, das jetzt eine entsprechende Programmierschnittstelle vorgestellt hat.

Fehlender Blickkontakt kann Videos unpersönlich und weniger ansprechend wirken lassen. Das KI-Start-up Sieve will das ändern: Mit seiner neuen API soll sich der Blickkontakt in Videos automatisch korrigieren lassen - in Echtzeit und mit nur einem einzigen Aufruf der Programmierschnittstelle.

Laut Sieve läuft die Blickkontaktkorrektur sehr schnell und lässt sich einfach in eigene Anwendungen integrieren. Damit hebe sich die Lösung von bisherigen Ansätzen ab, die oft entweder eine schlechte Qualität liefern oder komplexe Entwicklungsumgebungen erfordern, so das Unternehmen.

Mögliche Einsatzgebiete sieht Sieve vorwiegend bei Bildschirmaufzeichnungen, in der Videobearbeitung und im Rundfunk. Aber auch für andere Anwendungen, bei denen Sprecher häufig direkt in die Kamera blicken sollen, könnte die Technologie interessant sein.

KI analysiert Kopfhaltung und korrigiert Blickrichtung

Technisch basiert die Blickkorrektur auf einem KI-Modell, das zunächst den Bereich um die Augen erfasst und analysiert. Mithilfe von Gesichtserkennung identifiziert die KI markante Stellen im Gesicht und berechnet die Kopfhaltung im Raum.

Anschließend separiert die KI den Augenbereich vom restlichen Gesicht und speist ihn in ein neuronales Netz ein. Dieses schätzt den aktuellen Blickwinkel und passt die Augen so an, dass der Eindruck von direktem Blickkontakt entsteht. Ein Paper oder mehr technische Details zur Funktionsweise des Modells hat das Unternehmen bislang nicht veröffentlicht.

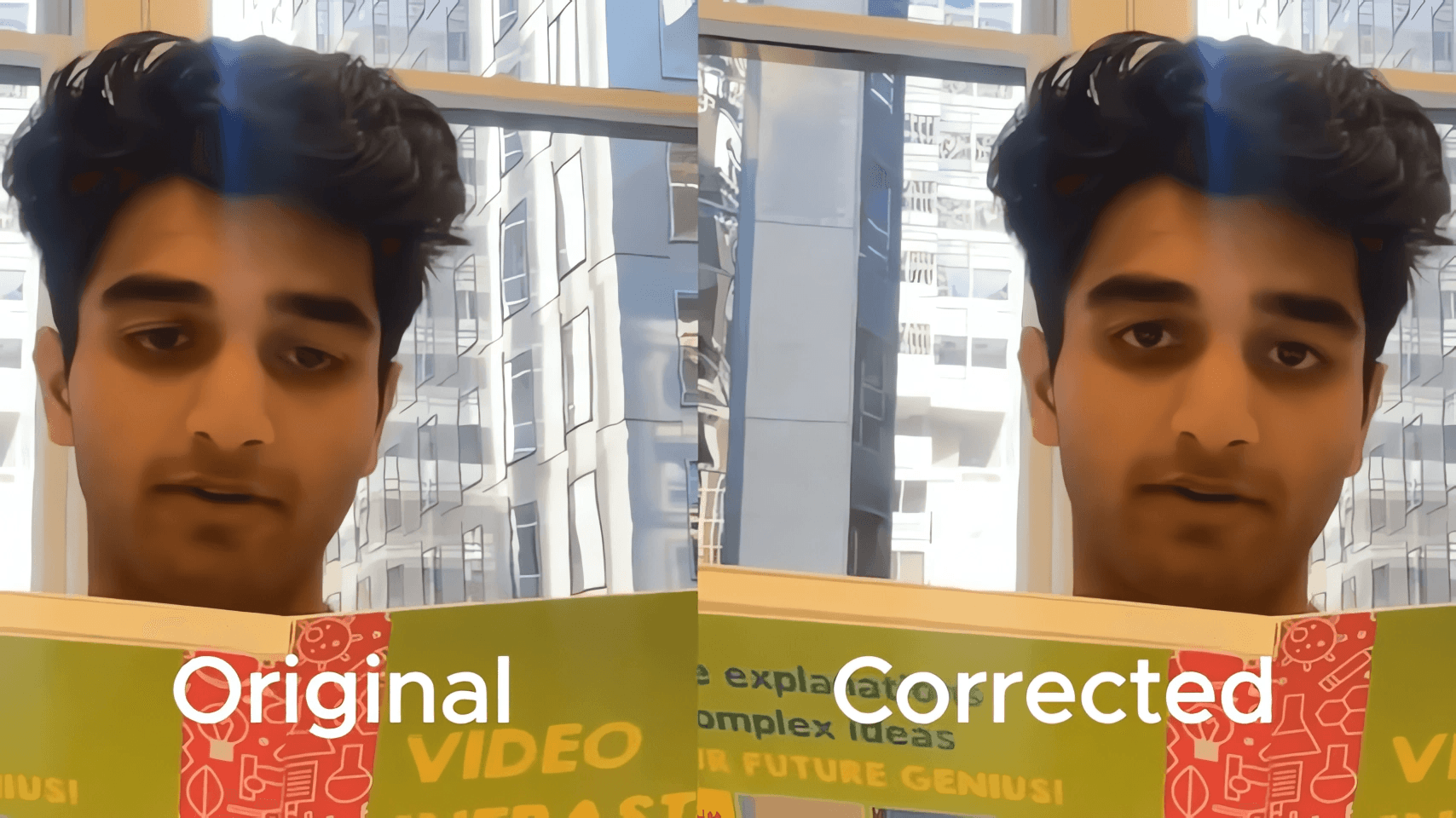

Sieve korrigiert die Blickrichtung, so dass die Personen immer direkt in die Kamera schauen. | Video: Sieve

Die Intensität der Blickkorrektur variiert dabei abhängig von der Kopfhaltung, um ein möglichst natürliches Ergebnis zu erzielen. Auch Blinzeln und kurzzeitige Verdeckungen der Augen erkennt die KI und setzt die Korrektur in diesen Fällen aus.

Laut Sieve läuft der gesamte Prozess mit minimaler Latenz und ermöglicht so eine Blickkorrektur in Echtzeit. Damit ähnelt die Technologie dem im September vorgestellten SieveSync-Verfahren, mit dem sich Lippenbewegungen in Videos nachträglich anpassen lassen.

Inspiration von Nvidia und LivePortrait

Als Inspiration für die Blickkontaktkorrektur nennt Sieve eine Kombination aus Nvidias Broadcast-Technologie und der Fähigkeit von LivePortrait, gezielt einzelne Gesichtspartien zu manipulieren.

Wer das Modell an eigenen Videos ausprobieren möchte, kann dies in einem eigens eingerichteten Playground tun. Die Schnittstelle kostet 10 US-Cent pro verarbeiteter Videominute. Für die Integration in eigene Python-Anwendungen stellt das Unternehmen zudem eine Anleitung bereit.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.