Google will neues Gemini-Modell angeblich im Dezember veröffentlichen

Google plant die Veröffentlichung seines nächsten großen Sprachmodells für Dezember. Intern sollen die Leistungsverbesserungen jedoch hinter den Erwartungen zurückbleiben.

Laut Insider-Quellen von The Verge will Google sein neues KI-Sprachmodell Gemini 2.0 im Dezember vorstellen. Der KI-Leak-Account "Jimmy Apples", der in der Vergangenheit häufig richtig lag, berichtet, dass erste Business-Kunden bereits Zugriff auf das neue Modell haben.

Allerdings soll Gemini 2.0 laut The Verge nicht die erhofften Leistungssprünge zeigen, die sich das Team um Deepmind-Gründer Demis Hassabis versprochen habe. Dennoch seien einige interessante neue Funktionen zu erwarten.

Auch andere Technologieunternehmen arbeiten mit Hochdruck an neuen Modellen: Elon Musks xAI trainiert derzeit Grok 3 auf einem Cluster von 100.000 Nvidia H100-Chips in seinem neuen Supercomputer in Memphis. Meta entwickelt laut The Verge parallel Llama 4 mit noch mehr Rechenleistung.

Tech-Giganten setzen auf neue Modelle und mehr Rechenpower

Die möglicherweise enttäuschende Entwicklung bei Googles Flaggschiff-LLM könnte auch erklären, warum Google massiv in neue Expertise investiert: Der Konzern übernahm indirekt das Start-up Character.ai für angeblich bis zu 2,5 Milliarden US-Dollar - vor allem, um den renommierten KI-Forscher Noam Shazeer und sein Team zurück zu Google zu holen.

Shazeer, der 2017 die Transformer-Architektur mitentwickelte, soll bei Google an einem separaten Reasoning-Modell arbeiten, das mit OpenAIs o1 konkurrieren kann. Auch Meta arbeitet an solchen Modellen. Einer der treibenden Forscher hinter der o1-Architektur, Noam Brown, wechselte von Meta zu OpenAI. Bei Meta erzielte er Logik-Durchbrüche wie CICERO.

Die KI-Unternehmen erhoffen sich von der neuen Reasoning-Architektur weitere Skalierungspotenziale, indem sie mehr Rechenleistung in die Inferenzzeit - also die "Denkzeit" der KI - investieren, statt wie bisher primär in das Vortraining mit vielen Daten.

Anzeichen für Stagnation bei großen Sprachmodellen

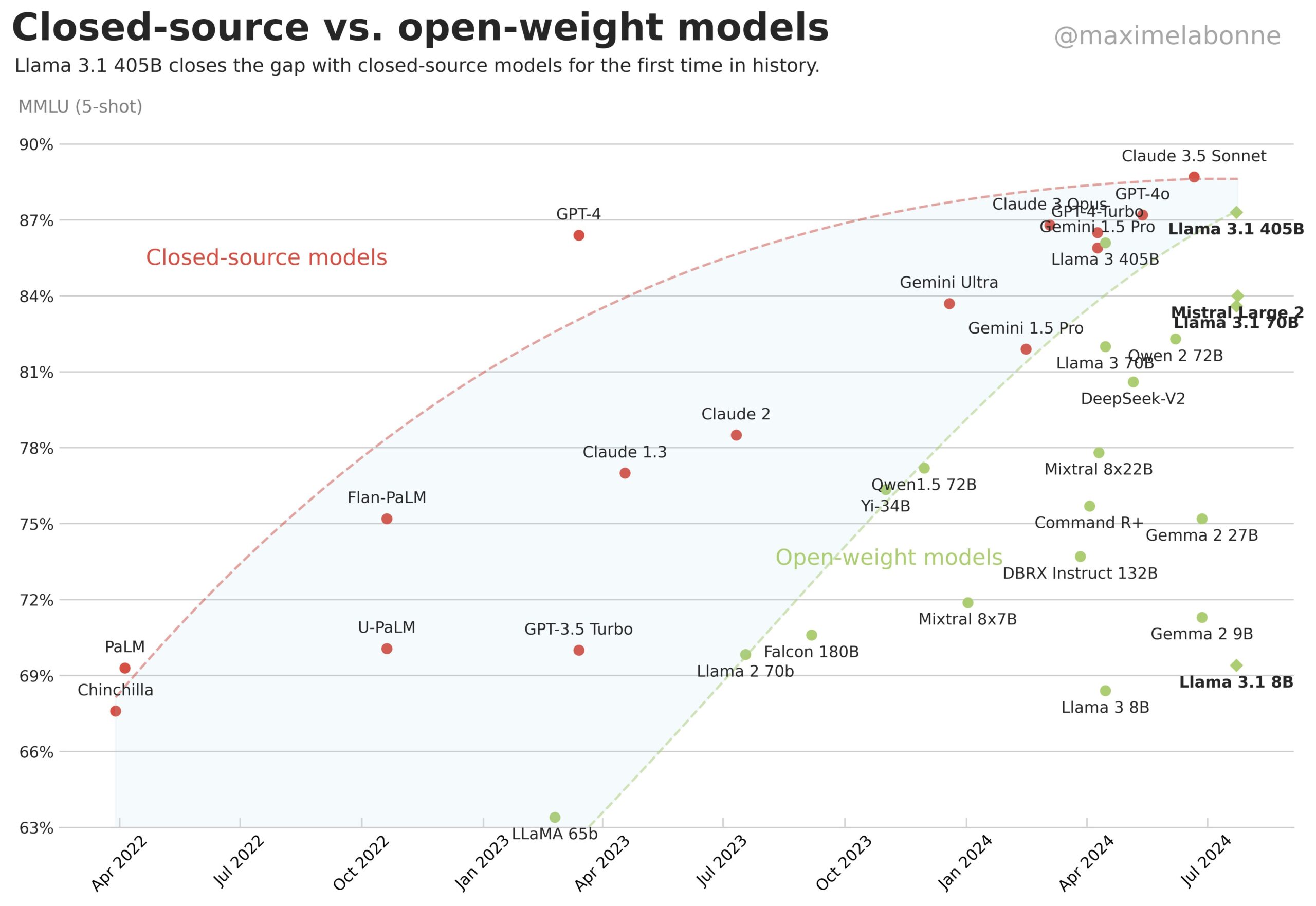

Die Entwicklungen der letzten zwei Jahre deuten darauf hin, dass große Sprachmodelle zwar effizienter werden, ihre Leistungsfähigkeit aber nicht signifikant zunimmt. LLM-Kritiker sehen darin ein Plateau der Technologie. Auch Bill Gates erwartet einen geringeren Sprung von GPT-4 zu GPT-5 als bei früheren Versionen.

Zudem scheinen sich die Fähigkeiten der Modelle anzugleichen. Sprachmodelle könnten so zu undifferenzierbaren Massenprodukten werden, die trotz enormer Entwicklungs- und Betriebskosten kaum Wettbewerbsvorteile bieten. Für hoch bewertete KI-Modellfirmen wie OpenAI und Anthropic ist das eine existenzielle Bedrohung.

Ein weiteres Indiz für die Plateau-These: OpenAI hat gerade bestätigt, dass der intern als GPT-4-Nachfolger gehandelte GPT-5 nicht mehr in diesem Jahr erscheinen wird - trotz der drohenden Konkurrenz durch Google Gemini 2.0.

Auch Anthropic soll sich mangels großer Fortschritte entschieden haben, eine bereits angekündigte Version 3.5 von Opus vorerst auf Eis zu legen. Stattdessen soll das Unternehmen die verbesserte Version von Sonnet 3.5 veröffentlicht haben, die sich auf agentische KI konzentriert.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.