Studie untersucht, welche Inhalte X-Accounts mit KI-Fake-Bildern verbreiten

In einer Studie wurde untersucht, wie viele Profile auf X (ehemals Twitter) KI-generierte Profilbilder verwenden und welche Inhalte sie verbreiten. Die Ergebnisse deuten auf gezielte Fehlinformationen hin, die aber wahrscheinlich keine große Wirkung haben.

Laut einer aktuellen Studie der Ruhr-Universität Bochum, des GESIS – Leibniz-Instituts für Sozialwissenschaften in Köln und des CISPA Helmholtz Center for Information Security in Saarbrücken. verwenden 0,052 Prozent der Profile auf X (ehemals Twitter) ein KI-generiertes Profilbild. Die False-Positive-Rate lag bei 1,4 Prozent.

Die Forscher analysierten fast 15 Millionen X-Accounts und fanden 7.723 Profile mit KI-generierten Porträtbildern. Diese Accounts zeigen ein auffälliges Verhaltensmuster: Sie haben durchschnittlich weniger Follower und folgen selbst weniger Accounts.

"Mehr als die Hälfte dieser Accounts wurden erst 2023 erstellt, teilweise hunderte innerhalb weniger Stunden - ein klares Indiz dafür, dass es sich nicht um echte Nutzer handelt", erklärt Hauptautor Jonas Ricker. Nach neun Monaten waren mehr als die Hälfte dieser Accounts von X gesperrt worden.

Trump, Corona und Ukraine als Hauptthemen

Aufgrund der angewandten Methode könnte es jedoch eine hohe Dunkelziffer von nicht erkannten KI-Fake-Porträts geben. Denn die Forscher konzentrierten sich auf die Erkennung von Bildern, die mit dem KI-Modell StyleGAN 2 erstellt wurden, das auch hinter der Website thispersondoesnotexist.com steht.

Das bedeutet wiederum, dass Bilder, die mit neueren und wahrscheinlich weiter verbreiteten KI-Systemen erstellt wurden, nicht erkannt wurden und daher nicht in der Statistik auftauchen.

Die Studie sollte daher nicht als aussagekräftig in Bezug auf den Anteil gefälschter KI-Profilbilder bei X angesehen werden, und noch weniger in Bezug auf den Anteil gefälschter Konten, die auch echte, keine oder illustrative Bilder verwenden können.

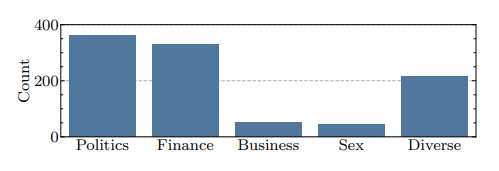

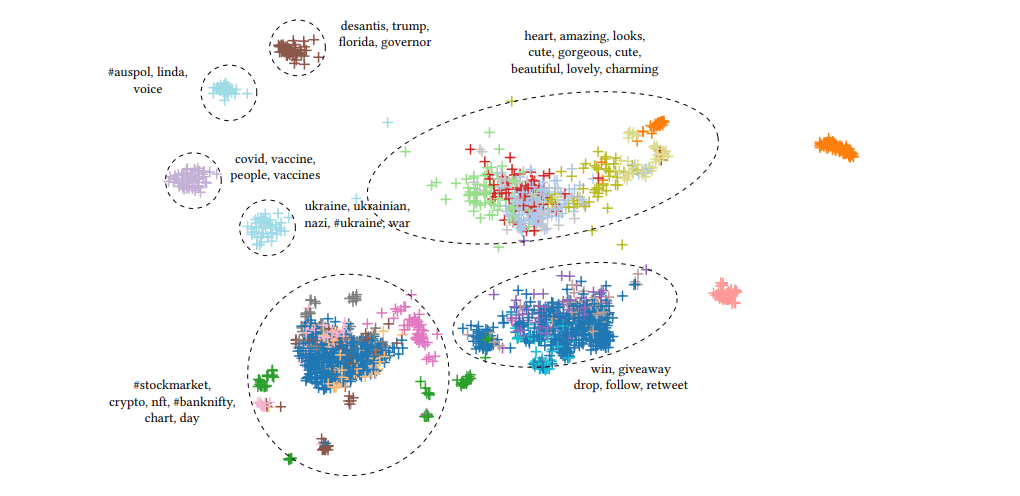

Interessant ist aber, was die erkannten Accounts mit KI-Fake-Bild bei X erzählen. Die manuelle Inhaltsanalyse von 1000 der Accounts mit KI-Fake-Bild zeigt klare thematische Schwerpunkte: Politik - häufig im Zusammenhang mit Trump -, Covid-19 und Impfungen sowie der Krieg in der Ukraine. Auch Lotterien und Finanzthemen wie Kryptowährungen tauchen häufig auf.

Laut Ricker ist es zwar spekulativ, aber naheliegend, dass einige der Accounts "gezielt zur Verbreitung von Desinformation und politischer Propaganda eingerichtet wurden". Die Tatsache, dass viele Fake-Image-Accounts massenhaft erstellt wurden und identische Metadaten aufweisen, deute darauf hin, dass sie Teil eines organisierten Netzwerks seien, heißt es in der Studie.

In einem nächsten Schritt wollen die Forschenden die Automatisierung von KI-Fake-Profilbildern ausbauen und neuere Muster in die Analyse einbeziehen.

Viel KI, wenig Wirkung?

Die Reichweite der geprüften Fake-Bild-Accounts haben die Forscher nicht untersucht. Die Tatsache, dass die untersuchten X-Accounts im Durchschnitt weniger Follower haben und weniger Accounts folgen, deutet jedoch darauf hin, dass sie auch nur eine geringe Reichweite erzielen.

Auch eine OpenAI-Studie zum Missbrauch von ChatGPT für politische Propaganda und Betrug zeigte, dass Social-Media-Accounts, die diese KI-generierten Botschaften verbreiteten, kaum Resonanz erhielten und damit wirkungslos waren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.