Hugging Face-Team will Open-Source-Alternative zu OpenAI Deep Research entwickeln

Ein Team von Forschern, darunter Hugging Face-Chefforscher Thomas Wolf, hat in nur 24 Stunden eine Open-Source-Nachbildung von OpenAIs Deep Research auf den Weg gebracht.

Das Team um Hugging Face-Mitgründer Thomas Wolf demonstriert mit seiner Entwicklung, wie schnell sich komplexe KI-Systeme zumindest im Ansatz nachbauen lassen. Laut Hugging Face Blog ist das Ziel, OpenAIs proprietäre KI-Technologie der Öffentlichkeit zugänglich zu machen, und insbesondere das OpenAI Deep Research zugrundeliegende Agent-Framework nachzubilden.

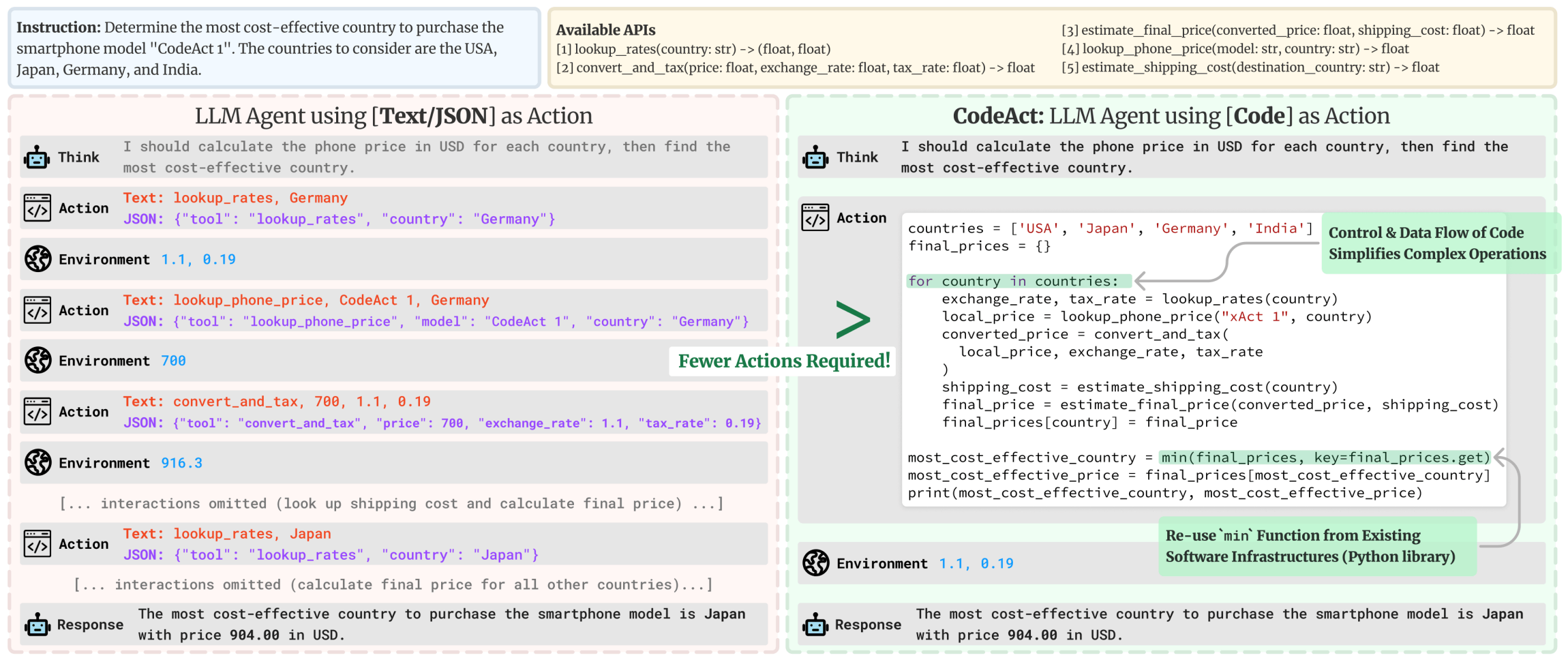

Ein wesentlicher Fortschritt gelang dem Team durch den Einsatz eines Code-Agenten. Im Gegensatz zu bisherigen Systemen drückt dieser Aktionen in Programmcode statt in JSON aus. Das Ergebnis: 30 Prozent weniger Verarbeitungsschritte und damit deutlich geringere Betriebskosten bei besserer Performance im Vergleich zu herkömmlichen LLMs.

Für die technische Umsetzung kombinierten die Entwickler zwei Hauptwerkzeuge aus dem Microsoft Agent-Research-Projekt Magentic-One: einen textbasierten Webbrowser für Recherchen und einen Text-Inspector zum Lesen verschiedener Dateiformate.

Komplexe Aufgaben im Praxistest

Die Leistungsfähigkeit des Systems zeigt sich im GAIA-Benchmark, der als einer der umfassendsten Tests für KI-Agenten gilt. Eine Aufgabe lautet etwa: "Welche Früchte aus dem Gemälde 'Embroidery from Uzbekistan' von 2008 wurden im Oktober 1949 beim Frühstück auf jenem Ozeandampfer serviert, der später als schwimmende Kulisse für den Film 'The Last Voyage' diente?"

Um diese Frage zu beantworten, muss der KI-Agent mehrere komplexe Schritte ausführen:

- Die Früchte im Gemälde identifizieren (Bildverarbeitung)

- Den im Film verwendeten Ozeandampfer ermitteln

- Dessen Frühstücksmenü von 1949 finden

- Die Informationen in der geforderten Form (Uhrzeigersinn, Pluralform) ausgeben

Bei solchen mehrstufigen Aufgaben erreichte Hugging Faces System 55,15 Prozent - deutlich mehr als Magnetic-One mit 46 Prozent, aber noch unter OpenAIs Deep Research mit 67 Prozent.

Parallel zur Hugging-Face-Implementierung sind bereits weitere Open-Source-Versionen entstanden, unter anderem von Entwicklern wie dzhng, assafelovic und Jina AI. Hugging Face plant, diese verschiedenen Ansätze zu vergleichen und zu dokumentieren.

Als nächsten Entwicklungsschritt kündigt das Unternehmen die Arbeit an GUI-Agenten an, die direkt mit Bildschirm, Maus und Tastatur interagieren können. Der Code ist bereits auf GitHub verfügbar, eine sporadisch funktionierende Live-Demo hier.

OpenAI Deep Research hat weiter Vorsprung

Das HF-Team räumt ein, dass bis zur vollen Parität mit OpenAIs Deep Research noch viel Arbeit nötig sei. Insbesondere die Browser-Nutzung und -Interaktion müsse verbessert werden, um über die aktuelle rein textbasierte Webinteraktion hinauszukommen.

Ein wesentlicher Unterschied dürfte sein, dass Hugging Face nur mit den am Markt verfügbaren Open-Source-Sprachmodellen arbeiten kann. OpenAI hat nach eigenen Angaben speziell für Deep Research ein eigenes o3-Modell mittels Reinforcement Learning auf anspruchsvolle Webaufgaben trainiert.

Dennoch rückt die Open-Source-Lösung zumindest im GAIA-Benchmark bereits in die Nähe von OpenAI - nach dem Deepseek-Hype ein weiteres Indiz dafür, dass es noch keine großen Gräben in der KI-Entwicklung gibt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.