Deepseeks KI-Dienste könnten Traum-Margen von mehr als 500 Prozent erreichen

Der chinesische KI-Anbieter Deepseek veröffentlicht detaillierte Statistiken zu seinen Diensten und zeigt, dass sich mit Sprachmodellen theoretisch hohe Gewinnmargen erzielen lassen - trotz viel geringer Preise als bei OpenAI.

Deepseek hat einen seltenen Einblick in die Betriebskosten und potenzielle Profitabilität seiner KI-Dienste gewährt. Laut den veröffentlichten Zahlen könnte das Unternehmen bei voller Monetarisierung seiner Dienste eine theoretische Gewinnmarge von 545 Prozent erreichen - trotz der Open-Source-Strategie.

Cleveres Ressourcenmanagement senkt Kosten

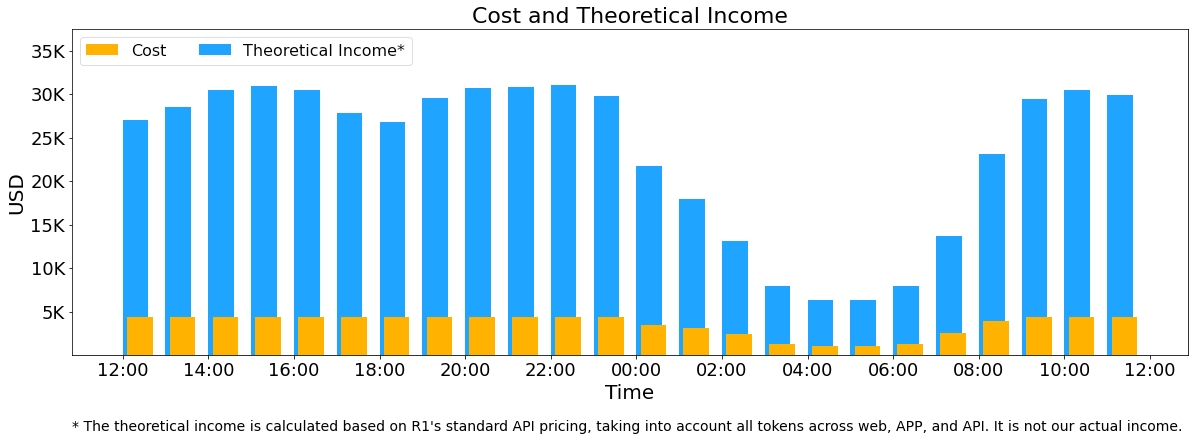

Die Berechnungen basieren auf einem 24-Stunden-Zeitraum, in dem Deepseeks Modelle insgesamt 608 Milliarden Input-Token und 168 Milliarden Output-Token verarbeiteten. Mehr als die Hälfte der Eingaben (56,3 Prozent) konnte dabei aus einem Cache bedient werden, was die Kosten erheblich senkt.

Um Ressourcen optimal zu nutzen, hat das Unternehmen zudem ein dynamisches System implementiert: Während der Spitzenzeiten am Tag werden Inferenzdienste auf allen Knoten bereitgestellt, in der Nacht bei geringerer Auslastung werden Ressourcen für Forschung und Training umgewidmet.

Die reine Hardware-Infrastruktur für diesen Betrieb kostete das Unternehmen nach eigenen Angaben 87.072 Dollar pro Tag. Dafür nutzt Deepseek durchschnittlich 226,75 Serverknoten mit jeweils acht H800-GPUs von Nvidia. Grundlage dieser Berechnung ist der angenommene Leasingpreis von zwei US-Dollar pro GPU pro Stunde.

Ein einzelner H800-Knoten verarbeitet durchschnittlich 73.700 Input-Token pro Sekunde beim Prefilling oder 14.800 Output-Token pro Sekunde beim Decoding. Die durchschnittliche Ausgabegeschwindigkeit liegt bei 20 bis 22 Token pro Sekunde.

Würde Deepseek alle verarbeiteten Token zum Preis seines Premium-Modells R1 abrechnen (0,14 Dollar pro Million Input-Token bei Cache-Treffern, 0,55 Dollar bei Cache-Misses und 2,19 Dollar pro Million Output-Token), käme das Unternehmen auf Tageseinnahmen von 562.027 Dollar.

Die tatsächlichen Einnahmen liegen jedoch deutlich darunter: Das Standardmodell V3 ist günstiger als R1, viele Dienste sind kostenlos nutzbar – lediglich API-Zugänge sind derzeit monetarisiert – und in der Nacht gelten Rabatte.

KI-Sprachmodelle als zunehmend standardisierte Ware

Die von Deepseek veröffentlichten Zahlen verdeutlichen, dass KI-Sprachmodelle theoretisch enorme Gewinnmargen bieten könnten. Gleichzeitig zeigt sich, wie schwierig es in der Praxis ist, diese Margen auch wirklich zu realisieren. Die Kombination aus Konkurrenzdruck, differenzierter Preisgestaltung und kostenlosen Diensten lässt die reale Rentabilität deutlich schrumpfen.

Die hohen theoretischen Margen sind besonders interessant im Kontext von OpenAIs jüngstem GPT-4.5, das trotz kaum messbarer Verbesserungen ein Vielfaches bisheriger Modelle - und speziell von Deepseeks-Modellen - kostet.

Die Zahlen von Deepseek stützen die These, dass aktuelle Sprachmodelle zunehmend zu Massenprodukten werden, bei denen der Premiumpreis nicht dem Mehr an Leistung entspricht. Das setzt westliche KI-Unternehmen wie OpenAI weiter unter Druck.

Dies könnte einer der Gründe sein, warum OpenAIs GTM-Manager Adam Goldberg kürzlich betonte, dass Erfolg im KI-Bereich die Kontrolle über die gesamte Wertschöpfungskette erfordert - von der Infrastruktur und den Daten bis hin zu den Modellen und Anwendungen. Da Sprachmodelle zunehmend zur Massenware werden, liegt der Wettbewerbsvorteil möglicherweise weniger in den Modellen selbst als vielmehr in der Fähigkeit eines Unternehmens, den gesamten Technologie-Stack zu integrieren und zu optimieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.