Google Deepmind stellt neue Roboter-KI-Modelle vor

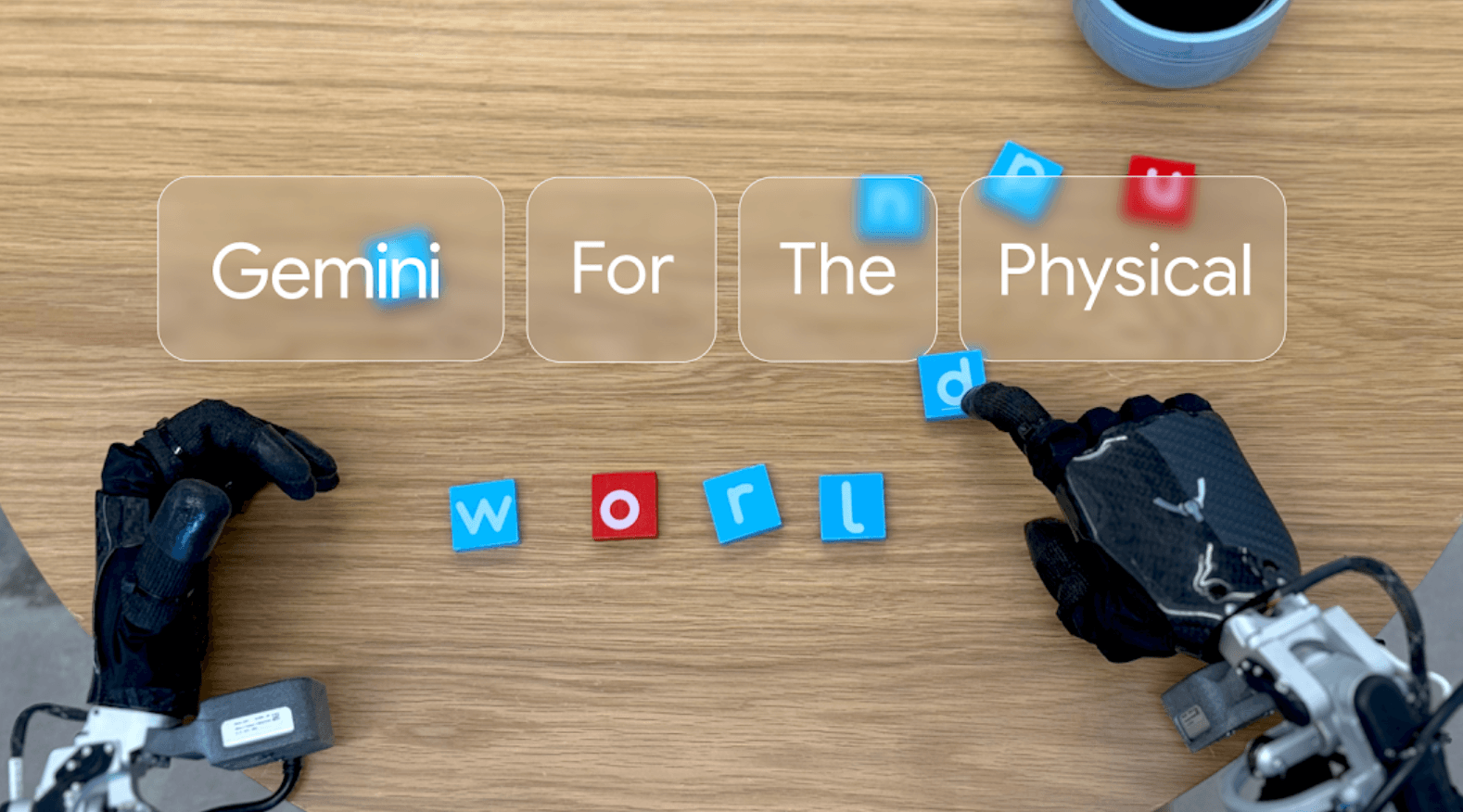

Google Deepmind hat laut eigenen Angaben zwei neue KI-Modelle entwickelt, die Robotern bessere Interaktionen mit der physischen Welt ermöglichen sollen. Beide Systeme basieren auf dem Sprachmodell Gemini 2.0.

Das erste Modell, Gemini Robotics, ist nach Angaben des Unternehmens ein fortschrittliches Vision-Language-Action-Modell (VLA), das speziell für die direkte Steuerung von Robotern entwickelt wurde. Dank der Gemini 2.0-Basis kann es natürliche Sprache in verschiedenen Sprachen verstehen und verarbeiten.

Gemini Robotics wurde speziell entwickelt, um KI-Fähigkeiten aus dem digitalen in den physischen Bereich zu übertragen. Das System kann laut Google Deepmind auch mit vollkommen neuen Situationen, Objekten und Umgebungen umgehen, die es während des Trainings nie gesehen hat.

Dafür überwacht es kontinuierlich seine Umgebung und passt seine Aktionen entsprechend an - etwa wenn ein Objekt aus dem Griff rutscht oder jemand einen Gegenstand verschiebt. Bei einem umfassenden Generalisierungs-Benchmark soll das System die Leistung anderer State-of-the-Art-Modelle mehr als verdoppelt haben.

Das Modell beherrscht nach Unternehmensangaben komplexe Manipulationsaufgaben wie Origami-Falten oder das Verpacken von Snacks in Ziploc-Beutel. Google Deepmind trainierte das System hauptsächlich auf der bi-arm Roboterplattform ALOHA 2, es kann jedoch auch andere Robotertypen steuern.

Google Deepmind hat das Modell hauptsächlich auf der bi-arm Roboterplattform ALOHA 2 trainiert, es kann jedoch auch andere Robotertypen steuern, darunter eine auf den in akademischen Laboren häufig verwendeten Franka-Armen basierende Plattform.

Verbessertes räumliches Verständnis

Das zweite Modell, Gemini Robotics-ER, erweitert laut Google Deepmind die Fähigkeiten um ein verbessertes räumliches Verständnis. Nach Angaben des Unternehmens erreicht es bei der Robotersteuerung eine zwei- bis dreimal höhere Erfolgsrate als das reine Gemini 2.0.

Robotics-ER kann durch die Kombination von räumlichem Denken und Programmierfähigkeiten spontan neue Funktionen implementieren. So kann es etwa beim Anblick einer Kaffeetasse intuitiv einen geeigneten Zwei-Finger-Griff zum Anheben am Henkel und eine sichere Annäherungsbahn berechnen.

Google Deepmind hat zudem ein Framework entwickelt, mit dem datengesteuerte "Verfassungen" - Regeln in natürlicher Sprache - erstellt werden können, um das Verhalten von Robotern zu steuern. Der neue ASIMOV-Datensatz soll Forschern helfen, die Sicherheitsimplikationen robotischer Aktionen in realen Szenarien rigoros zu messen.

Google Deepmind arbeitet bei der Entwicklung mit verschiedenen Partnern zusammen, darunter Apptronik für humanoide Roboter sowie Boston Dynamics und Agility Robots als Testpartner für Gemini Robotics-ER. Zur Bewertung der Sicherheit wurde ein neuer Datensatz namens ASIMOV veröffentlicht.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.